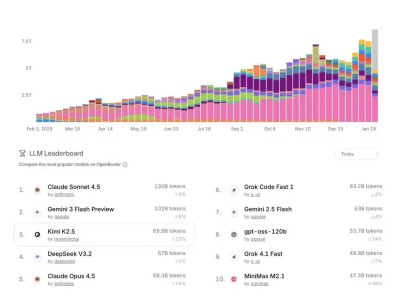

人工智能语言模型领域迎来一项突破性进展,国际研究团队通过创新训练方法显著提升了模型生成效率。该成果由多国科研人员联合完成,相关论文已发布于学术预印本平台,编号为arXiv:2512.14681v1。这项研究针对传统模型逐词生成的低效问题,开发出名为"雅可比强制训练"的技术方案,在保持输出质量的同时实现生成速度数倍提升。

现有AI语言模型普遍采用自回归架构,如同谨慎的书写者必须逐字完成句子。尽管扩散模型等并行生成技术已现雏形,但始终面临质量与效率的矛盾困境。研究团队发现,传统模型改造为并行版本时,训练数据分布的剧烈变化导致性能下降,类似要求中文母语者直接用英文思维创作。

创新方法的核心在于构建自修正学习机制。模型首先尝试并行预测多个词语,即使初始结果存在偏差,也会通过"雅可比解码"技术持续优化。这个过程类似画家创作:先勾勒草图轮廓,再逐步完善细节。研究团队特别设计了渐进式噪声注入策略,初期仅引入少量干扰信息,随着训练深入逐步增加复杂度,帮助模型稳步提升处理能力。

注意力机制的革新是另一关键突破。新型"噪声感知因果注意力"允许模型在局部范围内灵活交互信息,同时维持整体因果逻辑。这种设计既保留了传统模型的推理特性,又突破了单向信息流的限制。配合渐进式蒸馏训练策略——先在小规模数据上掌握基础能力,再逐步扩展至复杂任务——模型最终实现从简单到复杂的平滑过渡。

实验数据显示显著性能提升。在编程基准测试Humaneval中,新模型速度提升3.8倍,代码准确率维持在83.5%;数学问题求解任务GSM8K和MATH分别实现3.5倍和3.65倍加速,正确率分别达91.4%和77.4%。当结合拒绝回收和多块解码技术后,部分配置下速度提升接近理论极限的4倍,相当于将4秒任务压缩至1秒完成。

拒绝回收机制创造性地利用了模型生成过程中的中间结果。那些被初步筛选的高质量词语片段不会直接丢弃,而是存入候选池供后续调用。这种设计类似作家保存灵感片段,在后续创作中随时调用。多块解码技术则引入并行工作模式,模型同时维护多个预测区块,通过动态调整确保最终输出的准确性和流畅性。

技术验证覆盖多个复杂场景。在代码生成任务中,模型不仅能快速输出完整函数,还能保持语法正确性和逻辑完整性。数学推理测试表明,新方法显著提升了多步骤复杂问题的解决能力,尤其在需要中间验证的场景中表现突出。消融实验证实,渐进式噪声调度对性能提升贡献最大,噪声感知注意力机制则增强了模型稳定性。

硬件适配性研究显示,高端GPU的计算优势得到更充分发挥。在NVIDIA H200和B200平台上,模型可并行处理更多预测任务,效率提升幅度较消费级显卡更为显著。这为未来在专业计算环境中部署大规模语言模型提供了重要参考,同时也提示中小型设备可能需要针对性优化方案。

该成果对实际应用产生深远影响。AI编程助手可实现多行代码同步生成,显著减少开发者等待时间;写作辅助工具能够快速提供结构完整的段落建议;智能问答系统则可即时呈现详细解答。研究团队特别指出,渐进式训练方法降低了模型升级成本,现有大型语言模型通过少量额外训练即可获得并行生成能力。

尽管在创造性文本生成等任务中仍有改进空间,但这项研究为语言模型发展开辟了新路径。其核心思想——通过自修正学习提升并行处理能力——可能启发更多自监督学习方法的诞生。分阶段训练策略也为资源有限的研究机构提供了可行方案,有助于推动技术普惠化发展。完整技术细节可通过学术编号查阅原始论文,其中包含详尽的实验设置和性能对比数据。