国产大模型发展进程中,DeepSeek-R1的发布无疑是一个重要里程碑。这款模型一经问世,便迅速登上全球舞台核心位置,开启了国产大模型开源的新纪元。如今,在DeepSeek-R1发布一周年之际,开发者社区因一个新发现而沸腾起来。

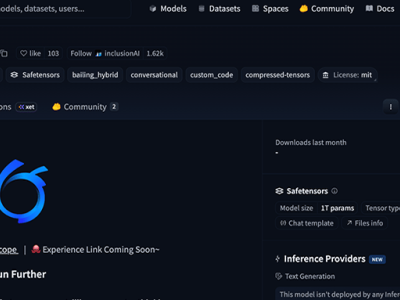

近日,DeepSeek的一个存储库进行了更新,其中明确引用了一个全新的“model 1”模型。这一情况引发了众多猜测,不少人认为它极有可能就是备受期待的DeepSeek-R2。在DeepSeek的开源项目FlashMLA库代码片段中,不仅引用了“model 1”,还伴随着针对KV缓存的新优化,以及对576B步幅的稀疏FP8解码支持。FlashMLA作为DeepSeek的优化注意力内核库,此前为DeepSeek-V3和DeepSeek-V3.2-Exp模型提供了有力支持,此次出现的新模型相关内容,无疑是一个重要信号。

进一步查看项目代码,大约有28处提到了“model 1”。在推理层代码中提及新模型ID,通常意味着新模型(代号为Model1)会复用或改进现有的MLA架构。这表明DeepSeek团队正在积极推进新模型的推理适配工作,同时也凸显了FlashMLA作为核心推理优化库的重要地位依旧稳固。

回顾过去,DeepSeek在发展过程中并非一帆风顺。本月15日,国外媒体报道称,去年在研发新一代旗舰模型时,DeepSeek在算力方面遇到了一些阻碍。不过,DeepSeek迅速调整策略,取得了积极进展,并且正筹备在“未来几周内”推出这款新模型。

在DeepSeek-R1发布一周年这个特殊节点,HuggingFace发文阐述了DeepSeek如何改变了开源AI领域。R1并非当时性能最强的模型,但它通过独特的方式降低了三重壁垒,从而产生了深远影响。

首先是技术壁垒。R1公开分享了推理路径和后训练方法,将曾经封闭在API背后的高级推理能力,转化为可下载、可蒸馏、可微调的工程资产。这使得许多团队无需从头训练大模型,就能获得强大的推理能力,推理开始像可复用的模块一样,在不同系统中广泛应用。这一转变在中国算力受限的环境中意义重大,也促使行业重新思考模型能力与计算成本之间的关系。

其次是采用壁垒。R1以MIT许可证发布,使用、修改和再分发变得简单直接。原本依赖闭源模型的公司开始直接将R1投入生产,蒸馏、二次训练和领域适应成为常规工程工作。随着分发限制的解除,模型迅速扩散到云平台和工具链中,社区讨论的重点也从“哪个模型分数更高”转变为“如何部署、降低成本并集成到实际系统中”,R1逐渐成为可复用的工程基础。

最后是心理层面的变化。当问题从“我们能做这个吗?”转变为“我们如何做好这个?”时,许多公司的决策发生了改变。对于中国AI社区而言,这是一个难得的获得全球持续关注的时刻,对长期被视为跟随者的生态系统来说至关重要。这三个壁垒的降低,共同让生态系统具备了自我复制的能力。

回顾DeepSeek-R1诞生这一年,在它出现之前,大模型的进化方向几乎只有增大参数规模、增加数据量等。而R1的起点是一个关键问题:模型真的在思考吗?它并非追求让模型回答得更快,而是刻意放慢速度,注重推理链条的展开和中间状态的显式表达。

从技术角度看,DeepSeek-R1的关键突破在于一整套系统性设计。在训练目标上,传统SFT/RLHF体系以最终答案的“正确性”为唯一目标,而R1引入了更细粒度的信号。其训练数据不追求百科全书式的覆盖,而是高度聚焦于数学与逻辑推导、可验证的复杂任务,强调过程而非答案,这使得R1在数学、代码、复杂推理等方面呈现出“跨尺度跃迁”。

R1并非简单地“更会写CoT”,而是在内部形成了稳定的推理状态转移结构,让推理成为内生能力,而非外挂。DeepSeek-R1的出现带来了多方面改变,它改变了对“对齐”的理解,让人们意识到对齐不仅是价值对齐,也是认知过程的对齐;改变了对开源模型的想象空间,证明开源模型在推理维度可以成为范式定义者,激发了社区对“Reasoning LLM”的探索热情;还改变了工程师与模型的协作方式,使人类从提问者转变为合作者。