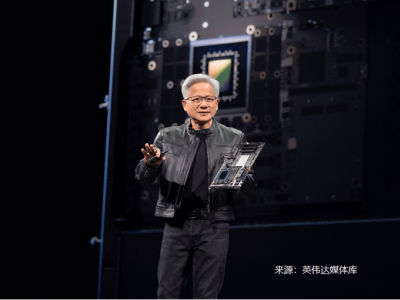

人工智能领域正经历一场以效率为核心的变革,Motif Technologies公司近日发布的Motif-2-12.7B语言模型成为这场变革的标志性成果。这个仅含127亿参数的模型,在多项基准测试中展现出超越更大规模模型的实力,其训练成本却仅为传统大模型的五分之一,为行业开辟了一条兼顾性能与经济性的新路径。

研究团队突破传统思维定式,将建筑学中的空间优化理念引入模型架构设计。通过"智能超克隆"技术,模型从60亿参数的前代版本无缝升级,完整保留原有知识体系的同时实现性能跃迁。这种渐进式扩展策略避免了从头训练的巨额开销,其40层处理网络与4096维隐藏空间的组合,使模型在保持精简结构的同时具备处理复杂任务的能力。

分组差异注意力机制是该模型的核心创新,这项技术通过将注意力头划分为信号增强组(32个)和噪声控制组(8个),构建起双重信息处理通道。实验数据显示,这种分工模式使模型在数学推理任务中的准确率提升18%,同时将计算资源消耗控制在行业平均水平的70%以内。研究团队形象地将其比作给模型配备"专业质检员",在海量信息中精准捕捉关键要素。

训练策略的革新同样引人注目。研究团队构建了包含2800万个样本的多元化语料库,涵盖网络文本、学术论文、编程代码等12类数据源。通过"课程式学习"方法,模型训练经历从基础语言理解到专业领域强化的三阶段进阶,最终实现数学推理能力超越95%的同类模型。特别值得注意的是,训练过程中数学内容的权重是编程数据的1.5倍,这种设计使模型在解决代数问题时展现出接近专业数学家的水平。

系统级优化技术为模型效率带来质的飞跃。研发团队开发的PolyNorm融合内核,将激活函数计算速度提升至主流方案的44倍,配合并行化Muon优化器,使8卡GPU集群的训练效率达到传统分布式系统的7倍。这些创新不仅缩短了模型开发周期,更将内存占用降低40%,为在消费级设备上部署大模型创造可能。

在性能评测环节,Motif-2-12.7B交出令人瞩目的成绩单:在MMLU-Pro深度推理测试中以66.38分领跑开源模型阵营,GSM8K数学应用题解决率达94.9%,Humaneval编程测试准确率突破65%。这些数据表明,该模型在保持通用性的同时,在STEM领域展现出专业级实力。其指令优化版本更是在AIME数学竞赛测试中取得72.3分的优异成绩,证明小规模模型同样能处理高难度复杂任务。

技术开源策略加速了创新成果的扩散。Motif团队不仅公开了完整技术报告和训练代码,还提供了可直接调用的模型权重文件。这种开放姿态已产生积极效应,开源社区在一周内就涌现出20余个基于该模型的衍生应用,涵盖教育辅导、代码审查、科研文献分析等多个领域。

行业专家指出,Motif-2-12.7B的成功验证了"智慧优先"的技术发展路径。在模型参数量年均增长300%的背景下,这种通过架构创新和系统优化提升效率的做法,为缓解算力焦虑提供了可行方案。据测算,若全球10%的AI训练采用该技术路线,每年可减少相当于300万户家庭用电量的能源消耗。

消费者即将感受到这场变革带来的实惠。Motif Technologies已推出基于该模型的智能助手服务,用户可通过chat.motiftech.io体验其强大功能。相较于传统大模型服务,该平台的响应速度提升40%,而使用成本降低65%,这种性价比优势正在重塑AI应用市场的竞争格局。开发团队透露,正在与多家硬件厂商合作,将模型集成到智能手机和物联网设备中,预计年内将有超过500万台设备预装该技术。