在软件开发领域,单元测试维护一直是保障代码质量的关键环节,但这项工作往往繁琐且复杂。近期,一项由西伯利亚神经网络公司牵头,联合T-Technologies和新西伯利亚国立大学共同完成的研究,为人工智能在这一领域的应用潜力提供了全新视角。研究团队开发的TAM-eval评估体系,首次系统性地衡量了大型语言模型处理单元测试维护任务的真实能力,相关成果已发表于计算机科学领域权威期刊。

该研究以程序员日常工作中“数字大厦安全检查”的类比展开:单元测试如同大厦的安全系统,需持续检查每个功能模块是否正常运转。随着软件规模扩大,测试代码的维护成本急剧上升——不仅要修复损坏的测试,还要为修改后的代码更新测试方案,甚至为新增功能从头编写测试。研究团队指出,尽管人工智能在生成新测试代码方面已展现潜力,但在处理这些动态维护任务时仍显稚嫩,类似“能按模板完成检查流程,却难以应对突发故障”的职场新人。

为精准评估人工智能的测试维护能力,研究团队构建了覆盖真实场景的“综合技能考核”。考核分为三大环节:第一环节要求人工智能从零开始创建测试代码,包括完全独立设计、补充遗漏测试和恢复丢失测试三种任务;第二环节聚焦修复损坏测试,涵盖语法错误、执行错误、覆盖率不足和效率低下四类典型故障;第三环节则模拟代码更新后的测试适配,需人工智能判断哪些原有测试需保留、修改或重写。这些任务均基于Python、Java和Go语言项目中提取的1539个真实测试样本,确保评估贴近实际开发需求。

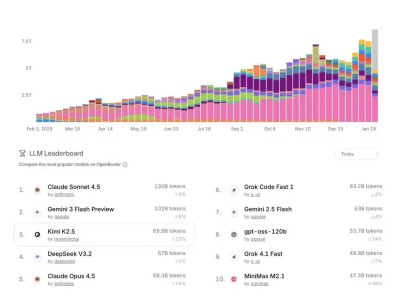

实验结果显示,人工智能在不同任务中的表现差异显著。在创建测试环节,从零开始设计的任务成功率最高,因无需考虑与现有代码的兼容性;而补充和恢复测试时,模型需分析已有代码结构,准确率明显下降。修复测试环节中,人工智能仅能较好处理语法错误(占故障4.07%),但对占比47.37%的执行错误(如缺少库导入)和30.74%的效率问题(如遗漏关键验证步骤)则力不从心。更新测试环节被证明最具挑战性,即使最先进的模型也难以准确理解代码变更逻辑,导致测试策略调整失误。

评估标准的设计是该研究的另一创新点。团队摒弃了传统“对比标准答案”的方法,转而采用三个实际效果指标:通过率(测试代码能否运行)、测试覆盖率改善(能否检查更多代码路径)和突变测试覆盖率改善(能否发现代码中人为引入的错误)。数据显示,最先进模型的通过率仅42.3%,突变测试覆盖率改善普遍低于12%,表明生成的测试常流于表面,缺乏深度验证能力。

实验还揭示了编程语言对人工智能表现的影响。Go语言因语法简洁、类型系统严格,成为模型最易处理的语言;Java虽在通过率上表现较好,但测试覆盖率和突变测试覆盖率改善较弱,反映“能运行”不等于“高质量”。不同模型在代码风格上差异明显——部分模型倾向生成简洁测试,另一些则产出冗长套件,这与其训练策略和优化目标密切相关。

研究团队强调,该工作的核心价值在于建立了完全自动化的评估框架。传统方法依赖专家准备标准答案,难以适应测试维护中“同一功能多种测试方式”的特点;而新框架通过测量实际执行效果,能更客观地判断测试质量。为确保数据代表性,团队开发了自动化筛选流程,从开源项目中选取近期的测试样本,避免模型因训练数据泄露而“作弊”。这一模块化框架还支持扩展新语言和评估指标,为后续研究奠定基础。

尽管当前人工智能在测试维护中仍需人工干预,但研究已指出改进方向:通过增强代码上下文理解、优化错误反馈机制和整合编译器信息,模型有望提升复杂任务的处理能力。对于开发者而言,这意味着未来可能借助AI工具减轻重复性测试工作,集中精力解决核心逻辑问题;对于企业,研究提供的模型性能对比和失败模式分析,可辅助选择适合自身需求的测试维护方案。

在问答环节,研究团队进一步解释了TAM-eval的独特性。该框架不仅包含大量真实项目样本,还通过“沙箱环境”隔离测试任务,模拟真实开发中的多次尝试机制,允许模型根据错误反馈优化结果。这种设计更贴近程序员实际工作流程,也解释了为何模型表现随尝试次数增加而提升——它们确实在“从错误中学习”。