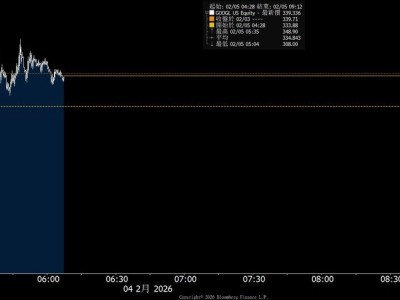

随着智谱华章、MiniMax等企业相继冲刺港交所与科创板,中国人工智能产业正加速进入商业化落地与规模化应用的新周期。然而,在资本市场的热闹背后,国产芯片产业仍面临严峻挑战——英伟达构建的CUDA生态壁垒,让国内企业在算力竞争中陷入被动。近期部分GPU企业股价冲高回落,折射出市场对技术自主性与商业可持续性的深层忧虑。

在应用层面,中国AI展现出的爆发力令世界瞩目。千问、智谱GLM等模型在基准测试中比肩国际顶尖水平,DeepSeek、豆包等应用日活突破千万量级,AI技术已深度融入金融、制造、教育等关键领域。但支撑这场变革的算力底座,却高度依赖海外技术体系。据行业数据显示,全球最大开源模型社区Hugging Face上的200万个模型中,能流畅运行于国产GPU的不足0.1%,99%的中国AI应用仍基于英伟达架构开发。

英伟达的生态优势源于二十年积累的技术闭环。从底层驱动到上层开发框架,CUDA生态整合了数百万优化算子、工具链和开发者社区,形成难以复制的技术护城河。某芯片企业技术负责人坦言:"迁移成本不仅是代码重写,更是整个研发体系的重构。"更严峻的是,AI模型架构的快速迭代让芯片设计面临"刚投产即落后"的风险,而英伟达凭借与前沿研究的深度绑定,总能率先捕捉技术转向。

这种生态断层导致国产芯片陷入恶性循环:因用户规模有限导致迭代缓慢,进而影响产品竞争力;而高昂的研发与流片成本又推高芯片售价,形成"性能追赶-成本高企-应用受限"的闭环。某投资机构负责人指出:"客户真正关心的是模型能否无缝迁移、开发成本是否可控,而非单纯的性能参数对比。"这种困境使得多数企业采购国产芯片仅作为备选方案。

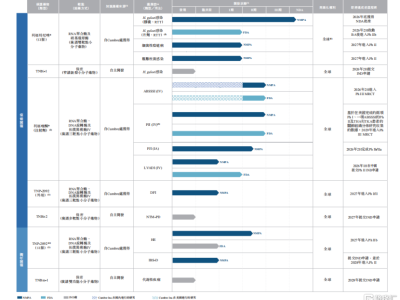

转机出现在AI算力需求的结构性转变中。行业共识逐渐形成:AI发展重心正从训练阶段转向推理阶段,后者对实时性、能效比和成本控制提出全新要求。这为国产芯片开辟了差异化竞争路径——通过与模型层的深度协同优化,突破生态壁垒。燧原科技CEO赵立东强调:"推理时代的算力需求更分散、更持续,这正是国产芯片建立技术联盟的契机。"

全栈协同成为破局关键。不同于传统的硬件适配,新一代合作模式要求从芯片架构设计到模型部署的全链条优化。曦望科技CEO王勇透露,国内大模型企业已探索出MoE架构、EP/PD分离部署等特色技术路径,这倒逼芯片厂商必须快速适配新特性。阶跃星辰去年发起的"模芯生态创新联盟",联合近十家芯片企业建立联合优化机制,通过共享技术参数、协同开发工具链等方式提升算力利用率。

这种双向奔赴正在改写竞争规则。某头部大模型企业技术总监表示:"我们开始主动向国产算力平台迁移,虽然初期效率损失约15%,但通过联合优化,三个月内就将性能差距缩小至5%以内。"这种深度协作模式不仅降低了迁移成本,更催生出适合本土场景的解决方案。例如针对中文语境优化的编译工具,已使特定模型推理效率提升30%以上。

当前,国产芯片企业正形成两种发展路径:创业公司聚焦垂直场景深度优化,互联网大厂则推进全栈技术整合。但无论哪种模式,核心目标都是通过规模应用摊薄成本,最终实现AI技术的普惠化。这场生态重构战役没有速胜可能,需要芯片厂商、模型企业和行业用户持续投入,在技术迭代中建立正向循环。能否将短期适配转化为长期协同机制,将成为决定中国AI算力自主化进程的关键变量。