苹果公司的科研团队最近公布了一项关于大型语言模型(LLMs)的深入研究,对传统认知中的LLMs能力提出了深刻质疑。这项研究揭示,即便LLMs融入了复杂的自我反思机制,它们在高复杂度问题面前仍显得力不从心,无法展现出普遍的推理能力。

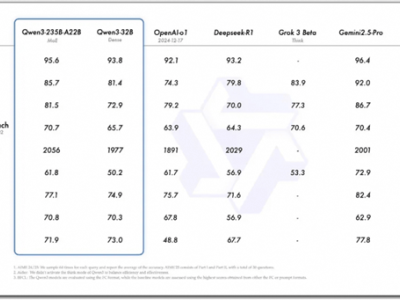

研究发现,LLMs在处理问题时的表现存在一个明显的分界点。面对低复杂度的问题,LLMs的表现优于逻辑推理模型(LRMs)。然而,当问题复杂度上升到中等水平时,LRMs开始占据优势。而在高复杂度的问题面前,两者都显得无能为力。这一发现表明,LLMs在处理复杂逻辑时的局限性不容忽视。

不仅如此,LLMs在执行精确计算时也显得捉襟见肘。甚至在处理一些简单问题时,LLMs也会出现“过度思考”的现象,导致效率低下。这一发现进一步加剧了人们对LLMs能力的担忧。

纽约大学的Gary Marcus教授对此表示,LLMs并不能完全替代那些经过精心设计的传统算法。他认为,通往通用人工智能(AGI)的道路远比想象中更为艰难。苹果的这项研究无疑为这一观点提供了有力的支持。

研究还指出,LLMs在解决结构性问题时的表现同样不尽如人意。例如,在解决汉诺塔问题时,LLMs的表现令人失望。即便直接给出标准算法,LLMs也难以正确执行。这一发现再次证明了LLMs在特定问题上的不可靠性。

尽管LLMs在某些领域确实展现出了其独特的优势,但这项研究提醒我们,它们并非解决所有问题的万能钥匙。在未来的研究和应用中,我们需要更加理性地看待LLMs的能力,避免过度依赖和夸大其效果。