近日,阿里巴巴通义实验室在人工智能领域迈出了重要一步,推出了开源的多模态推理模型HumanOmniV2。这一创新之举,标志着AI在理解人类复杂意图和情感方面取得了显著进展。

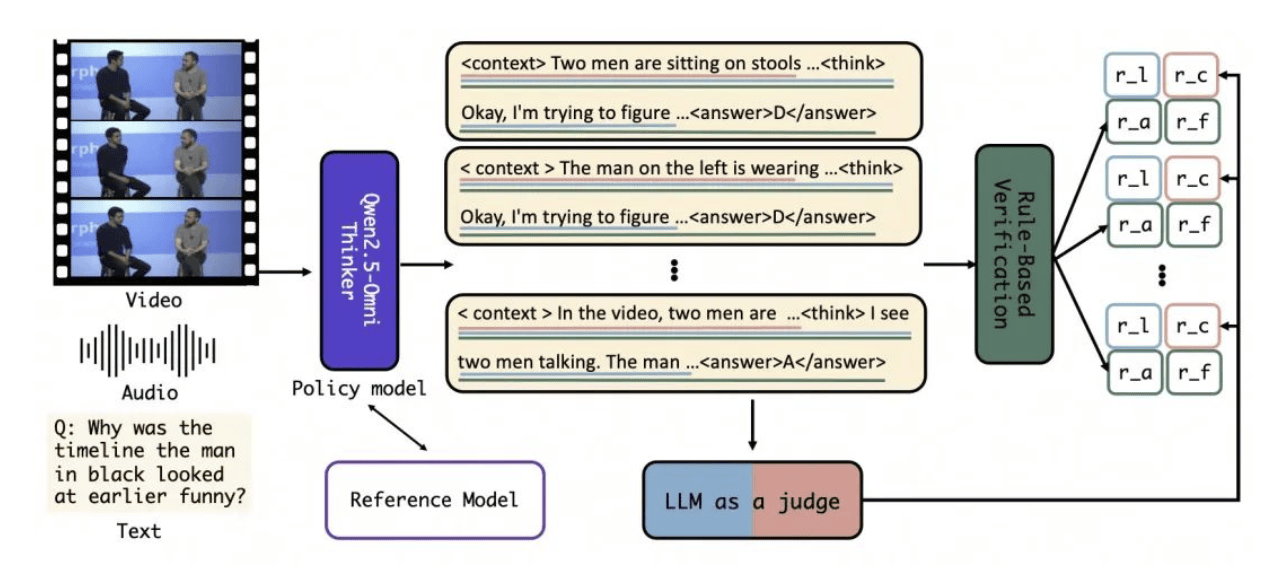

HumanOmniV2的核心优势在于其强大的多模态信息处理能力。通过引入强制上下文总结机制、大模型驱动的多维度奖励体系,以及基于GRPO的优化训练方法,该模型能够全面理解图像、视频、音频中的隐藏信息,有效规避了全局上下文理解不足和推理路径简单的问题。这一特性使得HumanOmniV2在生成最终答案前,能够先输出一个标签内的上下文概括,为后续的推理过程提供坚实的基础。

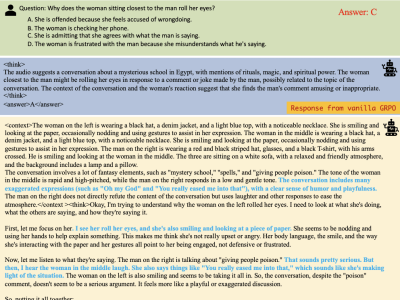

在实际应用中,HumanOmniV2展现出了惊人的推理能力。例如,在回答“女人为什么翻白眼”的问题时,该模型能够结合视频、音频等信息,准确判断出翻白眼是对潜在敏感话题的夸张、俏皮反应,而非对其他人表示不满。这种能力,无疑为AI在理解人类“话外音”方面提供了新的可能。

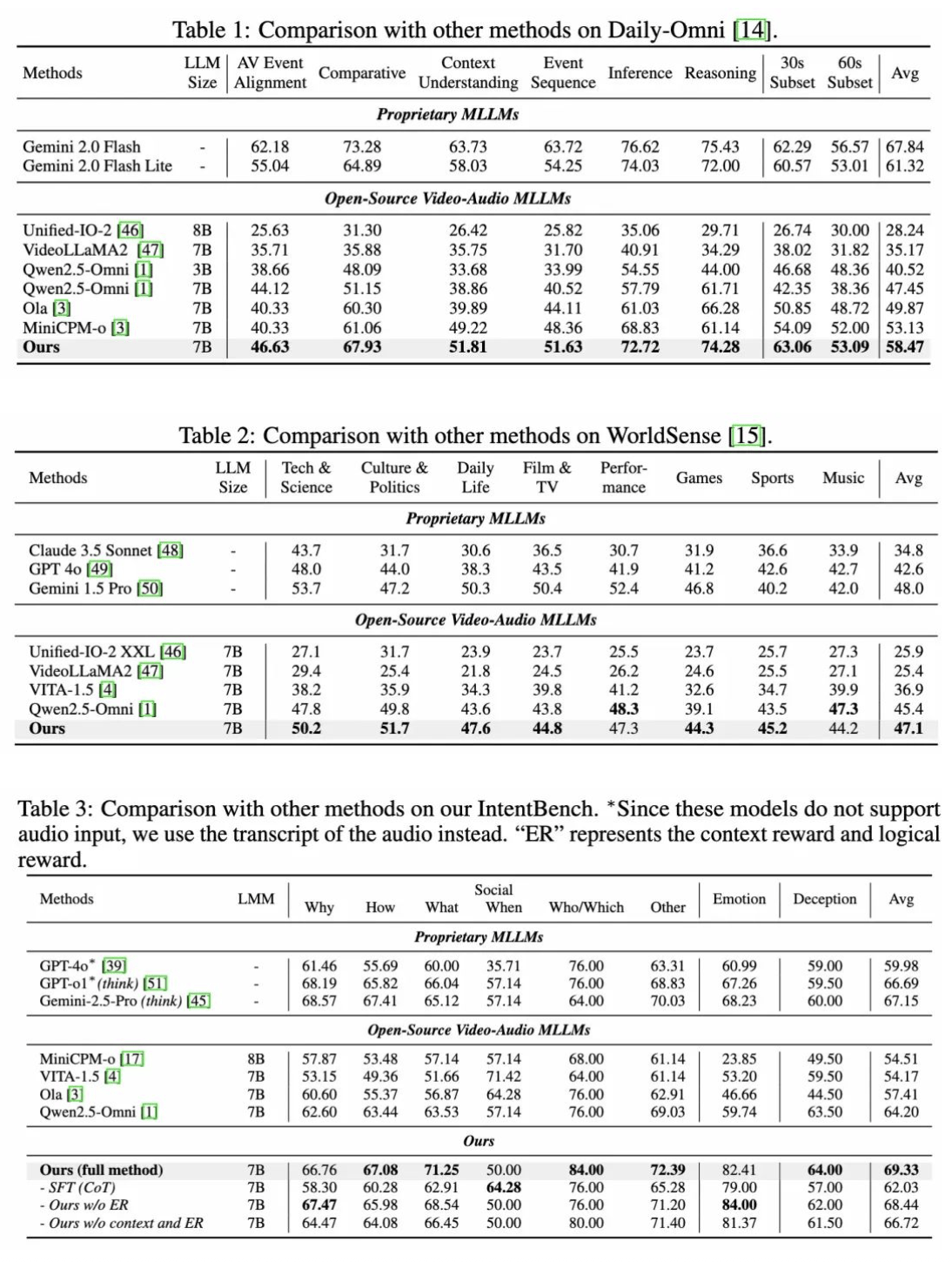

为了验证HumanOmniV2的性能,阿里巴巴通义团队还推出了包含633个视频和2689个相关问题的评测基准IntentBench。在这一基准上,HumanOmniV2的准确率高达69.33%,充分展示了其强大的推理能力。

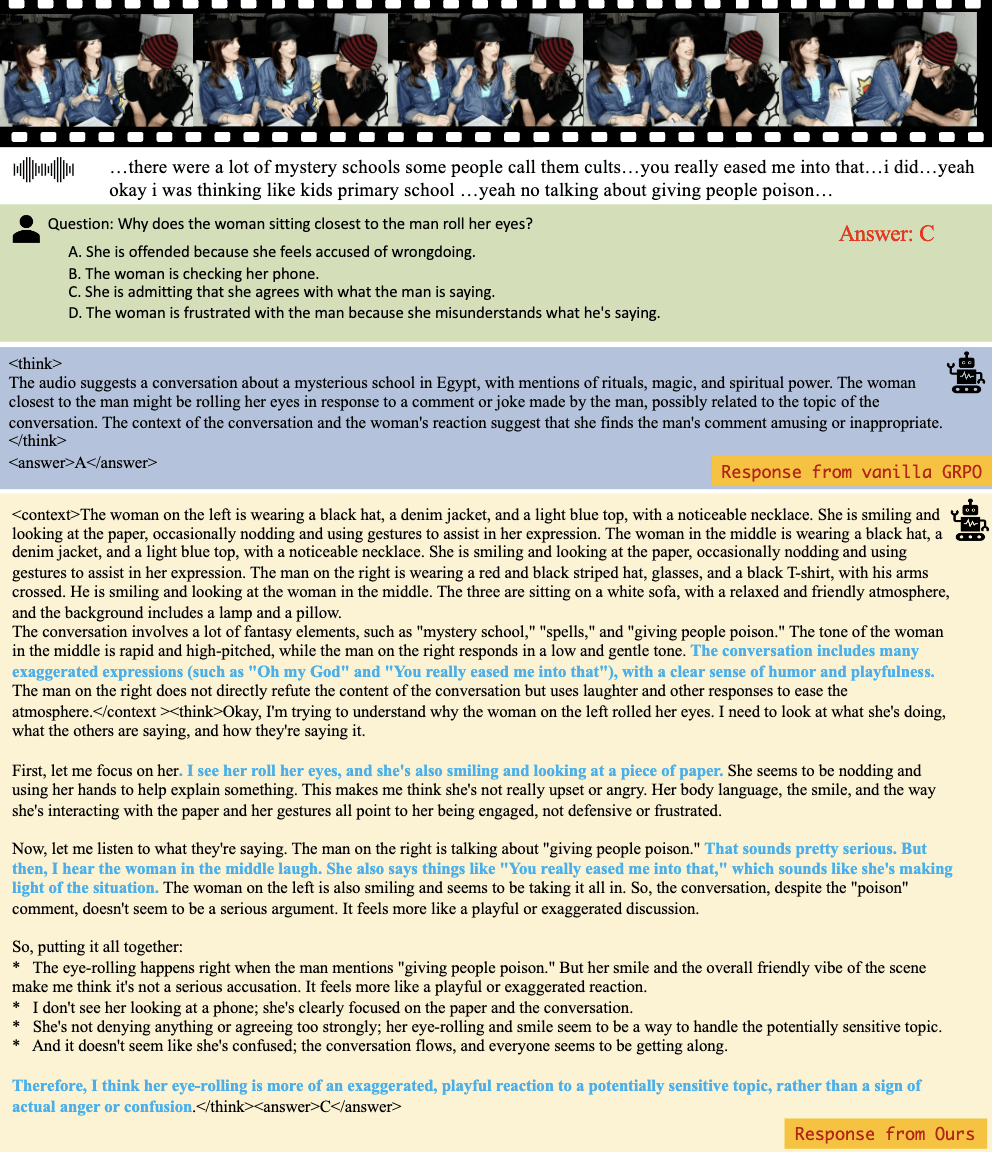

HumanOmniV2的推理过程不仅依赖于文本信息,还充分结合了视觉、听觉等多模态线索。在判断视频中人物情绪或关系时,该模型能够捕获更为细粒度的视频和音频信息,如语气、表情、肢体动作等,从而得出更为准确的结论。例如,在判断视频中男子的主要情绪时,HumanOmniV2能够结合人物的叹息、紧张表情,判断出他除了愤怒还处于无奈状态,而基于GRPO的模型则仅给出了愤怒的回答。

值得注意的是,HumanOmniV2的成功并非偶然。为了克服多模态推理模型存在的上下文理解不足和推理路径简单等问题,阿里巴巴通义团队进行了大量的研究和改进。他们引入了大模型驱动的多维度奖励机制,包括上下文奖励、格式奖励、准确性奖励和逻辑奖励,以确保模型能够准确理解多模态上下文信息,并进行深度逻辑推理。

他们还开发了一个全模态推理训练数据集,融合了图像、视频和音频等任务的上下文信息,为模型的训练提供了丰富的数据支持。同时,推出的IntentBench基准测试,也为评估模型性能提供了有效的手段。

HumanOmniV2的推出,无疑为AI在理解和建模人类复杂意图方面提供了新的参考。这一创新成果,不仅展示了阿里巴巴通义团队在人工智能领域的深厚实力,也为未来的AI发展开辟了新的道路。