近期,英伟达研究院携手佐治亚理工大学的研究团队,在学术界投下了一枚震撼弹。他们在一篇全新论文中提出了一个颠覆性的观点:在未来的AI智能体领域,小语言模型(SLM)或将取代庞大复杂的大型语言模型(LLM),成为主导力量。

这一非传统见解的核心支撑点有三:首先,SLM在处理AI智能体面临的诸多重复且专一的任务时,已展现出足够的实力;其次,SLM天然适配智能体系统的架构,其灵活性与集成性远超LLM;再者,从经济效益考量,SLM的部署成本更低,运行效率更高,为AI应用的大规模推广铺平了道路。

想象一下,AI智能体系统仿佛一个高度协同的虚拟团队,能够自主拆分任务、调度工具(例如浏览器、代码编辑器),直至问题迎刃而解。长久以来,LLM因其强大的对话能力和广泛的知识储备,被视为AI智能体的“智慧核心”。然而,论文指出,随着AI智能体市场的迅猛扩张——从2024年的52亿美元预计增长至2034年的2000亿美元,企业中超过半数已涉足其中——LLM在处理大量重复单一任务时的资源浪费问题日益凸显,好比用顶级跑车送外卖,大材小用。

不仅如此,智能体系统任务的特性使得SLM能够更紧密地融入智能体生态,从而更有可能产出高质量成果。AI智能体本质上是“工具箱+大脑”的复合体,而SLM以其小巧的体积、低廉的训练成本(仅需数小时GPU时间)及对新需求的快速适应力,促进了AI开发的“民主化”,降低了技术门槛,减少了偏见,激发了创新活力。

论文进一步指出,智能体在执行任务时,往往仅需LLM的部分功能,如精确的工具调用。智能体系统的天然异构性为混合使用模型提供了便利:主智能体采用LLM,子任务则交由SLM处理。SLM的广泛应用还能优化数据收集流程:智能体运行过程中自然生成的特定领域数据,可用于微调SLM,形成正向循环,持续提升性能。

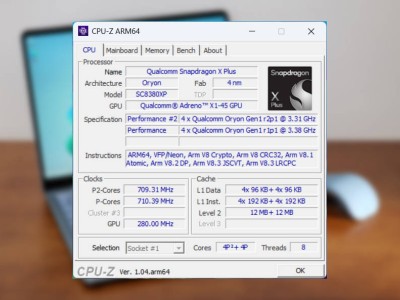

那么,何为SLM?论文给出了明确界定:SLM是指能够嵌入普通消费电子设备(如手机、笔记本电脑),实现快速推理,实时响应用户需求的智能体模型。目前,参数规模在10亿以下的模型被视为SLM,而更大规模的模型则需依赖云端服务器。

为何如此定义?SLM如同随身携带的“智慧口袋”,便于终端部署;而LLM则像是“星际级超级计算机”,虽功能强大,但延迟高、成本高昂。论文作者通过生动的比喻说明了这一平衡:若AI模型无限扩大,将受物理定律限制,无法实现实时交互;若无限缩小,则能力不足,难以执行任务。人类大脑找到了这一平衡点,而SLM正是对这一平衡点的模仿,高效且易于迭代。

论文对比了两种智能体结构:一种是语言模型与用户直接对话并触发工具,整个流程集成于单一模型中;另一种是小型控制器程序负责工具调用,使模型专注于对话或特定推理任务。这种分工使得在大多数调用中插入SLM变得简便且经济,而将LLM保留用于较为罕见的开放式问答或复杂推理步骤。

前沿的小模型,如Phi-3和Hymba,在工具使用、常识推理和指令遵循方面,性能已能媲美300亿至700亿参数的大模型,但在实际工作流中的计算量却减少了10至30倍。英伟达对三款真实世界AI智能体的测试显示,metaGPT、Open Operator和Cradle分别有60%、40%和70%的任务可由SLM替代完成。

尽管SLM优势显著,但AI智能体领域仍未大规模采用SLM,论文认为这主要归因于路径依赖。巨额资金已投入大型模型的基础设施建设,团队倾向于沿用现有付费设置,而非转向更轻便的本地选项。行业内普遍存在“大即是优”的偏见,小型模型的研究往往遵循大型模型的测试基准,而这些基准未能充分展现SLM在智能体任务中的卓越表现。SLM缺乏GPT-4般的热度,也未经历大型模型所享有的营销浪潮,导致许多开发者从未尝试这一更为经济合理的方案。