在人工智能领域的一次重大动作中,OpenAI终于打破了长达六年的沉默,宣布开源两款全新的语言模型——gpt-oss-120b与gpt-oss-20b。这一消息迅速引起了业界的广泛关注与讨论。

这两款新模型均采用了MoE(混合专家)架构,与DeepSeek的多款模型有着异曲同工之妙。OpenAI此番开源的举措,无疑为开发者们提供了更为丰富的选择。而这两款模型的最大亮点,莫过于其在部署上的高效性。gpt-oss-120b能够在单个80GB的GPU上流畅运行,而gpt-oss-20b更是仅需16GB内存,便可在边缘设备上大展身手,为端侧AI应用提供了强有力的本地模型支持。

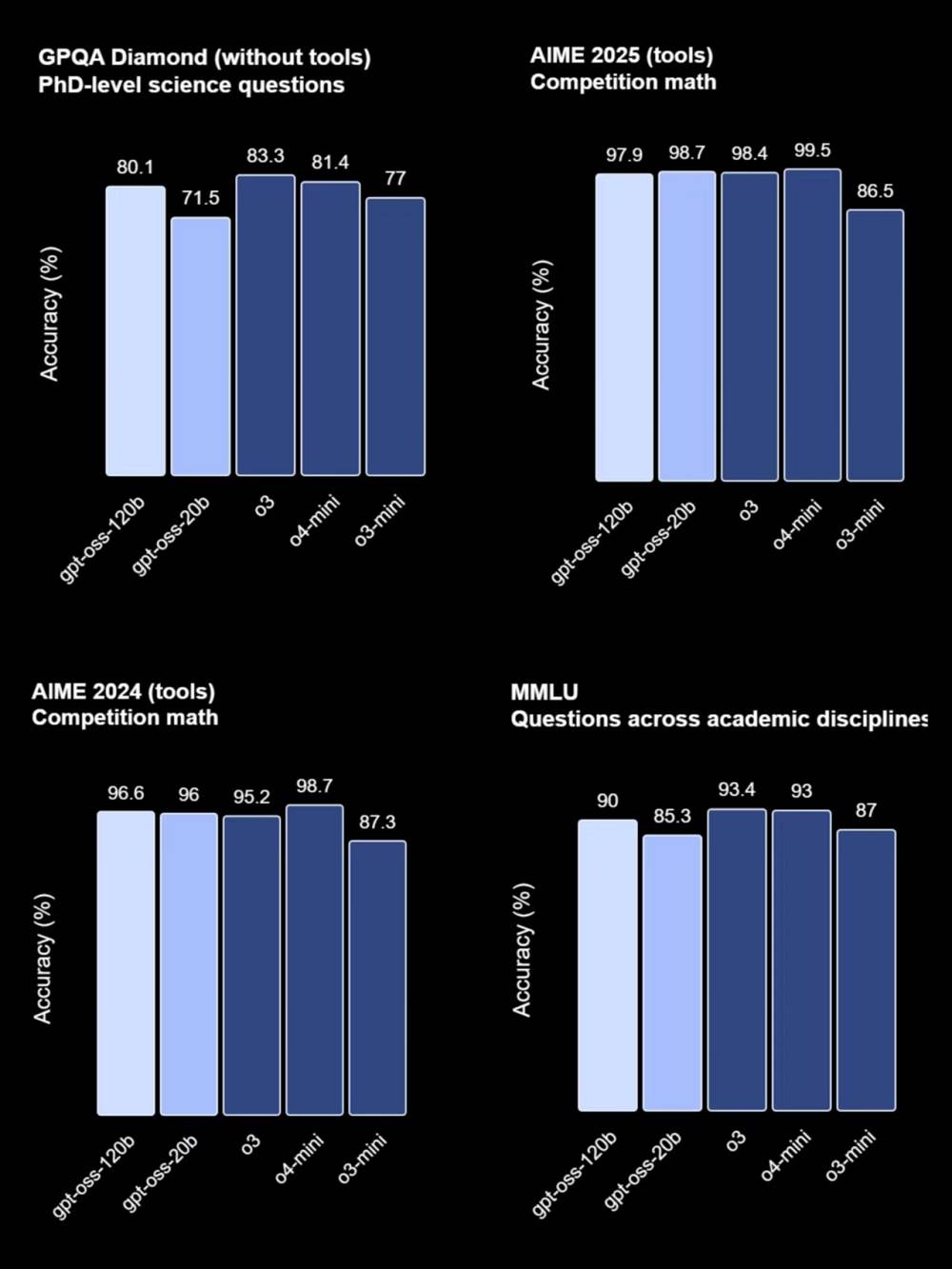

在性能表现上,gpt-oss-120b与OpenAI的o4-mini模型几乎不相上下,而gpt-oss-20b则与o3-mini模型有着相似的表现。特别是在工具使用与小样本函数调用方面,这两款新模型更是展现出了强大的实力。它们还支持调整模型推理长度,进一步提升了应用的灵活性。

值得注意的是,这两款模型还采用了MXFP4原生量化技术,使得它们在保持高性能的同时,也能够更加节能高效。其中,gpt-oss-120b在H100 GPU上历经210万卡时的艰苦训练,才得以问世;而20b版本的训练量则仅为前者的十分之一。

面向Agent场景时,这两款模型与OpenAI的Responses API完美兼容,可用于Agent工作流。它们不仅具备出色的指令遵循能力与工具使用能力,还支持网页搜索与Python代码执行等功能,推理能力同样不容小觑。这一特性无疑将使得它们在更多应用场景中发挥出巨大的潜力。

尽管如此,gpt-oss系列模型的推出仍然得到了众多平台与企业的支持。目前,已有至少14家部署平台宣布了对这两款模型的支持,包括Azure、Hugging Face、vLLM、Ollama等知名平台。在硬件方面,英伟达、AMD、Cerebras和Groq等至少4家企业也宣布了对gpt-oss系列的支持。其中,Cerebras更是将gpt-oss-120b的推理速度提升到了每秒超过3000 tokens,创下了OpenAI模型的最快纪录。

如今,gpt-oss-120b与gpt-oss-20b已正式上线开源托管平台Hugging Face,普通用户也可以在OpenAI打造的体验网站中直接免费试用。这一举措无疑将进一步推动人工智能技术的发展与应用,为更多开发者与研究者提供强有力的支持。