数据中心正以前所未有的速度和规模,驱动全球经济与社会发展,成为新时代的核心动力源。与PC和智能手机时代推动半导体产业进入黄金十年不同,如今,数据中心以人工智能(AI)、云计算和超大规模基础设施为引擎,引领着一个全新的“芯”纪元。

这一变革并非渐进式演变,而是颠覆性革命。数据中心对芯片的需求,已从简单的处理器和内存,迅速扩展为涵盖计算、存储、互连和供电等全方位复杂生态系统。这股需求浪潮正将数据中心半导体市场推向万亿美元级体量。

AI的爆发,特别是生成式AI的兴起,成为这场变革的催化剂。行业预测显示,AI相关资本支出已超越非AI支出,占据数据中心投资的近75%,预计到2025年将超过4500亿美元。AI服务器快速增长,其占比已从2020年的个位数上升到2024年的10%以上。在基础模型训练、推理和定制芯片创新的推动下,全球科技巨头陷入算力军备竞赛,中小企业也迅速跟进,因为未来的竞争优势将直接取决于基础设施规模和芯片级别的差异化。

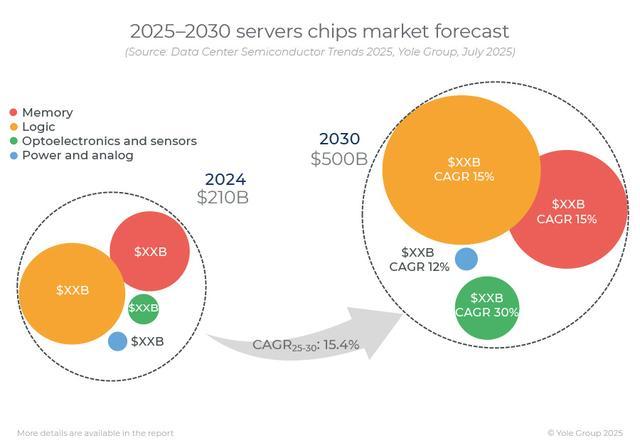

数据中心半导体市场因此迎来爆炸式增长。据Yole Group分析,数据中心半导体加速市场预计2024年开始扩张,到2030年将达到4930亿美元,占整个半导体市场的50%以上。其细分市场的复合年增长率(2025-2030年)几乎是整个半导体行业的两倍,反映出由AI、云计算和超大规模基础设施需求推动的巨大转变。

在这场芯片狂欢中,GPU与ASIC成为两大主角。GPU因其在处理复杂AI工作负载方面的优势,占据主导地位,NVIDIA凭借其强大的GPU生态系统,正转型为全栈式AI和数据中心解决方案提供商。同时,大型云服务商如AWS、Google和Azure等,也在研发自有AI加速芯片,创新定制存储和网络硬件,使AI芯片领域竞争愈发激烈,性能差异化成为核心竞争点。

高带宽内存(HBM)的兴起,是AI时代的又一亮点。随着AI模型规模指数级增长,传统内存带宽成为算力提升的最大瓶颈。HBM凭借其创新的3D堆叠技术,极大提升内存带宽和容量,成为AI和高性能计算(HPC)服务器的标配。HBM市场正经历爆炸式增长,预计2025年将达到38.16亿美元,2025年至2033年复合年增长率高达68.2%。

DPU与网络ASIC的兴起,旨在分担CPU和GPU的网络处理任务,优化流量管理,释放更多计算资源。在安全性、可扩展性、能效和长期成本效益方面,DPU具有显著优势。硅光子学与共封装光学(CPO)技术正在解决高速、低功耗互连挑战,Marvell、NVIDIA和博通等行业巨头积极布局,预计到2030年将创造数十亿美元营收。薄膜铌酸锂(TFLN)调制器也是光通信领域的突破性进展,将高速调制器技术与硅光子学的可扩展性相结合。

先进封装技术如3D堆叠和小芯片(Chiplet)等,正在突破传统摩尔定律的物理极限,为定制化芯片提供更大灵活性。这些技术将不同功能的芯片集成在同一基板上,构建出更强大、更灵活的异构计算平台。

在数据中心设计方面,直流(DC)电源成为提升能效的新范式。随着AI工作负载对计算能力需求的激增,数据中心功率密度飙升,传统交流(AC)供电方式面临挑战。现代AI机架功率需求已从20千瓦跃升至36千瓦,预计到2027年将达到50千瓦。直流配电消除多余的AC-DC转换步骤,减少能量损失,提高整体效率。宽带隙(WBG)半导体材料如氮化镓(GaN)和碳化硅(SiC)成为高频、高压电源转换系统的理想选择。

液冷技术也成为数据中心散热的必然选择。随着AI和HPC工作负载爆发式增长,传统风冷系统难以满足需求。液冷技术具有卓越散热能力,能将冷却能耗降低高达90%,电力使用效率(PUE)接近1,并将数据中心物理占地面积减少多达60%,同时降低噪音。高性能AI芯片正将热管理推向新前沿,迫切需要先进冷却解决方案。液冷技术包括直接芯片液冷(DTC)、背板热交换器(RDHx)和浸没式冷却等类型。

在这场由AI驱动的硅基革命中,数据中心正呈现出日益异构化、专业化和能源高效的特点。芯片设计超越传统CPU/GPU范畴,向更细分的专用处理器发展;先进封装技术成为提升系统性能的关键;直流电源、液冷和全面传感系统共同构建下一代绿色、智能数据中心。这场革命要求整个半导体产业链持续创新,加强战略合作,共同塑造人工智能时代的数字未来。