近日,字节跳动旗下的Seed团队宣布了一项重大开源举措,正式推出了Seed-OSS系列模型。这一系列模型专为处理长上下文、推理任务、Agent行为以及通用场景而设计,其上下文窗口长度达到了前所未有的512k,这一数字是业界常见上下文窗口(128k)的四倍,甚至超越了GPT-5的两倍,相当于能够一次性处理约1600页的文本内容。

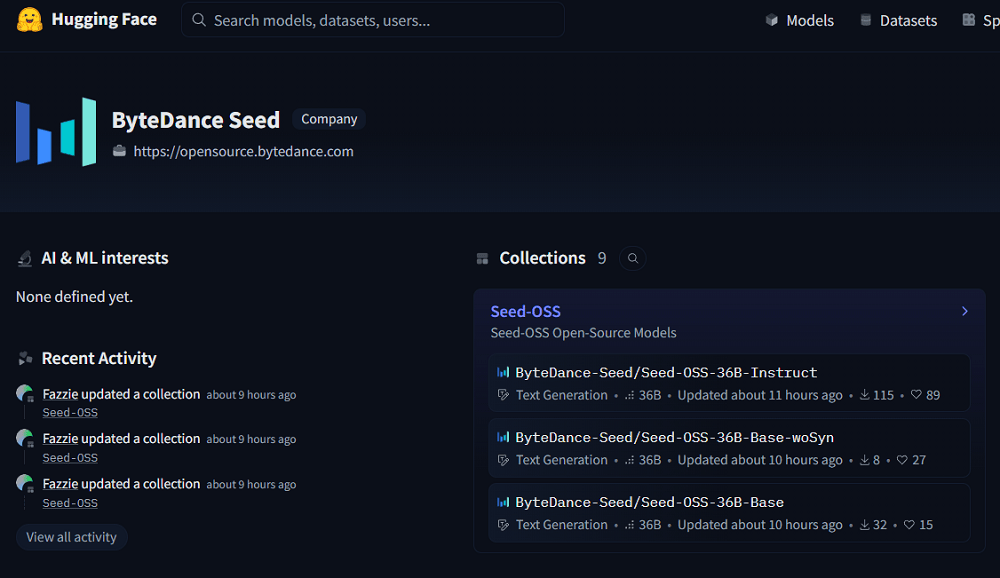

Seed-OSS系列模型不仅专注于推理能力的提升,还为用户提供了灵活的思维预算控制功能。这一特性使得开发者能够根据需要调整模型的推理成本,从而优化使用体验。此次开源的版本包括基础模型Seed-OSS-36B-Base、无合成数据基础模型Seed-OSS-36B-Base-woSyn,以及经过指令微调的Seed-OSS-36B-Instruct。

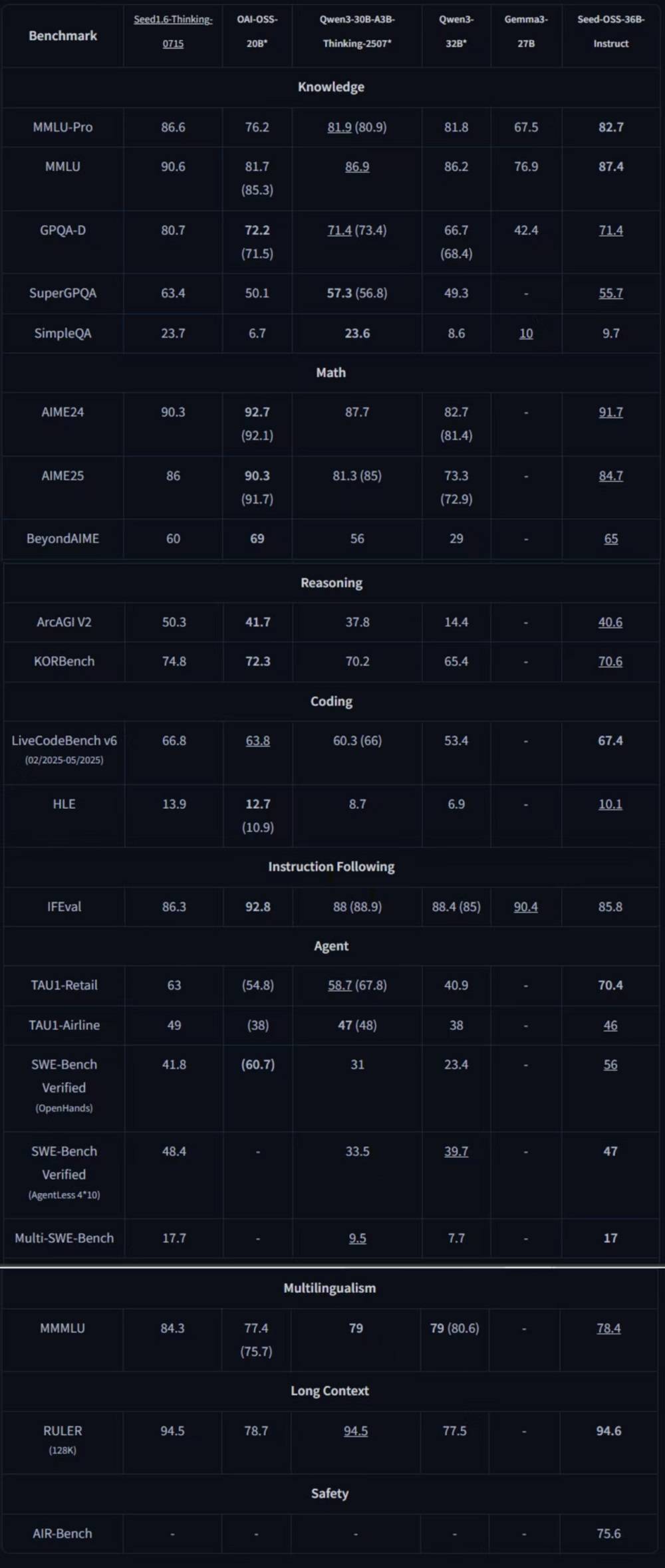

在通用知识、Agent行为、编程以及长上下文等领域的基准测试中,指令微调后的Seed-OSS-36B-Instruct展现出了卓越的性能,取得了同量级开源模型中的七项SOTA(最优性能)表现。其整体能力超越了Qwen3-32B、Gemma3-27B以及gpt-oss-20B等模型,与Qwen3-30B-A3B-Thinking-2507在多个领域不分伯仲。

Seed-OSS系列模型遵循宽松的Apache2.0开源协议,并计划在未来发布详细的技术报告。用户可以通过Hugging Face平台访问这些模型,具体地址为:https://huggingface.co/ByteDance-Seed/Seed-OSS-36B-Base 和 https://huggingface.co/ByteDance-Seed/Seed-OSS-36B-Instruct。

字节Seed团队此次的发布方式充分考虑了研究社区的需求。他们提供了无合成数据的基础模型版本,以避免预训练中的合成指令数据对后续研究产生潜在影响。这一系列模型还支持4位和8位格式的量化,以进一步减少内存需求。

在技术上,Seed-OSS系列模型采用了12万亿个token的预训练数据,并沿用了当前主流的因果语言模型架构,即“预测下一个token”类型的模型。与许多采用MoE等架构的模型不同,Seed-OSS系列均为稠密模型。它们结合了多项关键技术,包括RoPE(旋转位置编码)、GQA注意力机制(Grouped Query Attention)、RMSNorm归一化(Root Mean Square Normalization)以及SwiGLU激活函数等,这些组件的组合有助于提升训练稳定性和推理性能。

Seed-OSS的512k上下文窗口并非通过后续扩展实现,而是原生训练的结果。这一特性使得模型能够处理数十万字的内容,对于需要处理大量文本的应用场景具有重要意义。思考预算功能允许开发者根据任务难度灵活调整模型的推理成本。对于简单的任务,随着思维预算的增加,分数波动不明显;而对于复杂的任务,增加思维预算则能显著提高分数。

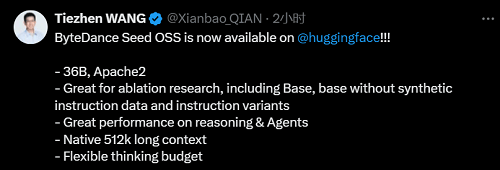

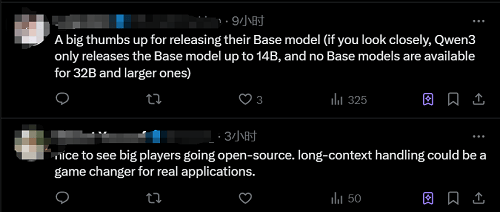

Seed-OSS系列模型一经推出,便获得了开发者的广泛认可。Hugging Face的华人工程师Tiezhen Wang表示,这一系列模型非常适合进行消融研究,能够以较低的成本探索不同组件对大模型性能的影响。不少网友也表示,这种尺寸的基础模型在开源界较为罕见,而长上下文能力对于实际应用具有极大的价值。