近期,网络安全领域迎来了一项重大发现,由Trail of Bits公司的两位专家Kikimora Morozova与Suha Sabi Hussain共同揭示了一种新颖且隐蔽的攻击手段。这种攻击巧妙地利用了图像重采样的技术细节,在不引起人类视觉注意的情况下,在图像中嵌入指令,进而控制大型语言模型(LLM)并盗取用户敏感信息。

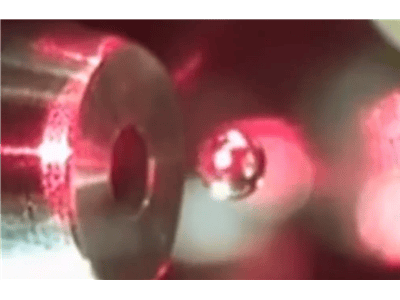

攻击的核心机制在于图像重采样技术。当用户将图片上传至AI系统时,为了优化性能和降低成本,系统通常会自动调整图片分辨率。而攻击者正是利用了这一环节:在全分辨率图像中看似无害的内容,在经过如双三次插值等重采样算法处理后,特定区域的隐藏指令会以可读的文本形式暴露出来。

在一系列实验中,研究人员证实了这种攻击手段的有效性,成功突破了包括Google Gemini CLI、Vertex AI Studio、Google Assistant以及Genspark在内的多个主流AI系统。尤为引人注目的是,在一次针对Gemini CLI的测试中,攻击者无需用户任何形式的授权,就将用户的Google日历数据泄露至了一个外部邮箱。

Trail of Bits指出,尽管实施此类攻击需要对每个LLM所使用的特定重采样算法进行定制,但考虑到攻击媒介的普遍性,其他未经测试的AI工具同样可能面临风险。为了帮助安全社区更好地理解和防御此类攻击,研究人员开发了一款名为Anamorpher的开源工具,专门用于生成此类含有恶意指令的图像。

针对这一新型安全威胁,研究人员提出了一系列防御措施。首先,AI系统应对用户上传的图片实施严格的尺寸限制,以减少潜在攻击面。其次,系统应在图像重采样后,向用户提供即将传递给LLM的结果预览,以便用户识别异常。对于涉及敏感操作的指令,如数据导出,系统应要求用户进行明确的确认操作,增加一层安全保障。