在浩瀚无垠的网络信息世界里,生成式人工智能(AI)正掀起一场前所未有的变革风暴,但这也使得信息的真伪辨别变得日益复杂。为了应对AI内容可能带来的网络污染挑战,各方势力正积极探索解决方案。近日,备受瞩目的互联网工程任务组(IETF)公布了一项创新草案——《AI内容披露标头》,该草案旨在通过在网页HTTP响应中添加机器可读标识,来明确标注内容的AI生成属性。

IETF介绍称,这一标识设计巧妙地与HTTP结构化字段语法相融合,其核心目的是向用户代理、网络爬虫及归档系统等关键实体提供关于AI在内容生成过程中参与程度的元数据。这些系统可以依据自身需求,灵活决定是否接纳或处理AI生成的内容。此举直击AI领域的关键痛点:不同AI产品间可能存在的虚假内容相互引用,这种循环引用极易导致虚假信息被误判为真实,进而对整个互联网的内容生态造成扰乱。

AI之所以会“信口雌黄”,根源在于其作为“概率预测机”的本质特性。AI大模型通过海量数据的训练,学习词语间的关联规律,但在处理罕见或复杂信息时,可能因缺乏确凿依据而“无中生有”。面对用户提问,若AI无法找到确切答案,便会倾向于生成一个概率上看似最合理的答案,而非事实正确的答案。这种倾向使得AI输出的内容往往看似合乎逻辑,实则可能偏离事实真相。

AI幻觉现象虽难以彻底根除,但已成为业界关注的焦点。更令人忧虑的是,当多个AI产品开始相互引用这些虚假内容时,便可能形成一个虚假的闭环,使得虚构的信息逐渐被大众所接受。例如,近期发生的关于明星王一博的谣言事件,正是由于AI在未核实事实的情况下,基于语义关联性自动补全了内容,最终被另一款AI工具ChatGPT所揭露。

ChatGPT在此次事件中能够发挥事实核查作用的关键,在于它与生成虚假道歉声明的AI使用了不同的训练数据集。换言之,ChatGPT因未被虚假内容所污染,所以能够输出真实信息。然而,如果OpenAI的爬虫GPTBot抓取到了虚假的“道歉声明”,结果或将截然不同。当前,为了提升模型的智能水平,AI厂商的爬虫几乎不加筛选地抓取数据,即便这些数据中包含有害的虚假信息。

这种做法在学术界已引发“引用农场”现象,即通过相互引用将低质量的论文包装成高影响力论文。同样,当AI开始相互引用虚假内容时,用户将深受其害。IETF此次提出的《AI内容披露标头》草案,旨在从源头上切断AI生成的虚假和垃圾内容回流至互联网的渠道,防止它们成为训练新AI模型的数据,从而避免陷入“垃圾进、垃圾出”的恶性循环。

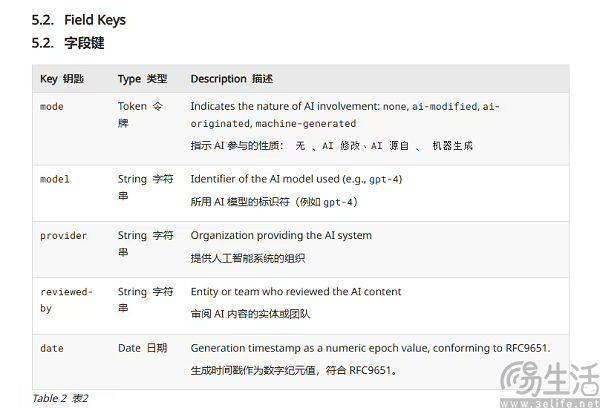

具体而言,IETF要求HTTP文件中必须声明AI模型的名称、提供者、校验团队及时间戳等关键信息,以此防止AI厂商的爬虫错误地抓取AI生成的内容。实际上,AI厂商同样不希望抓取到AI内容,以免其训练数据受到污染。从某种程度上说,《AI内容披露标头》草案与AI水印有着异曲同工之妙,都是从内容生产和传播的起点入手,为“AI生成”的内容打上独特的识别烙印。

相较于技术实现难度较大的AI水印,要求网站主动披露内容是否由AI生成显然更为切实可行。关键在于,IETF作为互联网标准制定与推广的权威组织,其影响力不可小觑。HTTP和IPv6等互联网基础协议均出自IETF之手,可以说,当今的互联网是建立在IETF的坚实基石之上的。因此,IETF提出的这一草案,有望为净化网络内容生态、遏制AI虚假信息的传播发挥举足轻重的作用。