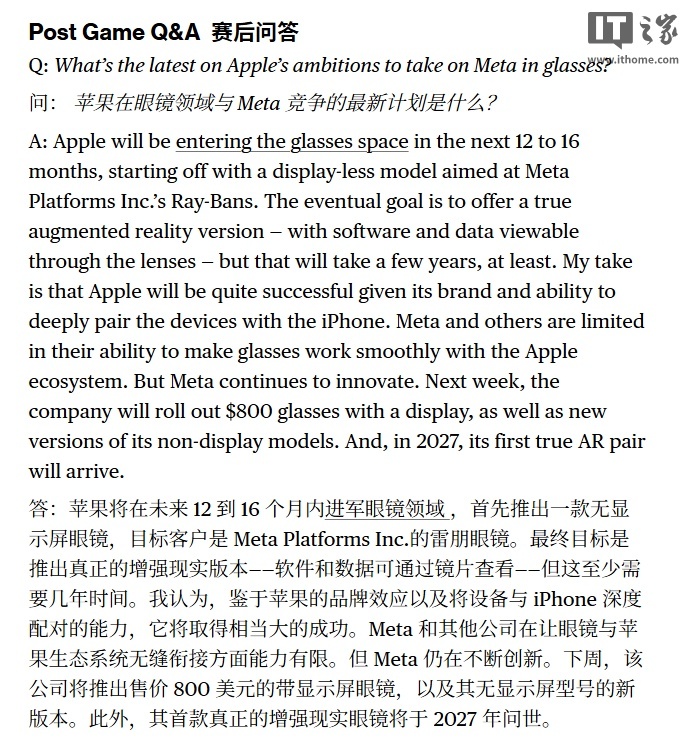

苹果公司正加速布局智能穿戴设备领域,其首款无显示屏智能眼镜预计将在未来12至16个月内面世。这款被视为对标meta Ray-Bans的产品将主打轻量化设计,通过连接iPhone实现数据处理,配备摄像头与具备播放录音功能的音频系统。据彭博社"Power On"专栏报道,苹果分析师马克·古尔曼指出,该产品虽不具备AR显示功能,但将成为苹果进军智能眼镜市场的关键一步。

技术瓶颈成为制约苹果开发完整版AR眼镜的核心因素。古尔曼透露,要实现通过镜片直接显示内容的沉浸式体验,至少需要数年时间突破微型化与减重技术。苹果的目标是打造接近传统眼镜的轻便形态,而非延续Apple Vision Pro的厚重设计。这与郭明錤等分析师此前的预测形成呼应,他们普遍认为苹果智能眼镜的完整形态可能推迟至2026年或2027年发布。

苹果在生态整合方面的优势成为关键竞争力。古尔曼强调,现有iPhone用户群体将自然转化为智能眼镜的潜在消费者,这种品牌粘性是meta等竞争对手难以复制的。更关键的是,苹果设备间的深度协同能力使其智能眼镜能无缝接入iOS生态,而meta产品与iPhone的兼容性始终存在障碍。这种软硬件一体化的生态壁垒,或将为苹果智能眼镜构筑护城河。

在智能穿戴设备创新方面,苹果的研发触角已延伸至音频领域。据知情人士透露,苹果正在测试内置红外摄像头的AirPods原型机。这款设备可通过环境感知技术采集视频数据,并实时传输至iPhone和Apple Intelligence系统,为计算机视觉功能提供支持。若该技术落地,配备摄像头的AirPods将具备主流智能眼镜的核心功能,形成独特的"音频+视觉"双模态交互体验。

更值得关注的是跨设备协同的可能性。行业分析师指出,当摄像头AirPods与智能眼镜形成联动,Apple Intelligence将获得多视角数据输入,显著提升环境感知能力。结合AirPods现有的高品质音频单元与麦克风阵列,这种软硬协同的解决方案或能重新定义个人穿戴设备的交互标准。苹果在智能穿戴领域的生态布局,正从单一设备创新转向系统级体验革新。