在大语言模型(LLM)驱动的智能体研究领域,多智能体协作的强化学习机制长期面临技术瓶颈。现有训练框架普遍聚焦单智能体优化,而医疗诊断、科研探索、复杂编程等场景中,多智能体协同工作流已被证明能显著提升任务表现。针对这一矛盾,来自加州大学圣地亚哥分校与英特尔的联合研究团队,提出了首个通用化多智能体强化学习框架PettingLLMs,实现了跨任务、跨模型规模的群体智能进化。

传统强化学习算法GRPO(Group Relative Policy Optimization)通过同一上下文生成候选回答并计算相对优势,但其核心假设要求比较组内所有回答必须基于完全相同的输入提示(prompt)。在多智能体多轮交互场景中,这一条件难以满足——不同智能体在不同轮次接收的提示往往包含历史对话、其他智能体生成的中间结果等动态信息。例如编程任务中,第二轮的提示可能同时包含原始需求、智能体A生成的代码框架以及智能体B编写的单元测试用例。若强行将跨轮次、跨智能体的回答纳入同一比较组,将直接破坏GRPO的公平性假设,导致优势计算基准混乱。

研究团队提出的解决方案包含两大核心创新。首先是基于贪心搜索的树状采样机制:每个轮次中,每个智能体作为节点进行K次分支探索,系统动态选择当前奖励值最高的智能体路径进行下一轮扩展。这种设计在保证组内回答批次量的同时,通过动态路径选择维持了优势计算的公平性。其次是角色-全局双奖励函数:每个智能体的奖励既包含角色专属目标(如代码生成质量),也纳入全局任务指标(如系统整体通过率),确保个体能力进化与群体协作的平衡。

为支持不同场景下的训练需求,研究团队构建了异步分发训练系统。该系统通过路由模块智能分配数据流:在专属模型模式下,不同智能体的交互轨迹被定向发送至独立资源池进行模型更新;共享模型模式下,所有轨迹数据则汇总至同一资源池进行联合优化。这种灵活架构使得研究人员可根据任务特性,在角色专业化与模型通用化之间自由切换。

开源框架PettingLLMs大幅降低了多智能体强化学习的开发门槛。开发者仅需定义任务特定的智能体交互逻辑与奖励函数,即可利用框架内置的采样算法、资源调度系统和环境适配接口快速构建训练环境。框架支持不同模型与智能体的自由映射,并兼容LoRA等轻量化适配技术。目前,框架已预置数学推理、代码生成、策略游戏等主流任务环境,并提供完整的环境开发教程。

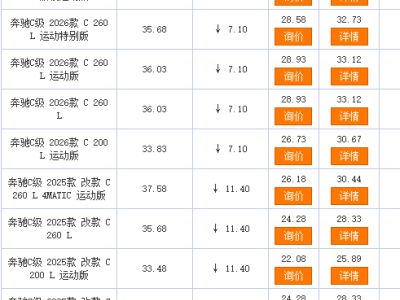

实证研究覆盖Qwen3-1.7B与Qwen3-8B两个模型规模,涉及规划(推箱子、路径规划)、代码(LiveCodeBench、APPS竞赛集)、数学(AIME竞赛、奥林匹克基准)三大类任务。实验数据显示,采用AT-GRPO算法训练后,推箱子任务成功率从14%跃升至96%,路径规划任务准确率从47%提升至99.5%;代码生成任务中,LiveCodeBench、APPS、CodeContests的得分分别提高6.1%、4.2%和7.0%;数学推理任务AIME 2024与2025的得分提升达9.0%和17.9%。

消融实验进一步验证了框架设计的合理性。单智能体训练模式下,即使将规划、工具等子角色分开训练,其指标提升幅度显著低于多智能体协作模式;角色策略互换实验显示,已训练成熟的智能体组合若强行调换角色,任务准确率将从96%暴跌至6%,证明不同智能体习得的是互补且不可替代的能力。训练过程分析表明,随着迭代进行,智能体间的协作效率持续提升,完成任务所需的平均交互轮次明显下降。

该研究成果已通过开源代码与论文形式公开。项目地址:https://github.com/pettingllms-ai/PettingLLMs;论文链接:https://huggingface.co/papers/2510.11062。研究者表示,这一框架为复杂任务中的群体智能进化提供了通用解决方案,其模块化设计可支持未来更多类型智能体的接入与协同。