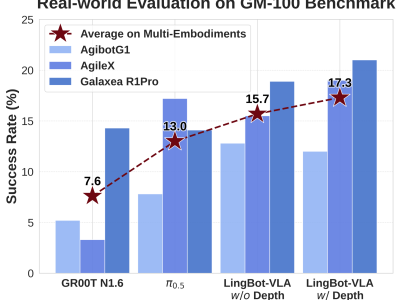

蚂蚁集团旗下具身智能公司灵波科技近日宣布开源高精度空间感知模型LingBot-Depth,该模型通过算法创新显著提升了消费级RGB-D相机的深度感知能力,在机器人领域引发广泛关注。搭载该模型的奥比中光Gemini 330系列相机在深度精度和像素覆盖率等核心指标上,已超越行业顶级深度相机,为机器人精准交互提供了关键技术支撑。

在机器人落地应用过程中,空间定位感知是核心前提。传统RGB-D相机受硬件限制,在镜面反射、无纹理表面等场景下易产生深度误差,导致机器人无法准确判断自身位置。LingBot-Depth模型通过掩码深度建模(MDM)机制,将传感器失效区域视为可学习的结构线索,利用RGB图像中的视觉上下文信息智能推断缺失深度,从而生成贴合物理世界的高精度完整深度表示。这一创新使机器人在抓取透明、反光物体时的成功率大幅提升,测试中透明收纳箱抓取成功率从0%提升至50%,多种反光和透明物体的抓取成功率提高30%~78%。

技术评测显示,LingBot-Depth模型在主流3D视觉基准数据集NYUv2、ETH3D上的表现远超PromptDA、PriorDA等业界主流模型。在室内场景下,其相对误差(REL)降幅超70%;在高挑战性的稀疏SfM任务中,均方根误差(RMSE)降低约47%。该模型生成的深度图具备更清晰的边界和更连贯的结构特征,尤其在遮挡严重或观测信息稀疏的区域优势明显。在单目深度估计任务中,LingBot-Depth在10项基准上的表现均优于视觉模型DINOv2,其预训练范式有效将3D几何知识融入编码器,提升了从单目图像推断深度结构的能力。

为支持大规模MDM训练,研究团队构建了包含1000万条样本的多样化高质量训练集。该数据集通过自托管3D资产生成合成数据,并利用模块化3D打印采集装置完成实景数据采集,兼容多款消费级RGB-D相机。所有样本均包含同步的RGB图像、原始传感器深度数据及立体图像对,其中立体图像对的伪深度监督由自定义立体匹配网络实现。结合这一数据集,研究团队采用掩码深度建模方式对ViT-Large模型进行预训练,通过注意力机制将度量几何信息融入语义标记,显著提升了RGB-D相机的空间感知质量。

在实际应用验证中,LingBot-Depth模型展现出高实用性与落地潜力。在3D点跟踪任务中,面对大面积玻璃场景时,原始深度传感器严重失效,而经该模型优化后的深度数据能够生成更平滑精确的相机轨迹。在灵巧手抓取实验中,配备X Hand-1灵巧手的Rokae XMate-SR5机械臂使用Orbbec Gemini 335 RGB-D相机,在抓取高度透明物体时的成功率达到50%,而原始方法完全无法完成抓取。这些测试场景均对标机器人落地应用中的高频实际场景,充分证明了该技术方案的有效性。

目前,灵波科技已开源LingBot-Depth模型的代码和检查点,并计划近期开源300万个RGB深度对数据,包括200万个真实数据和100万个合成数据。这一举措或将推动RGB-D相机硬件的优化升级,进一步提升模型在真实长尾场景中的鲁棒性。通过降低技术落地成本,该模型为各类智能应用的开发奠定了坚实基础,开发者可直接基于该模型快速搭建应用,加速机器人、自动驾驶汽车等产品从技术概念向现实场景的转化。