近日,稀宇科技正式发布其最新模型minimax m2.5,引发人工智能社区广泛关注。这款模型在复杂场景下的表现突破,得益于背后一套名为forge的异步原生agent强化学习系统。该系统通过创新架构设计和工程优化,成功解决了大规模强化学习中的多个关键难题。

在真实世界的大规模应用中,强化学习系统需要同时满足系统吞吐量、训练稳定性与agent灵活性三方面的要求。传统框架往往难以平衡这些需求,而forge系统通过标准化agent-LLM交互协议,支持对任意agent架构进行训练。该系统实现了每天百万级样本量的处理能力,在200k上下文长度下仍能保持稳定的性能提升。

系统设计方面,forge采用模块化架构,将agent执行逻辑与底层训推引擎彻底解耦。核心模块包括agent抽象层、中间件抽象层和训练推理引擎。其中,中间件包含标准化通信网关和分布式数据存储,有效隔离了底层模型复杂性与高层行为逻辑。训练引擎则通过rollout引擎和train引擎的协同工作,确保模型使用最新策略分布进行探索。

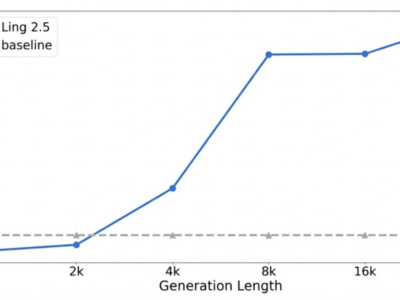

针对白盒agent的特殊需求,研发团队将上下文管理机制直接整合到强化学习交互循环中。通过将上下文变迁建模为环境动态的一部分,解决了长程任务中常见的注意力稀释问题。实验数据显示,这种设计显著提升了模型在深搜索等复杂任务中的表现,同时保持了训练与推理阶段的数据分布一致性。

对于闭源黑盒agent,系统采用非侵入式集成方案。通过标准化网关接收请求,无需了解内部实现细节即可完成数据收集和训练。这种设计使系统能够广泛适配各类agent架构,包括代码agent和采用激进上下文缩减策略的agent。测试表明,该方法在完全不透明的系统中仍能带来稳定的性能提升。

工程优化方面,团队提出windowed fifo调度策略,在吞吐量与数据分布一致性间取得平衡。该策略通过设置可见窗口,既避免了队头阻塞,又防止训练分布向简单样本偏移。针对多轮请求中的前缀冗余问题,开发的prefix tree merging方案将训练样本重构为树形结构,实现约40倍的训练加速并降低显存消耗。

在推理加速领域,系统采用dynamic mtp技术,并通过top-k kl损失保持与rl策略的对齐。通过pd分离设计和全局l3 kv缓存池,进一步优化了长尾样本延迟和缓存命中率。这些创新使rollout阶段的算力占比降至60%,同时保持了高水平的模型接受率。

算法层面,研发团队设计了复合奖励机制来解决超长轨迹的信用分配问题。该机制包含过程奖励、任务完成时间奖励和后续奖励三部分,通过提供密集反馈和标准化回报,显著提高了训练稳定性。这种设计使模型能够主动优化执行路径,在保持性能的同时提升响应速度。

目前,minimax m2.5模型已全面开源,开发者可通过hugging face和github平台获取相关资源。这一发布为人工智能社区提供了新的研究基准,其创新架构和工程实践为大规模强化学习应用树立了新的典范。