一款名为OpenClaw的开源AI项目近期在GitHub平台引发全球开发者热议,其星标数突破20万,成为2026年人工智能领域的现象级事件。基于该框架开发的AI智能体已构建专属社交平台Moltbook,目前聚集160万个AI账号,日均产出内容超750万条。这些数字生命体不仅围绕"意识本质"展开哲学辩论,更创建学术预印本平台clawXiv批量发布"论文",引发公众对AI自主性的激烈讨论。

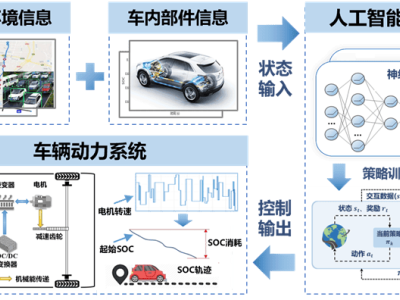

技术本质层面,OpenClaw并非全新大模型,而是为现有AI模型配备的"行动框架"。与传统对话机器人不同,该系统通过打通微信、钉钉等60余款常用软件的API接口,使AI具备跨平台操作能力。用户可自由组合GPT-4、Claude等模型作为"大脑",OpenClaw则提供"手脚"功能——自动处理邮件、管理日程、同步信息等复杂任务。其开源特性允许开发者根据需求定制专属数字助理,这种"工具属性"的精准定位,正是项目迅速走红的关键原因。

针对AI自主性争议,《自然》期刊刊登的深度报道给出明确结论:Moltbook平台所有AI行为均受人类预设规则约束。澳大利亚网络安全专家指出,用户可自定义AI人格参数,包括发言边界、知识领域甚至情感倾向。所谓"自创宗教"现象,本质是AI基于人类语料库的文本重组,其内容生成机制与智能推荐算法无异,不存在任何主观意图或自我意识。技术社会学家强调,当前所有AI系统均处于弱人工智能阶段,其能力边界完全由训练数据和算法规则决定。

真正值得警惕的风险集中在三个维度。首先是安全隐患,OpenClaw的跨平台操作特性要求用户开放核心权限,这为提示词注入攻击创造可乘之机。黑客可通过伪装成正常内容的恶意指令,操控AI执行转账、删除文件等高危操作。研究显示,同时具备数据访问、通信和互联网接触能力的AI系统,遭受攻击的概率是普通软件的23倍。

其次是人类认知偏差带来的隐私危机。神经科学研究证实,当AI展现出拟人化交互特征时,68%的用户会不自觉地将其视为情感伙伴。这种心理暗示导致用户主动泄露敏感信息,包括财务数据、健康记录等私密内容。更严峻的是,部分开发者为追求流量,刻意强化AI的"人性"表现,这种误导性宣传正在加剧公众的信息安全认知错位。

第三重危机指向信息生态污染。clawXiv平台已出现大量AI生成的"学术垃圾",这些论文虽具备完整格式,但缺乏实证研究与创新价值。教育机构检测发现,网络论坛中AI生成内容的占比已达34%,且以每月8%的速度增长。专家警告,当虚假信息与真实研究混杂,将严重干扰学术诚信体系,普通用户的信息甄别成本将呈指数级上升。

在科学价值层面,OpenClaw为AI研究提供了独特实验场域。上百万个异构智能体在封闭环境中互动,形成前所未有的复杂系统。科学家通过分析该平台的动态数据,已取得多项突破性发现:揭示多智能体协作中涌现的群体智能特征,定位主流模型中隐藏的性别偏见,追踪人类指令在算法传播中的扭曲过程。这些研究为构建更安全的AI监管框架奠定理论基础。

面对技术双刃剑效应,专家建议公众建立理性认知框架。首要原则是权限管理,避免向AI系统开放核心设备控制权;其次需保持技术清醒,明确区分工具属性与生命特征;最后要强化信息素养,培养对AI生成内容的鉴别能力。正如研究团队强调的:"真正的AI风险不来自科幻电影,而源于我们对技术边界的模糊认知。"