在2025年世界人工智能大会的各大论坛中,“安全治理”成为了频繁讨论的核心议题。而在这些深入的探讨中,“AI确定性”这一概念也逐渐浮出水面,引起了业界的广泛关注。

DeepSeek-R1的推出,无疑给业界带来了极大的震撼。这款AI模型的强大推理能力令人瞩目,但与此同时,也引发了一些隐忧。随着AI在商业领域的广泛应用,如何降低AI产生的幻觉、提高输出的确定性,成为了业界亟待解决的问题。

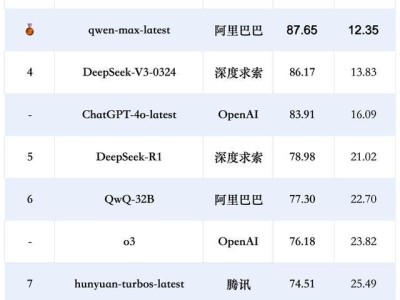

所谓的AI幻觉,指的是大模型在生成内容时,有时会“一本正经地胡说八道”。根据中文通用大模型综合性测评基准SuperCLUE的测评结果,DeepSeek-R1的模型幻觉率高达21.02%,远高于豆包大模型的4.11%,也超过了DeepSeek另一款大语言模型V3的13.83%。测评结果还显示,推理模型的幻觉问题相较于非推理模型更为严重。

这一高幻觉率对DeepSeek的用户体验产生了不小的影响。据统计,与年初相比,DeepSeek的月均下载量与使用率均出现了大幅下降。面对这一问题,DeepSeek在5月29日升级模型时,特意针对幻觉问题进行了优化。据官方介绍,新版本模型在改写润色、总结摘要、阅读理解等场景中,幻觉率降低了45%至50%,输出结果更为准确可靠。

AI幻觉的产生,主要源于大模型的双重技术局限:一是推理时编造内容,二是训练数据不全。大模型依靠训练数据来理解世界,如果训练数据存在遗漏或错误,大模型的输出结果就容易出错。大模型在生成内容时,往往会根据概率猜测最可能的答案来补全,尤其是在回答开放性问题时,这种猜测更容易导致幻觉的产生。

然而,AI幻觉并非不可接受。事实上,人类也会产生幻觉,并依赖幻觉做出决策。在2025世界人工智能大会主论坛上,深度学习之父杰弗里·辛顿就提出了一个惊人的观点:人类理解语言的方式与大语言模型理解语言的方式几乎一样,人类有可能就是大语言模型,因此也会和大语言模型一样产生幻觉。

阶跃AI的“深入核查”功能在试运行一周内就取得了显著成效,登上了海外AI产品榜单前十名,并收到了用户的正面反馈。这一功能的成功应用,为降低AI幻觉、提高AI输出的确定性提供了新的思路和方法。