在AI领域的一次重大举措中,OpenAI在沉寂六年后,终于再度向公众推出了两款全新的开源语言模型——gpt-oss-120b与gpt-oss-20b。这一消息迅速在科技圈内引起了广泛关注与讨论。

据悉,这两款模型均采用了先进的MoE(Mixture of Experts)架构,与DeepSeek的多款模型有着异曲同工之妙。它们的发布,标志着OpenAI在模型部署效率上的重大突破。gpt-oss-120b能够在仅需80GB内存的GPU上流畅运行,而gpt-oss-20b更是以16GB的内存要求,轻松适配边缘设备,为端侧AI应用提供了理想的本地模型选项。

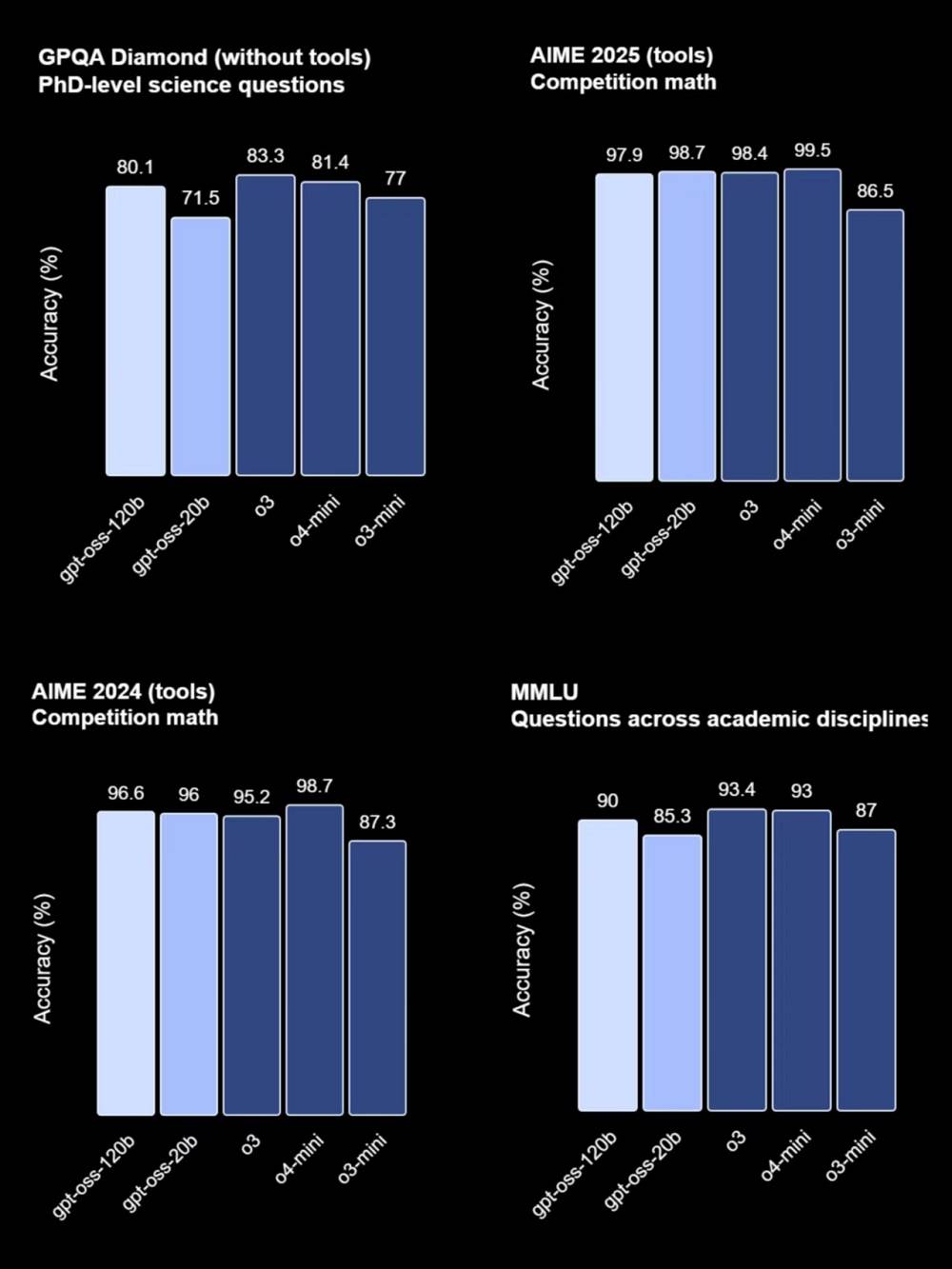

OpenAI强调,这两款模型在多项基准测试中展现出了卓越的性能。gpt-oss-120b的表现与OpenAI的o4-mini模型不相上下,而gpt-oss-20b则与o3-mini模型有着相似的表现。特别是在工具使用与小样本函数调用方面,它们展现出了强大的实力。

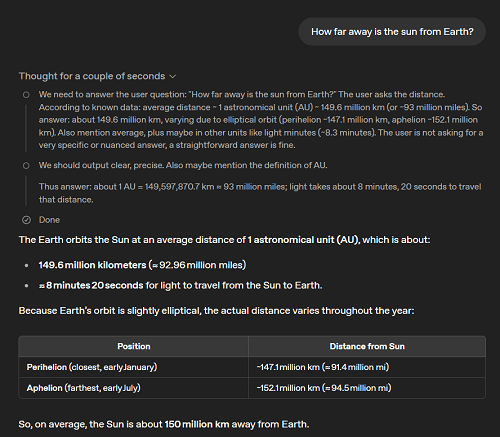

值得注意的是,这两款模型还具备出色的指令遵循能力、网页搜索与Python代码执行能力,以及强大的推理能力。它们已经与OpenAI的Responses API兼容,可用于Agent工作流,并支持调整模型推理长度,为用户提供了更加灵活的使用体验。

然而,尽管OpenAI此次开源举措受到了广泛欢迎,但也有部分网友对其开源程度表示质疑。他们认为,OpenAI并未完全公开训练过程、数据源以及强化学习的技术细节,这使得开源社区难以从中获得实质性的借鉴与启发。OpenAI在基准测试中并未将gpt-oss系列与DeepSeek、Qwen、Kimi等开源模型进行比较,也未与Claude、Grok、Gemini等闭源竞争对手进行对决,这也引发了一些争议。

尽管如此,gpt-oss系列模型的发布仍然得到了众多企业和开发者的积极响应。目前,已有至少14家部署平台宣布支持这两款模型,包括Azure、Hugging Face、vLLM、Ollama等知名平台。同时,英伟达、AMD、Cerebras和Groq等至少4家芯片企业也宣布了对gpt-oss系列的支持。其中,Cerebras更是创下了新的速度记录,gpt-oss-120b在其芯片上的推理速度达到了每秒超过3000 tokens,成为史上最快的OpenAI模型之一。

普通用户也可以在OpenAI打造的体验网站上直接免费使用gpt-oss-120b和gpt-oss-20b。这两款模型已经上线开源托管平台Hugging Face,为开发者提供了更加便捷的获取途径。许多网友在体验后表示,这两款模型的思考速度极快,能够在极短的时间内给出准确的回答,大大提升了工作效率。

OpenAI的此次开源举措,无疑为AI领域注入了新的活力。尽管存在一些争议与质疑,但gpt-oss系列模型的发布仍然标志着OpenAI在模型部署效率与性能上的重大进步。未来,随着更多企业和开发者加入这一行列,我们有望看到更加丰富多彩的AI应用场景与更加高效便捷的AI服务。