杭州灵汐类脑科技有限公司携手中国电信、中国电子科技南湖研究院及脑启社区,于七月底成功启动了“杭州灵汐类脑智算集群”的企业服务试运行,标志着大模型快速推理API正式步入商业化测试阶段。该集群由杭州电信负责集成建设,落户于中国电信杭州智算中心,算力规模突破200POPS大关,成为全球首个以支持大模型快速推理方式投入商用的类脑智算集群。

作为类脑智能技术的创新实践,“杭州灵汐类脑智算集群”凭借其独特的“存算一体、众核并行、稀疏计算、事件驱动”特性,在计算效率与能耗控制上实现了质的飞跃。这一技术革新不仅大幅提升了大语言模型的推理速度,将单用户推理延迟缩短至毫秒级,相较于传统方案,其速度性能优势显著,能够流畅应对实时交互与深度推理需求,彻底告别卡顿现象。同时,首token延迟也显著降低,达到百毫秒乃至十毫秒级别。该智算集群的功耗较业界同等推理算力水平降低了二分之一至三分之二以上,展现了极高的能效比。

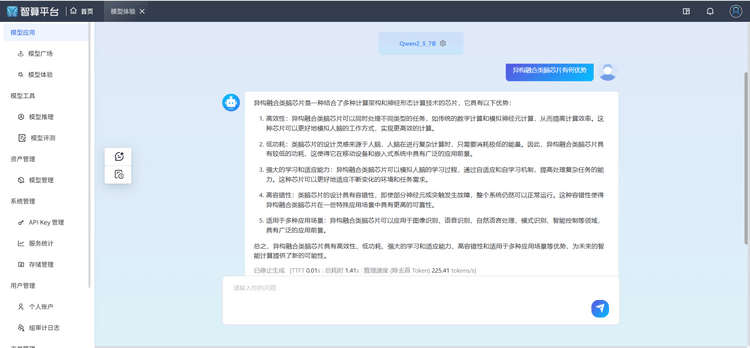

图:灵汐智算平台大模型登录界面

异构融合类脑芯片是该集群的另一大亮点,其内置的类CUDA软件栈兼容PyTorch框架,使得多类开源大模型无需转换类脑算法即可直接享受快速推理服务。这一特性极大地拓宽了类脑智算集群的应用范围,为行业提供了更为便捷、高效的解决方案。

图:灵汐智算平台大模型快速推理界面

当前,大模型推理领域普遍面临吞吐速度慢、高延迟等挑战,这对众多行业应用场景构成了严重制约。针对这一问题,灵汐科技凭借类脑智能技术,推出了“高实时、高吞吐、低延迟”的推理服务解决方案。该方案在金融应用、情感陪聊、快速导览、大规模数据标注以及无人机实时航拍处理、灾害预警与应急处置等多个领域展现出巨大潜力,有望推动这些行业向更高效、更智能的方向发展。