英伟达近期在人工智能领域再次迈出重要一步,发布了一款名为NVIDIA Nemotron Nano 2的全新语言模型。这款模型以其独特的Mamba-Transformer混合架构吸引了业界的广泛关注。

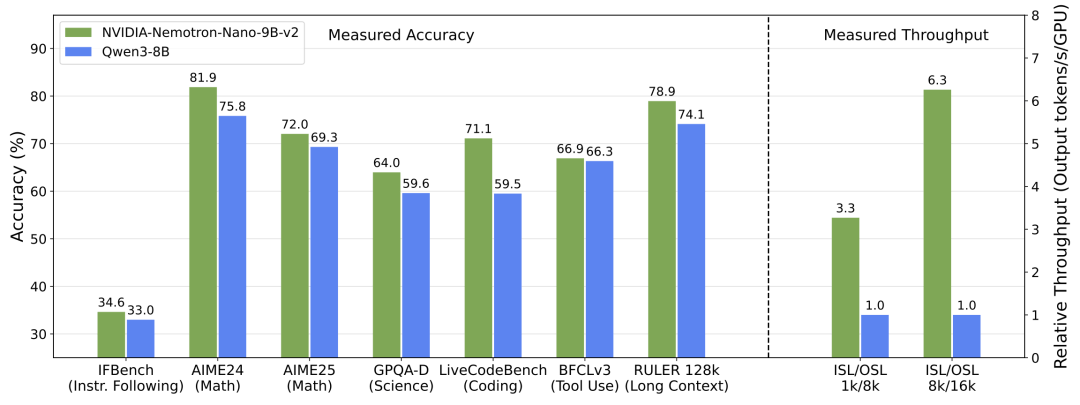

据英伟达官方介绍,Nemotron Nano 2模型虽然只有90亿参数,但其性能却不容小觑。该模型采用了革命性的Mamba-Transformer混合架构,旨在提升复杂推理任务中的吞吐量和精度。与业界标杆Qwen3-8B相比,Nemotron Nano 2在数学、代码、推理以及长上下文任务中表现持平或更优,同时在推理吞吐量上实现了最高6倍的提升。

为了验证这一性能提升,英伟达在官网上进行了简单测试,结果显示,该模型能够准确回答一系列经典问题。英伟达还开发了三个小工具,分别用于实时查询天气、描述哈利波特角色以及帮助用户选择颜色,进一步展示了该模型在实际应用中的潜力。

Nemotron Nano 2的强大性能得益于其创新的Mamba-2架构。这一架构通过替换传统Transformer中的大多数自注意力层,实现了推理速度的显著提升。在处理超长序列时,Mamba架构的推理速度比Transformer快3-5倍,且复杂度为线性级别,支持极长的上下文处理。

那么,为什么英伟达会选择将Mamba与Transformer混合使用呢?据了解,Transformer虽然效果显著,但在处理长序列时存在计算和内存瓶颈。而Mamba则擅长在长上下文中高效建模,但在某些特定任务上可能稍显不足。因此,英伟达将两者结合,旨在发挥各自的优势,实现性能的最优化。

在训练过程中,Nemotron Nano 2经历了多个阶段的精心打磨。首先,在一个拥有20万亿Token的海量数据集上进行预训练,锻造出一个120亿参数的基础模型。然后,结合多种对齐方法,提升了模型的推理、对话、工具调用与安全性。最后,通过Minitron策略进行极限压缩与蒸馏,将基础模型压缩为90亿参数的最终版本。

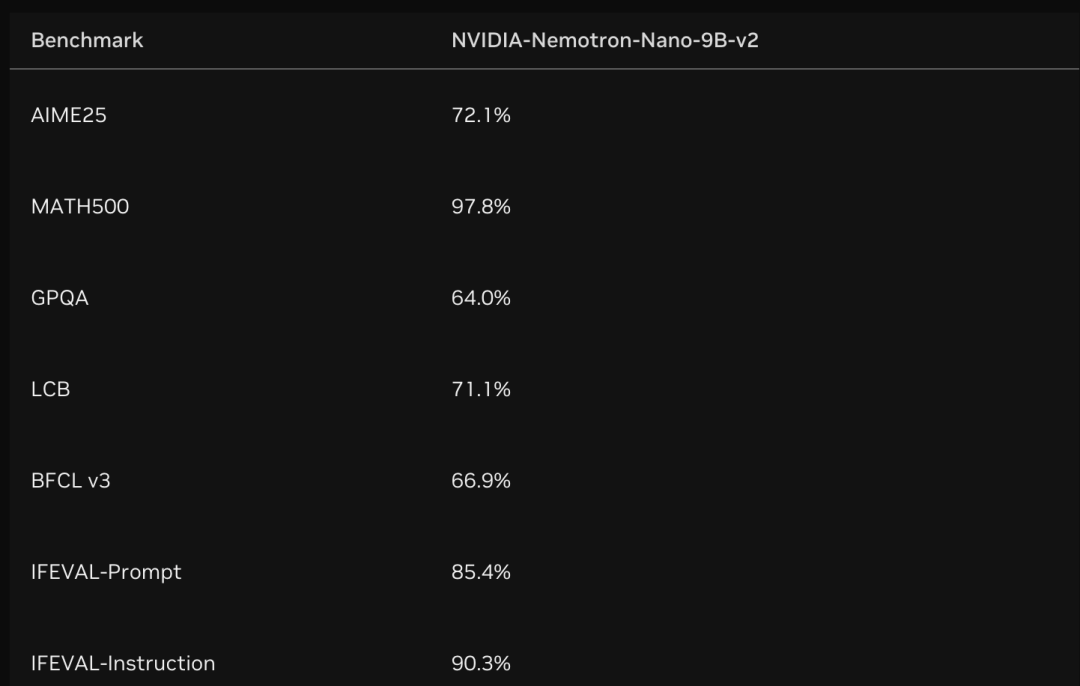

在各大推理基准测试中,Nemotron Nano 2展现出了卓越的性能。在数学、代码、通用推理以及长上下文等基准测试中,该模型的表现优于或持平同类开源模型,如Qwen3-8B和Gemma3-12B。同时,在8k输入/16k输出场景下,该模型的吞吐量实现了6.3倍的提升。

英伟达还宣布在HuggingFace平台上全面开放Nemotron Nano 2及其相关资源。这包括三个支持128K上下文长度的模型版本,以及用于预训练的大部分数据集。这一举措无疑将推动人工智能领域的进一步发展。

英伟达此次发布的Nemotron Nano 2模型,不仅展示了其在人工智能领域的创新实力,也为业界提供了新的发展方向。随着该模型的广泛应用,我们有理由相信,人工智能将在未来发挥更加重要的作用。