在2025年的科研领域,一项由浙江大学周晓威教授领衔,携手湘江实验室、复旦大学、清华大学及深圳大学共同取得的突破性研究,正引领着AI视频生成技术迈向新高度。这项研究以《视觉动作提示:精准动作至视频生成》为题,于同年8月正式发布,感兴趣的研究者可通过arXiv平台(编号:2508.13104)深入探索其奥秘。

想象一下,当你轻轻挥动手臂,AI便能即时捕捉并解读你的动作意图,随即创造出一段栩栩如生的视频,精准再现你如何灵巧地拿起桌上的水杯、翻阅书页,甚至是操控精密的机械装置。这一曾被视为科幻电影桥段的场景,如今已被浙江大学的研究团队变为现实。他们创新性地提出了“视觉动作提示”技术,为AI赋予了精准理解并再现动作的能力。

传统AI视频生成技术,如同一位只听指令、缺乏观察的机器人。当指令为“拿起杯子”时,它或许能模糊地呈现一个动作,但动作的细节、角度、手指的弯曲程度等,往往难以精准呈现。面对更为复杂的机器人操作,传统方法更是捉襟见肘。这如同教人做手工,却只能口述而无法示范。

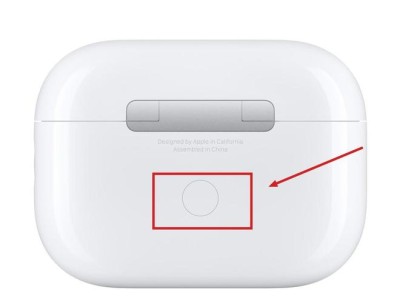

研究团队直击要害,指出问题的核心在于缺乏精准且通用的动作表示方法。他们的解决方案是将复杂动作转化为视觉化的“骨架图”,就像将三维动作压缩为二维线条画,精准传达动作的每一个细微之处。

研究过程如同一场跨界的桥梁建设,需要整合人类手部操作视频与机器人操作记录两类截然不同的数据源。对于人类操作视频,团队开发了一套精细的处理流程,从检测手部动作、确保动作连贯、填补缺失帧,到平滑处理,每一步都如同精心修复老照片。

而对于机器人操作数据,处理则更像是精密的翻译工作。团队将机器人的关节状态转化为骨架图,并通过视觉匹配技术确保骨架图与实际观察一致,仿佛为机器人的每一个动作拍摄了精准的“快照”。

在模型设计上,团队采取了稳健且创新的策略,基于已在大规模数据上训练的CogVideoX模型进行扩展,同时引入ControlNet技术,如同在原有系统中增设了一个专门解读动作指令的“翻译官”,将骨架图转换为模型可理解的信号,精准注入视频生成过程。

实验阶段,团队在多个数据集上进行了全面测试,包括第一人称视角的日常活动片段、第三人称视角的机器人操作片段,以及基础机器人技能片段,确保了技术的广泛适用性和鲁棒性。

与传统方法相比,视觉动作提示技术在多项评估指标上均展现出显著优势,包括图像质量、结构相似性、感知质量及视频质量等。更令人惊叹的是,当将人类手部操作与机器人操作数据混合训练时,模型展现出了惊人的跨域迁移能力,能够执行未见过的新技能,适应全新环境。

团队还探索了不同形式的视觉动作提示,发现骨架图因其便捷性和良好的跨域适应性,成为最实用的选择。消融实验进一步证实了ControlNet组件的关键作用,其缺失会导致生成质量和动作准确性大幅下降。

这项研究的意义深远,不仅在游戏开发领域能够缩短角色动画制作周期,还能在机器人学习中实现快速任务训练,无需复杂编程。在虚拟现实和增强现实应用中,用户的手部动作将能实时转换为虚拟环境中的精确操作。

当然,研究也面临一些挑战,如二维表示在三维空间信息传达上的局限,以及基础模型如何更好地适应动作控制任务等。但这一突破无疑为动作驱动的视频生成开辟了新路径,让AI在理解和模拟复杂人类动作方面迈出了重要一步。

如今,当你再次在电脑前挥动双手,或许不久的将来,AI就能完全理解你的每一个动作意图,开启人机交互的新篇章。