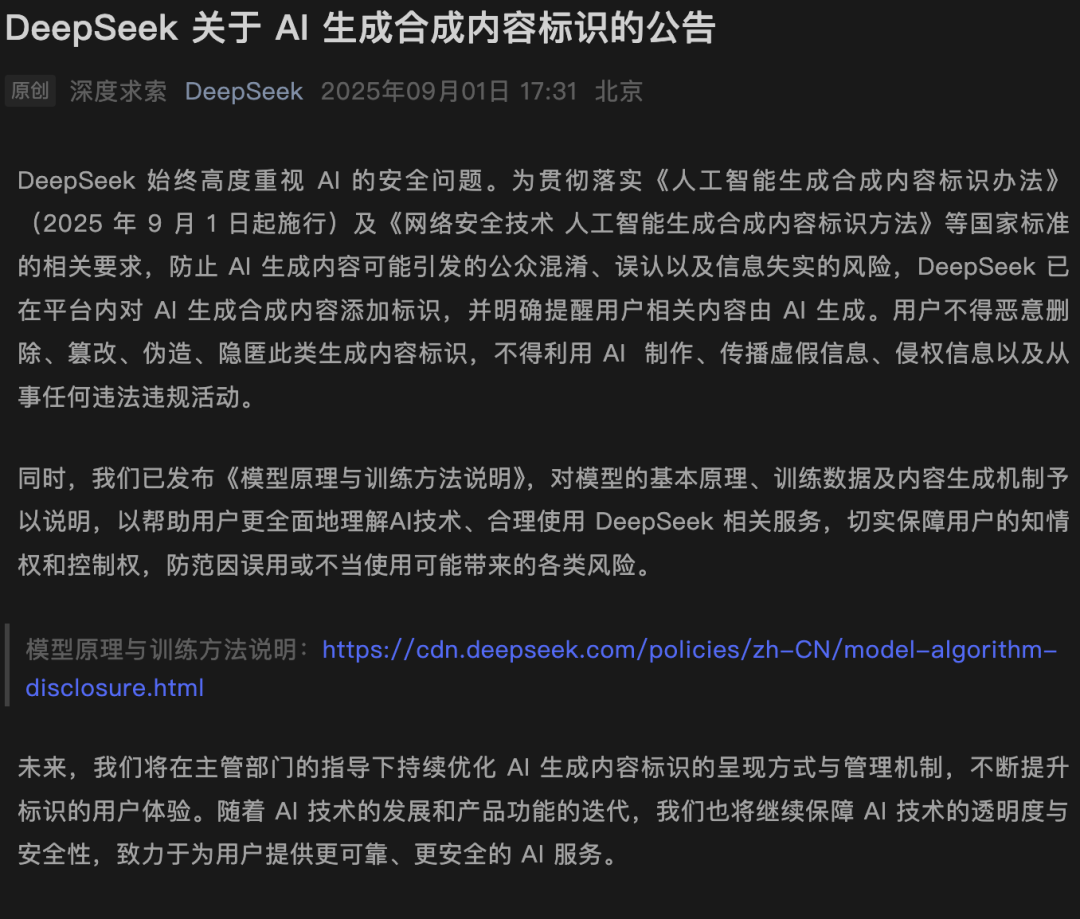

在网信办最新发布的《人工智能生成合成内容标识办法》正式生效的第一天,DeepSeek迅速响应,宣布将对其所有AI生成的内容进行明确标注,确保用户能够轻易识别出这些内容的“AI身份”。此举不仅彰显了DeepSeek对政策的积极响应,也体现了其在技术透明度方面的决心。

DeepSeek通过其官方微博发布了一份公告,明确指出所有由AI生成的内容都将附带“AI生成”的标签。这一措施旨在保护用户免受误导,防止将AI生成的内容误认为是人类创作。同时,DeepSeek还严厉警告用户,严禁恶意删除、篡改或隐匿这些标识,更不得利用AI传播或制作虚假信息。

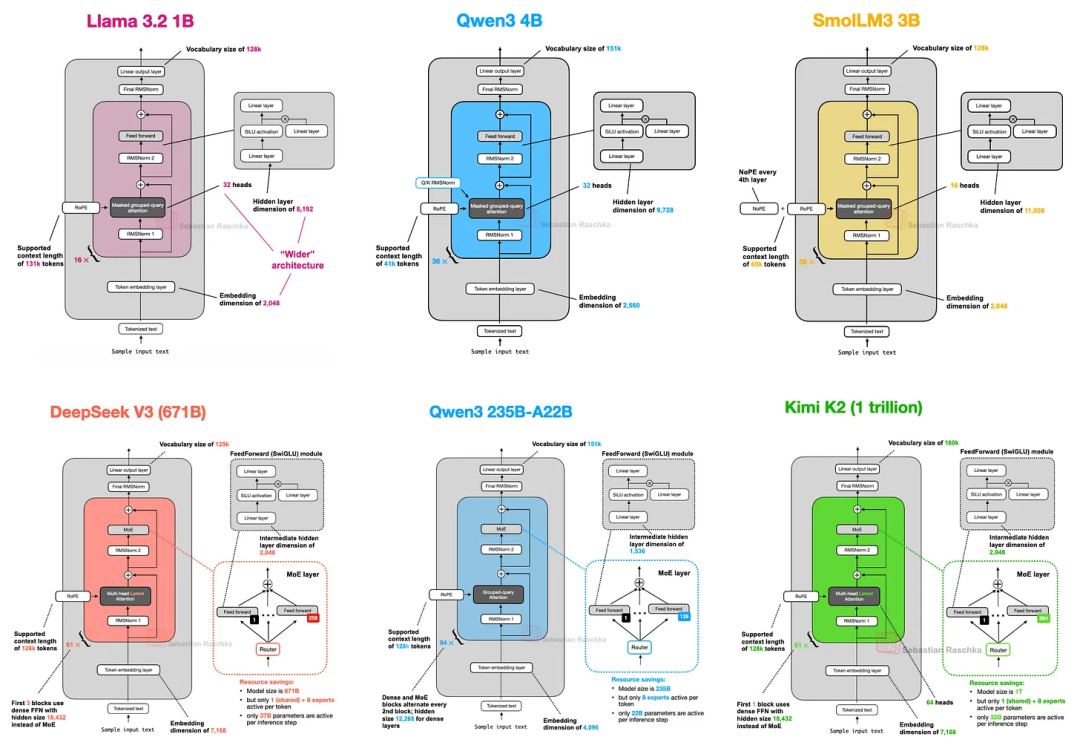

DeepSeek的模型训练过程被分为预训练和优化训练两个环节。预训练阶段旨在通过大规模自监督学习,使模型掌握通用的语言理解与生成能力。而优化训练则是在预训练模型的基础上,通过特定任务的数据进一步调整模型参数,以适应实际应用场景。这一过程不仅涉及复杂的神经网络架构和参数优化算法,还需要高质量、大规模、多样化的数据支持。

DeepSeek还公开了其模型推理的过程,即模型被部署提供服务时的运作方式。推理完成后,模型会输出相应的内容作为响应,包括文字、表格和代码等。这些内容并非简单检索或复制粘贴训练数据中的原始文本,而是基于对语言结构和语义关系的深度理解动态生成的。

值得注意的是,DeepSeek还强调了其模型的开源性。所有模型的权重、参数以及推理工具代码等均已通过开源平台公开发布,并采用宽松的MIT协议供使用者自由下载部署。这一举措不仅有助于推动AI技术的发展和普及,也增加了DeepSeek技术的透明度和可信度。

然而,DeepSeek也坦诚地指出了当前AI技术的局限性,特别是AI生成内容可能存在的错误、遗漏或不符合事实的情况。为降低这种“幻觉”率,DeepSeek采取了一系列技术手段,并在欢迎页、生成文本的末尾以及交互界面底部添加了显著的提示标识,提醒用户内容由人工智能生成,可能不准确。

同时,DeepSeek还高度重视AI技术的滥用风险,包括隐私保护、版权、数据安全、内容安全以及偏见歧视等问题。为此,DeepSeek制定了一系列内部风险管理制度,并开展了模型安全性评估、红队测试等工作,以增强模型和服务的透明度。更重要的是,DeepSeek赋予了用户知情权、选择权和控制权,让用户能够查询服务的基本信息、拒绝其数据用于模型训练以及删除其历史数据等。