在北京举办的AMD Mini AI工作站创新分享沙龙上,一场关于端侧AI的技术革新正在展开。AMD大中华区市场营销副总裁纪朝晖、家用产品市场总监廖金宁及AI市场经理昝仲阳,共同向业界展示了基于锐龙AI Max+395处理器的Mini AI工作站解决方案。这款被称作"生逢其时"的产品,凭借其突破性的技术参数,正在重新定义端侧AI的推理能力边界。

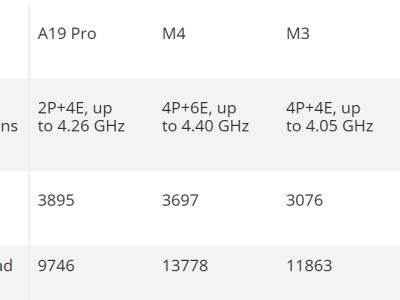

核心突破来自处理器采用的"CPU+IGPU+NPU"异构计算架构。16核32线程的"Zen5"架构CPU最高加速频率达5.1GHz,但真正引发行业震动的是其UMA统一内存架构技术。该技术支持最高128GB内存配置,其中96GB可作为专属显存使用,配合16GB共享显存,形成总计112GB的超大显存容量。这种设计使得设备在运行大型AI模型时,既能保证性能又无需依赖外部显卡。

实测数据印证了技术优势:在本地环境中,该处理器可流畅运行GPT-oss-120B(官方建议显存需求80GB)达到40+Tok/s的处理速度,Llama4 Scout 109B-A17B(需66GB显存)和Qwen3-235B则保持14+Tok/s的运算效率。这种表现使其成为运行混合专家架构(MoE)大模型的理想平台,特别适合需要加载海量参数但激活参数较少的现代AI模型。

价格与性能的平衡成为产品最大卖点。"96GB显存、媲美4060/4070独显的性能,售价不到2万元"——纪朝晖在发布会上强调的这组数据,精准切中了中小企业和开发者的痛点。相比传统15-20万元的AI一体机服务器,Mini AI工作站不仅价格降低80%,更摆脱了对专业机房、特殊供电和专职IT人员的依赖,同时完整支持X86 Windows生态。

应用场景的拓展印证着产品的市场价值。昝仲阳展示的案例显示,从个人开发者的模型训练,到企业团队的智能中枢建设;从家庭AI服务系统,到医疗机构的本地化数据部署,该工作站都能提供可靠支持。特别是在数据安全敏感领域,本地化部署方案有效解决了云端计算的数据泄露风险。

生态建设层面,AMD正构建多维支持体系。与RIPPLE AI合作的开发者平台提供完整工具链,包括文档教程、模板库和远程调试功能,被业界视为"AI时代的树莓派"计划。通过"AMD中国AI应用创新联盟",超过百家ISV合作伙伴正在推动具体应用落地,与魔搭社区联合举办的MCP/Agent挑战赛,更设立了专属硬件赛道。

八大合作伙伴展示的解决方案,展现了产品的多样化可能。Abee推出的水冷工作站将性能释放提升至185W,7.5升体积内集成双网口和USB4接口;惠普Z2 Mini G1a以2.9升机身实现部门级数据分析,售价21999元定位高端商用市场;希未AideaStation R1则面向自媒体工作者,提供本地化AI洞察服务。

零刻GTR9 Pro以12999元价格和双10G网口成为性价比标杆,六联智能的安防解决方案演示了VLM模型的实时视频分析能力。极摩客EVO-X2用2.76升机身刷新体积纪录,天钡NEX395和铭凡MS-S1 MAX则通过差异化接口设计(如80Gbps带宽的USB4 v2接口)满足专业用户需求。

这场技术革新背后,是AMD对AI发展趋势的深刻洞察。随着AI Agent时代来临,本地化部署需求呈现爆发式增长。纪朝晖引用的"AI Agent元十年"理论指出,未来十年将是智能体技术成熟的关键期,而当前市场恰恰缺少合适的硬件平台。锐龙AI Max+395的出现,恰好填补了这一市场空白。

从技术参数到生态建设,从产品矩阵到应用场景,AMD正在构建完整的端侧AI解决方案。当被问及产品定位时,纪朝晖的回答直指核心:"我们要让优质算力像水电一样触手可及,让每个开发者都能负担得起,让AI真正从云端走向身边。"这种普惠理念,或许正是推动AI技术大规模落地的关键所在。