阿里旗下首个深度研究Agent模型——通义DeepResearch正式开源,引发AI圈高度关注。该模型在多项权威基准测试中表现亮眼,不仅在号称“人类最后考试”的HLE榜单中以32.9%的成绩超越DeepSeek-V3.1(29.8%)和OpenAI DeepResearch(26.6%),更在BrowseComp榜单上以43.4%的准确率领跑开源模型。

这款30B参数(激活3B)的模型之所以能实现“小体量、大能量”,核心在于其独特的训练体系。研究团队构建了“智能体合成数据”体系,通过Agentic CPT(增量预训练)技术,将海量知识文档、网页数据、知识图谱及工具使用记录整合为开放世界记忆库,自动生成高质量训练数据。这种“机器生产”模式不仅摆脱了对人工标注的依赖,更通过动作合成技术生成规划、推理、决策三类数据,使模型在离线状态下即可探索海量推理路径。

在数据处理层面,团队开发了WebSailor V2全自动合成方案,通过随机游走构建知识图谱、策略性隐藏关键信息、集合论形式化建模等手段,确保生成的问题既贴近真实场景又具有足够复杂度。特别针对跨学科难题,该方案能驱动配备网络搜索、学术检索工具的Agent,在循环中深化问题,实现任务难度的可控升级。

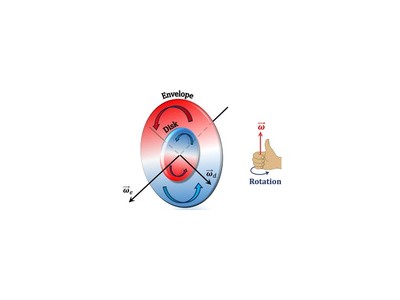

面对长程复杂任务,通义DeepResearch创新采用双模式推理架构。标准任务下,模型通过ReAct模式(思考-行动-观察)凭借128K超长上下文进行多轮次快速交互;极端复杂任务则启动Heavy模式,将任务分解为多个研究轮次,每轮仅提取精华结论构建新工作空间,通过“综合-重构”迭代保持认知焦点。这种设计有效解决了传统单窗口模式的信息过载问题,使模型在HLE、BrowseComp等基准上持续刷新纪录。

训练流程方面,团队打通了“Agentic CPT→SFT→Agentic RL”端到端链路,首次提出两阶段增量预训练范式。在强化学习环节,基于GRPO定制优化的算法通过token级策略梯度损失函数、留一法策略降低估计方差,配合大批量训练维持监督信号稳定性。动态指标显示,模型奖励值持续上升且策略熵保持高位,表明其始终处于探索进化状态。

基础设施层面,团队构建了全栈式训练环境:利用离线维基百科和自定义工具套件创建的仿真平台,摆脱了对实时Web API的依赖;工具沙盒通过缓存结果、失败重试等机制保障交互稳定性;自动数据管理系统形成“生成-训练”正向循环;基于rLLM的异步框架实现多智能体并行训练。这些创新使模型从基座开始,通过预训练、微调、强化学习实现自我进化。

实际应用中,通义DeepResearch已赋能高德“小高老师”和“通义法睿”两大产品。在高德V16版本中,基于Qwen模型微调的POI推理Agent能处理地理区域、交通约束、时间约束等多维度信息,例如用户要求“在西湖边找评分4.5以上、有儿童餐、距地铁站1公里内的浙菜馆”,AI可立即给出最优解及路线规划。法律领域,“通义法睿”通过迭代式规划执行多步查询,依托真实判例和法规提供可追溯分析,在答案要点、案例引用、法条引用质量上超越同类产品。

目前,开发者可在Hugging Face、GitHub、ModelScope获取模型及技术报告。GitHub项目已获7.2k星标,显示出社区的高度认可。Hugging Face联合创始人及斯坦福NLP实验室等科技大V的转发关注,进一步印证了该成果的技术影响力。