在计算机系统与人工智能技术深度融合的背景下,阿里云自主研发的GPU资源池化方案“Aegaeon”凭借其创新性入选国际顶级学术会议SOSP 2025。该方案通过突破传统“一模型一GPU”的硬件绑定模式,实现了GPU资源利用率的大幅提升,目前已在阿里云百炼平台完成核心技术的落地应用。

作为计算机系统领域最具影响力的学术会议之一,SOSP(操作系统原理研讨会)由ACM SIGOPS主办,年均论文收录量不足百篇,被誉为操作系统领域的“奥斯卡”。本届会议聚焦系统软件与AI大模型技术的交叉创新,阿里云的研究成果成为系统层优化支撑AI应用的典型案例。

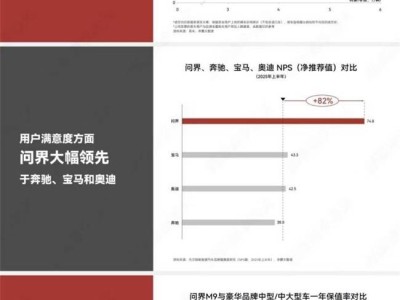

测试数据显示,在阿里云模型市场为期三个月的Beta测试中,Aegaeon系统在支撑720亿参数规模大模型运行时,将英伟达H20 GPU的使用量从1192台压缩至213台,硬件成本削减幅度达82%。这一突破对于依赖大规模GPU集群的AI服务商具有战略意义——在真实业务场景中,少数热门模型(如阿里Qwen)占据绝大多数流量,而大量“长尾”模型长期闲置GPU资源,曾导致17.7%的算力仅处理1.35%的请求。

Aegaeon的核心创新在于Token级动态调度技术。系统在每次生成文本Token后,实时评估是否切换模型,通过组件复用、显存精细管理和KV缓存同步优化等全栈技术,将模型切换开销降低97%,确保亚秒级响应能力。实验表明,该方案支持单GPU同时运行7个不同模型,有效吞吐量较主流方案提升1.5至9倍,请求处理能力提升2至2.5倍。

在2025云栖大会上,阿里巴巴集团CEO吴泳铭宣布了AI基础设施建设的重大战略。他指出,大模型正在取代传统操作系统,成为连接用户、应用与AI算力的核心中间层,而超级AI云将成为下一代计算机的基础形态。为迎接超级人工智能(ASI)时代,阿里云计划在未来十年投入3800亿元建设AI基础设施,并预留追加投资空间。

根据规划,到2032年,阿里云全球数据中心的能耗规模将较2022年增长10倍,这一指数级扩张预示着算力投入的质变。财务数据显示,2025财年第二季度阿里云智能集团收入同比增长26%,创近三年新高,净利润增长76%,表明AI技术投入已产生显著经济效益。

吴泳铭强调,通用人工智能(AGI)的实现只是起点,终极目标是开发出具备自我迭代能力的超级人工智能(ASI)。他预测,未来全球可能仅存在5至6个超级云计算平台,而阿里云将通过全栈AI体系升级,构建从大模型到基础设施的技术闭环。目前,阿里云已形成以通义大模型为核心的操作系统和以AI云为核心的下一代计算机架构,过去一年AI算力增长超5倍,存储能力提升4倍。