人工智能技术发展势头迅猛,但随之而来的能源消耗问题正引发学界高度关注。1986年图灵奖获得者、康奈尔大学计算机科学领域资深教授约翰·霍普克罗夫特近日公开警示,当前人工智能系统在提升计算能力的过程中,正消耗着远超人类认知水平的电力资源,这种技术演进路径可能带来不可持续的生态风险。

这位计算机理论专家通过具体案例揭示了问题的严重性。他指出,现代机器人执行"拾取物品并放置"这类基础动作时,其背后支撑的算法运算需要消耗大量电能,而人类大脑完成相同动作的能量消耗几乎可以忽略不计。这种对比差异促使学界重新审视现有技术范式,霍普克罗夫特特别强调:"我们必须探索更经济的计算模式,现有发展路径存在根本性缺陷。"

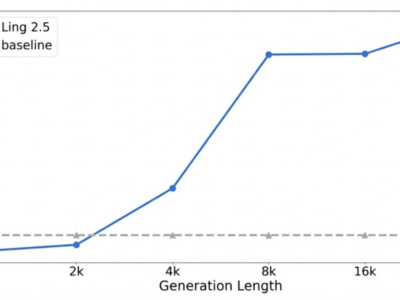

权威研究数据为这种担忧提供了量化支撑。斯坦福大学最新发布的《人工智能技术发展年度评估》显示,主流大模型能耗呈现几何级增长态势:2017年问世的Transformer架构模型训练功耗约为4500瓦,而2024年推出的Llama 3.1-405B模型功耗已飙升至2530万瓦,七年间增长超过5000倍。更值得警惕的是,前沿模型训练所需的电力消耗正以每年翻番的速度激增。

国际能源署的专项报告从产业层面印证了这种趋势。据统计,全球数据中心2024年电力消耗占比达1.5%,较2017年增长近一倍。更令人担忧的是其增速曲线——过去七年年均增长12%,远超全球电力消费3.5%的平均增速。这种增长态势在人工智能算力需求持续扩张的背景下,正在形成难以逆转的能源压力。

学界普遍认为,这种技术发展与能源消耗的失衡状态,已将行业推向关键转折点。如何在保持技术创新活力的同时,构建低能耗、高效率的算法架构,成为计算机科学领域亟待突破的核心命题。部分研究者开始将目光转向神经科学,试图从人类认知机制中寻找突破现有计算范式的灵感,这种跨学科探索或许能为技术可持续发展开辟新路径。