谷歌近日推出了一项颠覆性的AI技术——Gemini 2.5 Flash原生音频模型,标志着语音交互正式迈入“拟人化”新纪元。这项技术突破传统语音交互的局限,无需将声音转换为文字再处理,而是直接解析音频信号并生成自然流畅的语音响应,实现了真正的“端到端”实时交互。

想象这样的场景:在东京街头,一位当地老人用日语急切询问地铁站方向,而你只需佩戴耳机,就能听到精准的中文翻译:“请问地铁站往这边走吗?”更令人惊叹的是,AI不仅完整传递了语义,还完美复刻了老人焦急的语调与呼吸节奏。当你用中文回应时,系统会同步将你的声音转化为自然的日语,保留热情友好的语气,仿佛双方直接对话。

这一突破性功能的核心在于“原生音频处理”技术。传统语音交互需经历“语音转文字-AI处理-文字转语音”的复杂流程,导致情感、停顿等关键信息丢失。而Gemini 2.5 Flash直接解析音频流,在理解语义的同时捕捉语调、节奏等微妙特征,使翻译结果既准确又富有“人情味”。在商务谈判或跨文化沟通中,这种能力能精准传递态度与情绪,避免因机械朗读引发的误解。

实时语音翻译功能已在美国、墨西哥、印度启动Beta测试,支持70余种语言及2000多种语言组合。用户无需频繁点击按钮,系统可持续监听周围环境音,自动识别说话者并切换翻译方向。即使对话中混杂多种语言,或处于嘈杂环境,AI也能通过噪声过滤技术确保清晰沟通。例如,在孟买市场与摊主讨价还价时,系统能自动分离背景叫卖声,专注处理关键对话内容。

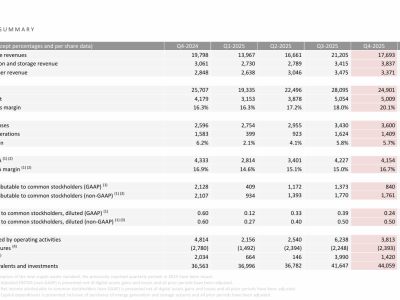

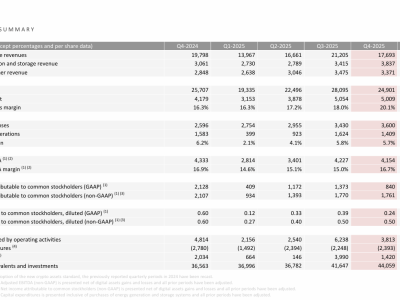

对于开发者而言,这项技术带来了三大核心升级:函数调用精准度提升、复杂指令执行率提高、多轮对话连贯性增强。在测试复杂多步骤操作的ComplexFuncBench Audio评测中,新模型以71.5%的得分领先行业,能无缝整合实时数据(如天气、航班信息)到语音回复中。指令遵循率从84%跃升至90%,可精准执行“用特定格式回答且语气严肃”等细化要求。上下文记忆能力显著优化,即使长达20轮的对话,AI仍能准确引用早期信息,配合低延迟响应,营造“真人对话”的沉浸感。

技术突破的背后,是谷歌对语音交互入口的战略布局。从Gemini Live到Search Live,再到耳机端的实时翻译,AI正从屏幕延伸至听觉维度。2026年,该功能将通过Gemini API扩展至更多产品,企业构建智能客服的门槛大幅降低——一个能理解复杂指令、记忆对话上下文、传递情感语气的AI助手,将成为标准配置。

技术迭代的速度远超预期。当Siri仍困于简单指令时,Gemini已能实现跨语言情感交流。这项技术已在Vertex AI平台全面上线,Google AI Studio同步开放试用。或许第一次听到AI用你的语气说出外语时,你会真切感受到:那个无需背诵单词、一个耳机走遍世界的未来,已悄然来临。