OpenAI前联合创始人、Thinking Machines首席科学家John Schulman在近期访谈中提出,若早期团队充分意识到规模扩展的回报率,ChatGPT的诞生时间可能大幅提前。他以2018-2019年为时间节点分析,认为仅需数位顶尖研究人员投入一年左右,即可构建出接近GPT-3.5水平的系统。这一判断基于当前工程优化经验的逆向推导,例如通过更高效的微调策略与数据构造技术,可显著提升模型有效算力利用率。

作为强化学习领域权威专家,Schulman的学术履历印证了其技术洞察力。他在博士期间师从强化学习先驱Pieter Abbeel,主导开发的PPO算法至今仍是ChatGPT核心技术RLHF的基础组件。2024年其职业轨迹出现转折,在短暂加盟Anthropic后,转而担任Thinking Machines首席科学家,该机构由OpenAI前CTO Mira Murati创立,致力于探索新型研究范式。

回顾OpenAI发展初期,Schulman将其描述为"学术草台班子":2016-2017年的团队架构呈现显著非正式特征,研究项目多由个人兴趣驱动,研究产出常以论文或博客形式呈现。这种松散模式孕育出重要突破,例如Dota项目通过大规模强化学习实现复杂策略游戏突破,但更多尝试沦为技术死胡同。典型案例包括早期通用强化学习环境Universe,该平台因系统臃肿与泛化能力不足最终被放弃,却为后续研究提供了关键经验。

针对当前AI研究生态,Schulman指出新锐机构面临结构性挑战。相较于早期OpenAI的愿景自然涌现模式,现代公司往往陷入"追赶陷阱"——在达到技术前沿前难以开展探索性研究。这种环境可能导致探索文化的缺失,而培养该能力需要从组织创立初期持续投入。他特别强调工程能力的重要性,指出随着模型规模扩大,研究人员需具备扎实软件工程基础,纯理论探索的价值相对下降。

在技术路线方面,Schulman预测联合训练生成器与验证器将成为核心方向。这种多智能体博弈框架通过自我强化循环提升系统能力,类似辩论模型的理论机制可能重新获得重视。对于持续学习难题,他认为上下文学习在短期任务中具有不可替代性,而长期记忆仍需依赖参数更新。离线强化学习被视为潜在突破口,其技术路径与当前语言模型训练存在相似性。

关于通用人工智能(AGI)发展时间表,Schulman提出经验性修正系数。基于工程领域普遍存在的进度低估现象,他认为实际达成时间可能比多数预测延长2-3倍。自动驾驶领域的延迟案例被作为重要佐证,尽管AI的自我加速效应可能改变这一规律,但人类理解瓶颈等未知因素仍构成重大不确定性。这种审慎态度与其早期经历相关——在AlphaGo等项目影响下,OpenAI始终保持工程严谨性与研究前瞻性的平衡。

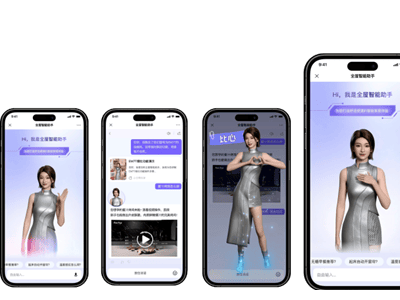

Thinking Machines最新发布的Tinker平台体现了这种技术哲学。该微调API通过抽象底层复杂性,为研究者提供类似模型采样服务的训练体验。当前版本主要面向专业用户,未来计划通过工具链扩展支持多模态训练与大规模任务。公司计划明年发布自主训练模型,同时持续优化Tinker的功能层级,最终实现"业务问题到模型解决方案"的无缝转化。