人工智能领域迎来一项突破性进展——多家科研机构联合开发出一种新型视频推理技术,使机器能够像人类一样通过观察动态画面理解空间关系并做出决策。这项研究通过构建包含近8000个迷宫场景的VR-Bench测试平台,验证了视频推理模型在复杂空间任务中的卓越表现,相关成果已发表于权威学术平台。

传统AI在处理空间推理任务时,主要依赖将视觉信息转化为文字描述的推理方式。这种方法如同通过电话描述舞蹈动作,当面对复杂迷宫时,纯文字指令容易导致方向迷失。研究团队创新性地提出"视觉优先"策略,让AI直接从视频帧的连续变化中捕捉空间逻辑,就像通过观看舞蹈视频直接学习动作要领。

VR-Bench测试平台设计了五类挑战任务:规则网格迷宫考验基础路径规划,曲线通道迷宫需要理解非标准空间关系,陷阱区域任务要求风险评估能力,推箱子场景涉及多步骤策略规划,3D立体迷宫则扩展至三维空间推理。每种任务均设置简单、中等、困难三个等级,并采用石墙、玻璃幕墙等不同视觉风格,确保测试的全面性。

实验数据显示,视频推理模型Wan-R1在多项指标上表现惊艳。在最具挑战性的3D迷宫任务中,该模型达到100%成功率,路径长度仅比最优解多10%,而传统模型成功率不足30%,路径冗余度高达400%。当模型对同一问题生成多个解决方案并择优选择时,成功率可进一步提升10-20%,这种"试错优化"机制与人类探索行为高度相似。

技术实现层面,研究团队开发了链式帧推理架构。该系统通过分析视频帧的时空连续性,理解当前位置、可行方向等关键信息,并预测下一步最优动作。训练过程中采用广度优先搜索生成最优解视频,使模型学会识别有效路径与死胡同。值得注意的是,仅用简单迷宫训练的模型就能处理复杂场景,证明其掌握了通用空间推理能力而非机械记忆。

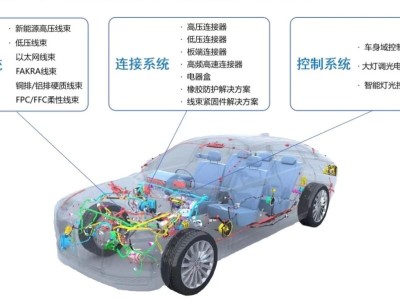

这项突破为多个领域带来应用曙光。在机器人导航领域,清洁机器人可通过观察房间布局自动规划清洁路径,并在家具移动后快速适应新环境;自动驾驶系统能更精准理解交通参与者的行为意图;医疗影像分析可借助动态成像数据提升诊断准确性。游戏AI、工业自动化、安防监控等行业也将因此受益。

当前技术仍面临计算资源需求大、现实场景复杂性高等挑战。研究团队正探索模型压缩技术以降低算力要求,同时通过元学习提升模型对新环境的适应能力。下一步计划将视频推理与大语言模型结合,开发能同时处理视觉和文本信息的多模态系统,并建立包含物理推理、因果推理等更广泛任务的评估体系。

针对伦理考量,研究团队强调需建立相应的监管框架。视频推理技术的强大观察能力若被滥用,可能引发隐私泄露风险。因此,在推动技术落地的同时,必须确保其应用符合人类价值观和社会规范。

Q&A环节,研究人员解释了视频推理与传统方法的本质区别:前者如同直接观看地图导航,后者则像通过电话指路。当被问及技术落地时间表时,他们表示正在与多家企业合作开发示范应用,预计未来3-5年内将在特定场景实现商业化部署。关于模型可解释性,团队透露正在开发可视化工具,帮助用户理解AI的决策逻辑。