近日,一款名为DeepSeek V4的开源AI模型引发科技圈热议。这款被网友称为“开源新王”的模型,据传在多项基准测试中超越了Claude Opus 4.5和GPT-5.2等顶尖闭源模型,尤其在编程能力上展现出惊人实力。尽管官方尚未正式发布,但泄露的测试数据已让整个AI社区沸腾。

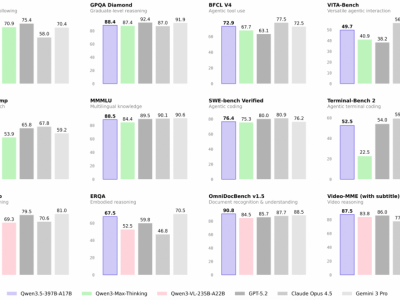

根据网络流传的测试结果,DeepSeek V4在SWE-bench Verified编程基准测试中取得了83.7%的得分,超越了Claude Opus 4.5的80.9%和GPT-5.2的80%。这一成绩若经证实,将直接改写当前最强代码模型的排名。更令人震惊的是,该模型在AIME 2026数学竞赛测试中达到99.4%的准确率,在FrontierMath Tier 4前沿数学推理测试中取得23.5%的得分,是GPT-5.2的11倍。

技术专家分析指出,DeepSeek V4的突破不仅体现在分数上。该模型具备100万token的上下文处理能力,配合全新的Engram条件记忆机制,使其能够理解大型代码库中文件间的复杂关联。这种“全仓库级推理能力”对企业级软件开发具有革命性意义——开发者可以依赖AI理解整个项目结构,在正确位置插入新功能或修复bug,而无需担心上下文丢失问题。

然而,这些惊人的测试数据也引发了质疑。Epoch AI等机构证实,FrontierMath数据集的评估权限仅开放给特定机构,网络流传的分数存在伪造可能。更有专家指出,在官方评分系统下,AIME测试的最高分应为100%(120/120),而99.4%的得分存在统计异常。这些争议使得DeepSeek V4的真实性能仍笼罩在迷雾之中。

尽管如此,DeepSeek V4的潜在影响力已不容忽视。据知情人士透露,该模型可能采用2000亿参数架构,但未使用与北大联合开发的Engram记忆机制。灰度测试显示,其API文档标注的上下文长度仍为128K,与宣称的100万token存在差距。这种“低调测试”策略被解读为技术验证阶段的重要步骤。

在模型架构层面,DeepSeek持续推动创新。meta科学家Zhuokai Zhao的研究表明,当前前沿稀疏专家模型已形成标准配方:MLA架构结合sigmoid激活函数,配合共享专家模块和无辅助损失设计,正在成为行业新标准。而DeepSeek在V3.2版本后,持续在模型架构、记忆机制和视觉推理等领域探索,为V4的突破奠定了技术基础。

这场开源与闭源模型的竞争,正演变为技术理念的交锋。DeepSeek V4若能兑现承诺,将以开放权重模式打破闭源模型的技术垄断,为全球开发者提供低成本、高性能的替代方案。其引发的讨论,已超越单纯的技术比较,成为AI发展路径选择的重要参照。