DeepSeek近日发布了面向OCR场景的专用模型DeepSeek-OCR 2,并同步公开了技术报告。这一模型在原有基础上进行了升级,通过引入新型解码器,使模型在处理图像和文件时更接近人类阅读习惯,而非传统机械扫描方式。

传统OCR模型通常采用从左上到右下的地毯式扫描模式,而DeepSeek-OCR 2则能够理解文档结构,按照逻辑顺序逐步解析内容。这种改进使其在处理复杂布局、公式和表格时表现更佳。在文档理解基准测试OmniDocBench v1.5中,该模型取得了91.09%的得分,较前代提升3.73%,在端到端OCR模型中达到领先水平,但仍略低于百度的PaddleOCR-VL管线。

在视觉token效率方面,DeepSeek-OCR 2在相似预算下,文档解析的编辑距离低于Gemini-3 Pro,证明其在保持高性能的同时实现了更高的视觉信息压缩率。该模型不仅可作为新型视觉语言模型(VLM)架构的研究工具,还能生成高质量预训练数据,支持大语言模型训练。

从技术架构看,DeepSeek-OCR 2延续了编码器-解码器结构,但将编码器从DeepEncoder升级为DeepEncoder V2。新编码器采用基于大语言模型(LLM)的设计,通过因果流查询机制实现视觉标记的语义重排序。这一过程不依赖固定位置编码,而是让模型根据全局视觉上下文动态生成顺序,更符合人类认知习惯。

DeepEncoder V2通过视觉tokenizer实现约16倍的token压缩,在降低计算资源消耗的同时保留关键视觉信息。其核心创新在于因果查询机制:每个查询可访问所有视觉标记及先前查询结果,在保持token数量不变的前提下完成语义排序和信息蒸馏。最终仅有序查询结果被输入解码器,形成编码器与解码器的两级因果推理流程。

模型训练分为三个阶段:编码器预训练、查询增强和解码器专业化。预训练阶段使编码器掌握特征提取和token重排序能力;查询增强阶段进一步提升重排序精度和视觉知识压缩效率;解码器专业化阶段通过冻结编码器参数优化解码效率。实验采用OmniDocBench v1.5基准,包含1355个中英文文档页面,覆盖杂志、学术论文等9个类别。

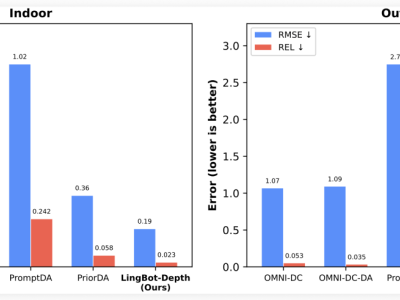

测试结果显示,DeepSeek-OCR 2在最小视觉标记上限设置下达到91.09%的准确率,阅读顺序编辑距离从0.085降至0.057。在1120个视觉标记预算下,其文档解析编辑距离(0.100)优于Gemini-3 Pro(0.115)。不过,该模型在处理高密度报纸文本时表现稍逊,可通过增加局部裁剪或扩充训练样本改善。

DeepSeek-OCR 2的架构设计为多模态编码器发展提供了新思路。研究团队认为,这种基于LLM的编码器有望演变为统一处理文本、语音和视觉内容的全模态编码器,通过共享参数空间实现不同模态信息的有效压缩与重组。此次发布标志着原生多模态探索的重要进展,为后续VLM架构研究奠定了基础。