杭州互联网法院近日就国内首起因“AI幻觉”引发的侵权纠纷案件作出一审判决,驳回原告梁某的全部诉讼请求。该案源于一名高考生家属在使用某AI平台查询高校信息时,收到与事实严重不符的答复,平台曾承诺“内容错误赔偿十万元”,但法院认定此类承诺不构成法律意义上的责任承担依据。

案件审理过程中,法院明确指出生成式人工智能不具备民事主体资格,其生成的表述无法代表平台真实意志。涉事企业已通过用户协议履行风险提示义务,并采取算法过滤、人工抽检等技术防控措施,主观上不存在过错。这一判决在现行法律框架下为AI服务提供者划定了责任边界,既承认技术发展阶段的局限性,也强调企业需在合理范围内承担管理义务。

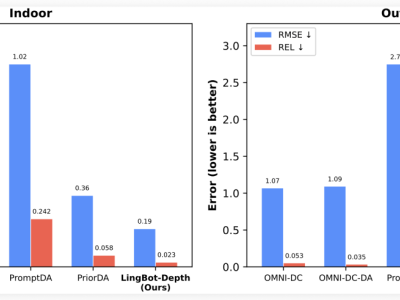

技术层面分析显示,“AI幻觉”现象主要源于三个维度:训练数据存在知识盲区导致信息缺失,算法逻辑缺陷引发逻辑跳跃,以及上下文理解偏差造成语义扭曲。部分企业为追求响应速度,过度侧重模型运算效率优化,反而弱化了事实核查模块的研发投入,这种技术路径选择客观上放大了错误信息生成概率。某大模型研发团队负责人坦言,当前技术条件下完全消除幻觉仍存在挑战,但通过数据清洗、交叉验证等手段可显著降低风险。

行业专家建议,解决“AI幻觉”问题需构建多维防控体系。技术端应重点突破数据质量提升、不确定性量化评估等关键技术,建立动态更新的知识图谱;产品端需设计差异化的服务模式,对创意类应用保留适度容错空间,对专业服务实施强制校验机制;监管端可探索建立AI生成内容标识制度,要求平台对输出结果进行可信度分级标注。

市场调研显示,超过60%的用户对AI信息准确性存在担忧,这一信任危机正制约技术商业化进程。某科技公司公布的改进方案显示,其新一代模型通过引入实时搜索引擎接口,将事实性错误率降低了43%。法律学者提醒,在技术迭代过程中,企业既要保持创新活力,也要建立完善的风险补偿机制,避免将技术缺陷成本转嫁给消费者。