在静谧的夜晚,全球AI开发者们迎来了一场意想不到的惊喜。没有盛大的发布会,没有铺天盖地的新闻稿,甚至连基本的更新说明都付诸阙如,但中国开源大模型DeepSeek的又一次飞跃,却在凌晨两点的默默更新中,被全球的技术爱好者共同见证。

与OpenAI、Anthropic等巨头的高调发布模式截然不同,DeepSeek此次更新采取了近乎隐秘的方式。仅在微信群内简短通知后,工程师团队便于29日凌晨将最新版本悄然上传至HuggingFace平台,连模型卡片都未及更新,便匆匆离去,留下满世界的开发者们自行探索。

这种低调行事,几乎成为了DeepSeek的独特标识。今年3月,当V3模型悄然问世时,同样未引起广泛关注,直到开发者们自行测试,才发现其性能已悄然超越了Claude 3.7 Sonnet。业内有人猜测,DeepSeek团队或许认为,只要模型架构未发生根本性变化,便不足以构成大版本升级,这种务实态度,彰显了中国团队对技术本质的深刻洞察。

尽管官方未对新版本性能做出任何说明,但全球开发者社区却迅速自发组织起对新模型的全面测试。测试结果令人惊叹不已:在权威编程评测平台Live CodeBench上,DeepSeek-R1-0528的得分紧随OpenAI o4-Mini(Medium)之后,位列第四。要知道,这些都是OpenAI旗下的高性能商业模型,而DeepSeek-R1-0528不仅性能接近,更重要的是它开源且免费。

一位开发者尝试让DeepSeek-R1-0528编写一个俄罗斯方块网页游戏,仅思考9秒后,它便一次性完成了所有代码,并且可以直接在网页上运行。经过仔细测试,游戏运行流畅,界面设计也颇为出色,让人不禁感叹其强大的代码生成能力。

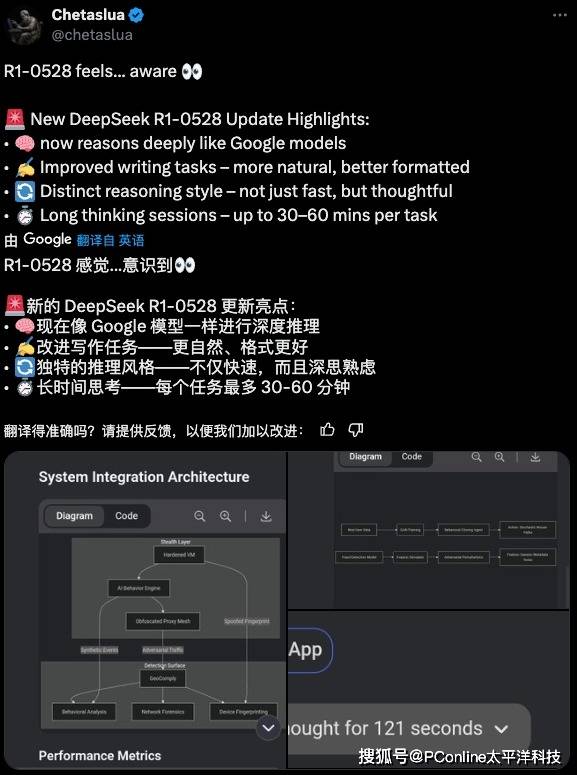

除了代码能力之外,新模型在其他方面也取得了显著进步。其写作风格更加正常化,早期版本中用户诟病的“量子力学式表达”问题得到了明显改善,输出更加自然流畅;结构化思维显著增强,在解决复杂问题时展现出清晰的思维链条和严密的逻辑推进;长文本处理能力也有所优化,在32K上下文长度内,文本召回准确率明显提升。

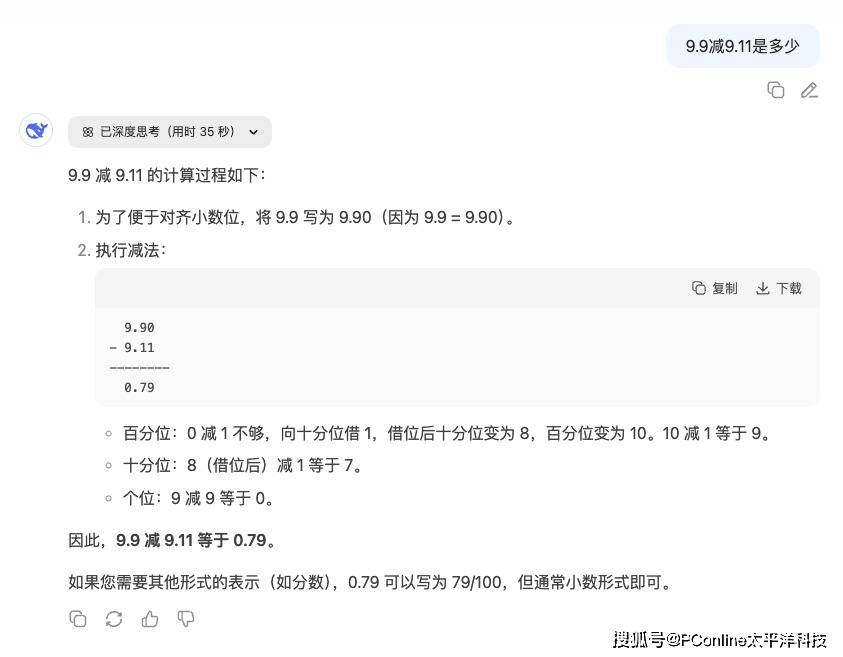

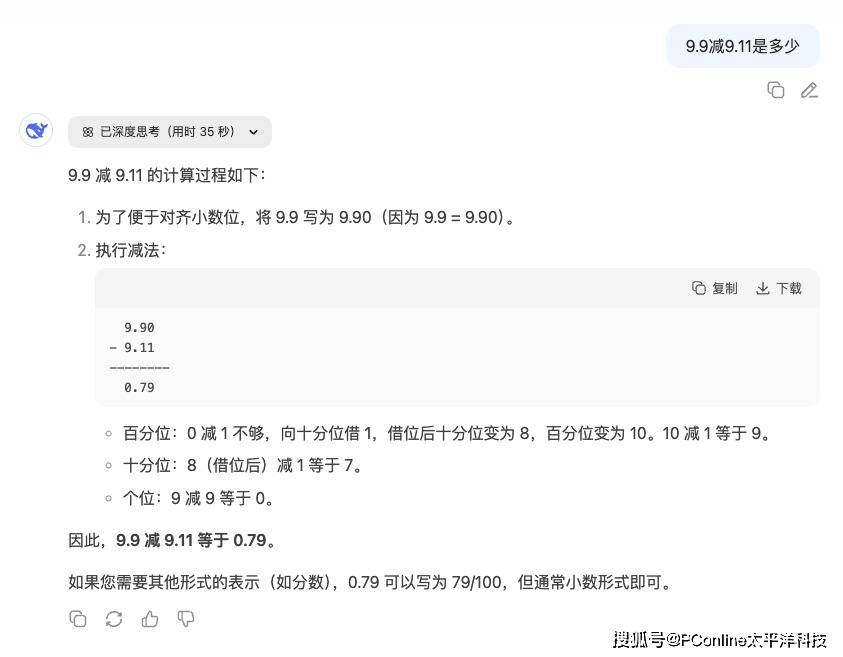

最引人注目的,莫过于新模型新增的长时思考能力。新R1单任务处理时间可达30-60分钟,有用户实测遇到模型“长考”212秒才给出答案,远超之前版本。这种深度思考机制,使其成为目前唯一能持续正确回答“9.9减9.11是多少”的模型。

R1的惊艳表现,引发了全球AI社区对R2的无限遐想。在社交媒体上,关于R1升级的讨论下,充斥着对R2的询问和期待。据传,R2将采用混合专家模型(MoE)架构,参数量高达1.2万亿,较R1提升80%,推理成本大幅降低,性价比突破想象,芯片利用率高达82%。

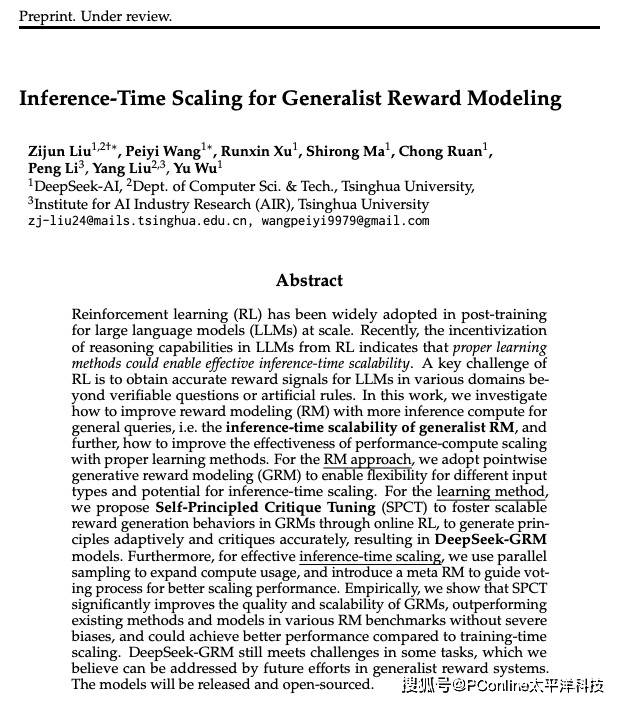

更值得注意的是,DeepSeek与清华大学联合发布的《自我原则点评调优》(SPCT)论文,提出了元奖励模型(meta RM)新方法,被视为R2的技术前兆。这一系列举措,不仅展示了DeepSeek团队在技术研发上的深厚底蕴,也揭示了中国AI团队独特的发展哲学:不重版本号,只重实际能力提升。

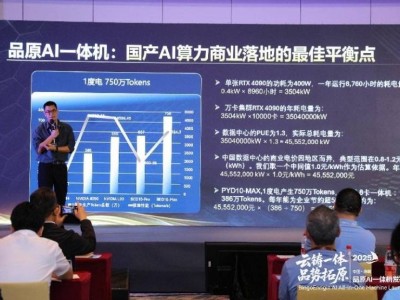

当商业公司热衷于通过版本迭代制造营销热点时,DeepSeek却将资源投入到实质性能突破上。这种务实精神,带来了惊人的性价比。DeepSeek-V3-0324的输入成本仅为Claude Sonnet 3.7的1/11,GPT-4.5的1/277。而新R1作为开源模型,其性能却直逼天价商业产品。这不仅是对开源精神的胜利,更是对整个AI行业创新速度的极大推动。