近日,DeepSeek R1模型迎来了其小版本的迭代更新,新版本被命名为DeepSeek-R1-0528。用户只需通过官方网站、APP或小程序进入对话界面,并启用“深度思考”功能,即可亲身体验这一最新版本。与此同时,API接口也已完成同步更新,用户调用方式保持不变。

官方今日发布了详尽的更新说明,深入介绍了此次升级的核心亮点。DeepSeek-R1-0528继续以2024年12月发布的DeepSeek V3 Base模型为基础,但在后续训练阶段加大了算力投入,显著增强了模型的思维深度和推理能力。

经过此次升级,DeepSeek-R1-0528在数学、编程及通用逻辑等多个基准测试中取得了卓越成绩,不仅在国内模型中独占鳌头,而且在整体表现上已逼近国际顶尖模型,如o3和Gemini-2.5-Pro。各项评测集上的优异表现充分验证了其性能的提升。

特别是在复杂推理任务中,新版模型较旧版有了显著提升。以AIME 2025测试为例,新版模型的准确率从70%跃升至87.5%。这一显著进步得益于模型在推理过程中的思维深度增强。旧版模型在AIME 2025测试集上平均每题使用12K tokens,而新版模型则达到23K tokens,显示出更为详尽和深入的解题思考过程。

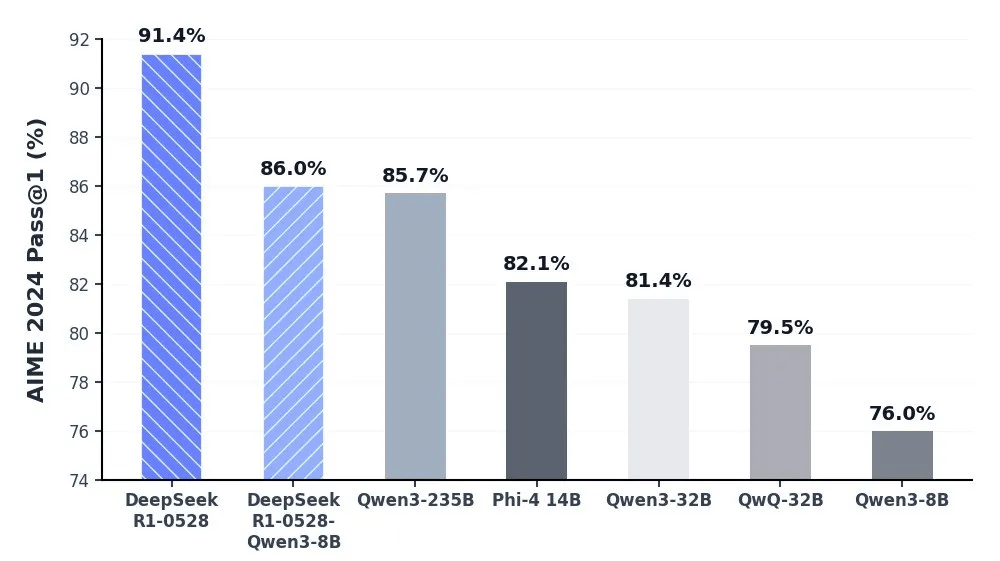

DeepSeek团队还利用DeepSeek-R1-0528的思维链蒸馏训练了Qwen3-8B Base,推出了DeepSeek-R1-0528-Qwen3-8B模型。在数学测试AIME 2024中,该8B模型仅次于DeepSeek-R1-0528,超越Qwen3-8B达10.0%,与Qwen3-235B表现相当。这一成果对学术界推理模型研究及工业界小模型开发具有重要意义。

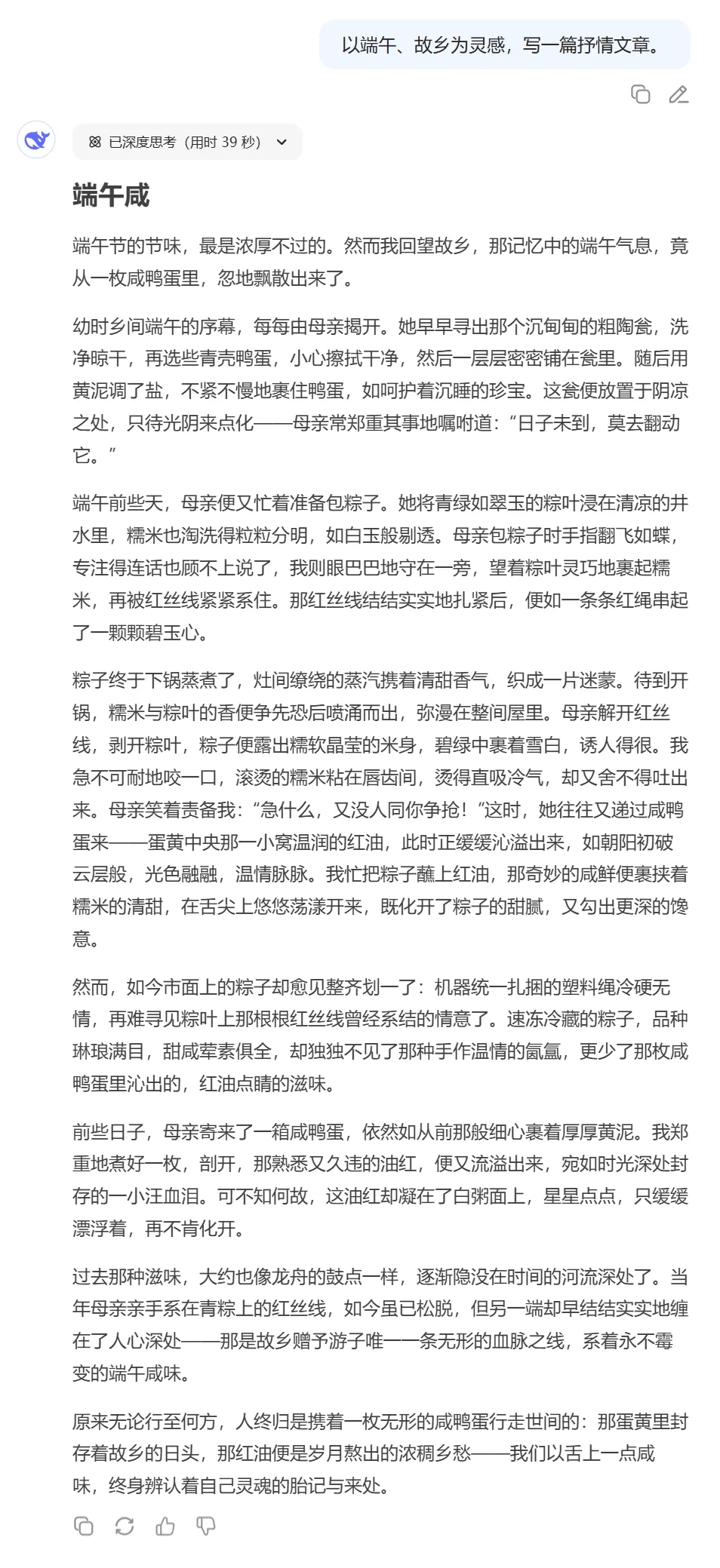

除了推理能力的强化,新版DeepSeek R1还针对“幻觉”问题进行了优化。在改写润色、总结摘要、阅读理解等场景中,新版模型的幻觉率较旧版降低了约45%~50%,提供了更为准确、可靠的结果。同时,在创意写作方面,新版模型进一步优化了议论文、小说、散文等文体的输出,能够创作出篇幅更长、结构更完整、风格更接近人类偏好的长篇作品。

在工具调用方面,DeepSeek-R1-0528也展现了一定的能力(但暂不支持在“思考”模式中进行工具调用)。当前,该模型在Tau-Bench测评中的成绩为airline 53.5%、retail 63.9%,表现与OpenAI o1-high相当,但仍与o3-High及Claude 4 Sonnet存在差距。新版模型在前端代码生成、角色扮演等领域的能力也有所提升。

DeepSeek团队此次依旧保持了开源的传统,新版模型的开源仓库(包括模型权重)均采用MIT License,允许用户利用模型输出、通过模型蒸馏等方式训练其他模型。这一举措无疑将进一步推动人工智能领域的创新与发展。