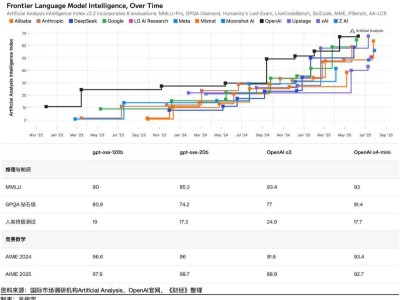

小红书旗下的hi lab近日宣布了一项重要技术进展,正式对外开源dots模型家族的首个视觉语言模型——dots.vlm1。这一模型的创新之处在于其构建基础,它融合了一个拥有12亿参数的强大视觉编码器以及DeepSeek V3 LLM技术。通过实施大规模的预训练和精细调优,dots.vlm1在视觉感知与逻辑推理能力上,已经逼近了业界的顶尖水平。

dots.vlm1的问世,标志着小红书在AI技术研发领域迈出了坚实的一步。该模型的开发团队充分利用了海量数据资源,通过复杂的训练流程,使得dots.vlm1能够高效处理和理解图像与文本之间的复杂关系。这一成就不仅展现了小红书在视觉语言模型领域的深厚积累,也为未来的应用场景提供了广阔的可能性。

据悉,dots.vlm1的开源将有助于推动整个AI社区的技术进步。开发者们将能够基于这一模型进行二次开发和创新,进一步拓展视觉语言模型的应用边界。无论是智能图像识别、跨媒体检索,还是人机交互等领域,dots.vlm1都有可能成为推动行业发展的关键力量。