在数字化浪潮汹涌的今天,AI大模型已成为科技领域备受瞩目的焦点。尤其在近两年的讨论中,这一话题几乎无处不在,吸引了无数科技从业者与研究人员的密切关注。作为人工智能领域最前沿的技术突破方向,AI大模型以其巨大的参数量、海量的训练数据以及能够执行从文本生成到图像识别等一系列复杂任务的能力,展现了强大的模式识别与推理潜力。对于寻求掌握核心AI技术或在特定行业内实现智能化升级的企业和团队而言,独立或参与搭建AI大模型无疑是一条既充满挑战又蕴藏巨大机遇的道路。

AI大模型的搭建,是一个涉及多个环节的复杂系统工程。首先,明确核心目标与应用场景是基础中的基础。无论是专注于自然语言处理,如智能客服对话或文档摘要生成,还是在图像识别领域,如医学影像分析或工业质检方面发挥作用,不同的应用场景对模型的架构、规模及性能指标有着截然不同的要求。模糊的目标将导致后续工作缺乏明确方向,容易浪费宝贵的时间和资源。

硬件资源的评估和准备同样至关重要。AI大模型的训练对计算资源的要求极为苛刻,通常需要配备高性能的GPU,甚至在某些高要求场景下还需用到TPU。具体所需数量和型号需根据模型的预期参数量、训练数据总量及期望训练时间综合评估。存储资源和网络环境也是不可或缺的一环,海量训练数据需要高速、大容量的存储系统支撑,而稳定且高速的网络环境则对分布式训练中多个计算节点间的数据传输和协同至关重要。

资金预算规划同样不可忽视。高性能芯片的采购、软件许可费用、数据采集与标注成本,以及项目周期内的人力成本、能源消耗等,都需要详细核算和规划。AI大模型搭建往往耗资巨大,充足的资金保障是项目顺利推进的关键。

在搭建过程中,高质量数据的获取、清洗与预处理是核心环节之一。数据采集需多样化,以确保模型学习的知识全面且具有泛化能力。数据清洗则要去除噪音、错误及敏感信息,确保数据的真实性和准确性。数据预处理则是将数据转换成模型能理解的格式,如文本的分词处理、向量化,以及图像数据的大小调整和归一化处理等。

模型架构的选择与设计同样至关重要。目前主流的AI大模型多采用先进的架构,但具体选择需依据实际情况。快速原型验证或受条件限制时,可考虑基于现有预训练模型架构进行微调。然而,若追求前沿技术突破或有特殊定制化需求,则需在现有架构基础上进行创新改进,甚至设计全新架构,这对研发团队的技术实力和创新能力提出了极高要求。

模型训练过程中,选择合适的深度学习框架、配置好超参数、采用分布式训练策略,以及密切监控模型指标,都是不可或缺的挑战与策略。超参数的选择和调整对模型训练效果和收敛速度影响巨大,需多次实验和调优。分布式训练策略则能提高训练效率,但需解决设备间通信和同步等问题。训练过程中还需密切关注模型表现,及时分析原因并调整策略,以避免过拟合或欠拟合。

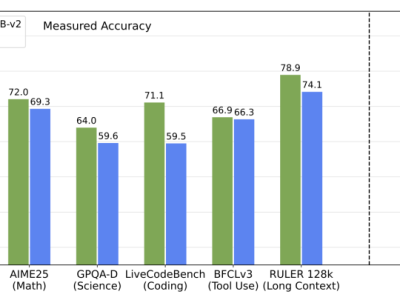

模型的评估与持续优化是一个迭代往复的过程。使用独立的测试数据集对模型进行全面评估,检查其在语言理解、文本生成、逻辑推理等方面的表现。根据评估结果,有针对性地对模型结构、训练数据、超参数或训练方法进行调整和改进,直至达到预期目标。这个过程虽耗费时间和精力,却是提升模型质量的关键。

针对AI大模型搭建过程中的一些常见困惑,以下是几个问题的解答。例如,关于“究竟参数量多大的模型才能算得上是‘大模型’”这一问题,实际上并没有一个固定的标准。模型的“大”与“小”更多取决于其应用场景、任务需求以及所能达到的性能表现。

AI大模型的搭建之路虽充满挑战,但正是这些挑战孕育了无限机遇。随着技术的不断进步和应用场景的不断拓展,AI大模型将在未来发挥更加重要的作用,为人类社会带来更多创新和变革。