当机器人从实验室走向真实场景,其能否稳定完成复杂任务成为具身智能领域的关键争议。近年来,基于数字孪生的仿真测试虽能低成本验证算法,却因物理建模失真、场景迁移困难等问题,始终无法真实反映机器人在现实环境中的鲁棒性。为此,全球首个大规模、多任务的真实机器人操作基准测试平台RoboChallenge正式发布,通过统一硬件标准、创新评估机制与云端化服务,为机器人技术落地提供可复现的评测体系。

传统机器人评测存在两大瓶颈:任务设计单一与评价机制粗放。多数竞赛仅设置3-5个孤立任务,且采用“成功/失败”的二值化标准,既无法评估模型跨场景泛化能力,也难以捕捉执行过程中的细节差异。例如,某模型可能在抓取任务中完成目标,却因路径规划低效或抗干扰能力弱,在实际应用中频繁出错。RoboChallenge的创新在于将不确定性、统计性与多元性纳入评测框架,通过端到端任务成功率与过程评分结合的方式,精确量化模型性能差异。

该平台的硬件选型聚焦算法核心能力,首期采用UR5、Franka Panda等四款工业级机械臂作为标准化平台。这些机型经长期验证,具备7×24小时持续运行能力,并支持多视角RGB与深度信息同步输出。更突破性的是,RoboChallenge通过云端化服务构建远程真机实验室,用户无需拥有实体机器人,仅需通过标准化API接口即可调用真机资源。其无容器化服务架构允许用户直接提交动作指令,所有观测数据附带毫秒级时间戳,确保多模型集成与复杂算法验证的精准性。

为降低技术门槛,平台提出“视觉输入匹配”方法:从演示数据中抽取参考图像,实时叠加于测试画面,测试人员通过调整物体位置使场景与参考图像完全吻合,从而保证每次测试的初始状态一致。双向异步控制技术将动作指令提交与图像获取分离,用户可自定义数据块长度与动作持续时间,平台实时反馈队列状态,兼顾安全性与便捷性。智能作业调度系统则支持模型预加载与多任务并行管理,大幅提升评测效率。

作为评测体系的核心,Table30基准测试集包含30个日常情境任务,覆盖家庭、工作、厨房等场景,任务难度从基础操作到复杂组合逐级递增。例如,“插花”任务要求机器人精准对位花枝与花瓶,“叠抹布”需处理软体物体的形变问题,“开关水龙头”则考验力控精度。每个任务被细分为若干阶段并分配进度点,完成阶段即可获得相应得分,即使未完全达成目标,关键步骤的推进也会被记录。这种双指标体系(成功率+进度得分)能更细致地刻画模型表现,避免因单一标准掩盖算法进步。

在针对四种主流VLA模型的测试中,π0.5模型(经微调)在所有分位点上均显著优于其他模型,但其时序理解与软体物体操作能力仍存在短板。值得注意的是,该模型仅使用约50个示范样本并采用混合任务训练,部分任务表现甚至超越单任务微调版本,证明Table30的任务集难度分布均衡,能有效区分模型性能差异。

RoboChallenge的开放策略进一步推动技术共享。用户可从Hugging Face平台下载任务示范数据集,通过工具脚本转换为统一格式后开展训练。平台提供框架代码演示“观察-推理-停止”的完整交互逻辑,并配套模拟测试功能,确保模型在提交前能正常运行。评估结果发布后,研究者可通过专用查看器分析机器日志与视频,对评分存疑者可申请重新计算。这种透明化机制避免了“黑箱式”评测,促进社区内的公平竞争。

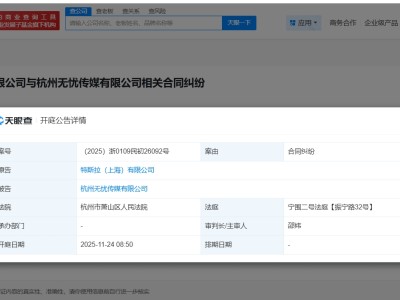

目前,RoboChallenge已建立标准化提交流程:用户选择通用型或微调型训练模式,通用型需用提示词区分任务并开展多任务联合训练,微调型则无特殊限制。提交时需注明密钥、任务集及模型名称,多任务提交将按通用模型处理。评估请求进入人工调度队列后,因场景布置需数小时至数日完成,结果默认公开以促进交流。

该平台的长期目标不仅是提供评测工具,更致力于构建协同创新社区。未来,RoboChallenge计划引入移动机器人、灵巧操作装置等更多硬件平台,拓展跨场景任务测试能力;评测维度将从视觉-动作协调延伸至多模态感知、人机协作等方向,并推出动态环境适应、长期规划等更具挑战性的基准测试。通过举办挑战赛、研讨会与数据共享活动,平台将鼓励研究者参与任务设计与优化,共同破解具身智能的核心难题。