在空间推理基准测试SpatialBench最新公布的榜单中,阿里旗下千问系列视觉理解模型展现出强劲实力。其Qwen3-VL与Qwen2.5-VL分别以13.5分和12.9分的成绩占据前两位,将Gemini 3.0 Pro Preview(9.6分)、GPT-5.1(7.5分)及Claude Sonnet 4.5等国际主流模型甩在身后。这一结果标志着国产大模型在多模态空间推理领域实现重要突破。

作为评估具身智能发展水平的关键指标,SpatialBench通过三维结构解析、路径规划、空间关系推理等复杂任务,检验模型处理抽象概念与实体空间映射的能力。测试不仅要求模型调用既有知识,更需在二维图像与三维场景中完成动态推理,这对机器人导航、工业自动化等现实场景具有直接指导意义。目前人类在该测试中的基准线约为80分,远超现有模型表现,显示技术仍存在显著提升空间。

此次登顶的Qwen3-VL于2025年正式开源,其前身Qwen2.5-VL则于2024年开放下载。新一代模型在视觉感知维度实现质的飞跃,通过32项核心能力评估全面超越Gemini2.5-Pro与GPT-5。该模型创新性地整合工具调用能力,可基于图像内容自动触发抠图、搜索等操作,甚至能通过设计草图或游戏视频直接生成可执行代码,实现"视觉编程"功能。

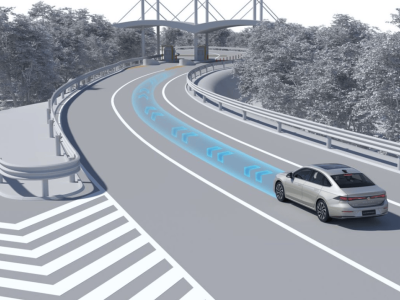

针对机器人场景的优化是Qwen3-VL的另一大亮点。通过强化3D空间检测模块,模型可精准识别物体方位、视角变化及遮挡关系。在实物抓取测试中,搭载该模型的机械臂能准确判断远处苹果的空间坐标,完成复杂环境下的精准操作。这种能力在仓储物流、精密制造等领域具有广阔应用前景。

为满足不同开发需求,Qwen3-VL同步开源多个版本,涵盖2B至235B参数规模,包含密集模型与混合专家(MoE)架构。每个版本均提供指令微调版与推理优化版,形成完整的产品矩阵。目前该系列模型已通过千问APP开放免费体验,开发者可直接调用API进行二次开发,企业用户则能基于开源代码部署定制化解决方案。

据技术文档披露,Qwen3-VL的训练数据集包含海量三维场景解析样本,其神经网络架构特别设计了空间注意力机制,使模型能像人类般建立"空间记忆"。这种设计显著提升了模型在动态环境中的推理稳定性,即使在部分遮挡或视角变化的情况下,仍能保持高精度识别。不过研发团队坦言,当前模型在处理微观分子结构或复杂电路布局时,仍需依赖专业工具辅助,距离完全替代人类专家尚有差距。