在CES 2026展会上,英伟达创始人兼CEO黄仁勋向全球科技界抛出一枚重磅炸弹——下一代AI计算平台Vera Rubin正式亮相。这位以"AI教父"著称的科技领袖,将"物理AI"定义为行业新范式,并宣布与西门子共建工业AI生态,同时推出具备自主决策能力的自动驾驶系统Alpamayo。这场被业界视为"技术宣言"的发布,标志着英伟达从预训练霸主向推理时代全面转型。

黄仁勋在演讲中直指行业痛点:当前AI推理面临模型规模年增十倍、计算路径从单次生成转向多步推理的双重挑战。据技术白皮书披露,Vera Rubin平台通过整合Vera CPU、Rubin GPU、NVLink 6交换机等六类核心组件,构建起全球首个异构计算矩阵。这种架构使十万亿参数模型训练所需的集群规模缩减至前代Blackwell系统的四分之一,在相同能耗下实现百倍计算吞吐量,将token生成成本压低至现有水平的十分之一。

技术突破背后暗藏博弈。英伟达推出的NVFP4自适应精度核心虽实现五倍推理性能跃升,却引发精度争议。AI系统架构师徐明指出,该技术通过压缩FP16/FP32计算资源来提升FP4吞吐量,在文生视频等精度敏感场景可能导致质量衰减。某大模型厂商的测试数据显示,当精度从FP16降至FP8时,五秒视频的生成瑕疵率已上升37%,这为技术落地蒙上阴影。

能源方案成为另一焦点。Rubin平台采用45℃温水冷却系统,宣称可降低全球数据中心6%的电力消耗。但深入分析发现,其液冷托盘进出液温差仅5℃,核心元件工作温度仍达80-90℃。某数据中心运营商透露,这种设计虽能提升能效比,但需要重构整个供电体系,单机柜功耗门槛将迫使运营商升级非标配电设施,初期部署成本可能增加40%以上。

行业格局正经历深刻重构。炜烨智算副总裁孟健雄认为,英伟达的转型打破"单芯片迭代"传统,转向系统级解决方案竞争,这为国产芯片开辟新赛道。IO资本创始合伙人赵占祥指出,国内已有12家芯片企业布局CXL存储技术,通过缩短GPU与存储距离提升推理性能。某存储厂商研发总监透露,其LPDDR6方案已实现纳秒级延迟,较传统HBM方案提升3倍带宽。

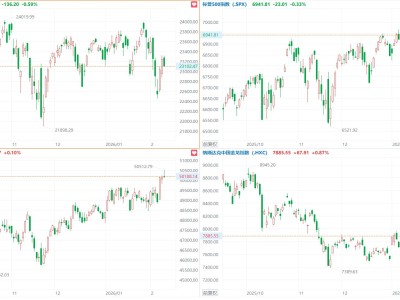

市场反应呈现两极分化。短期来看,英伟达凭借生态优势巩固高端市场,某云服务商透露已预订首批Rubin集群用于自动驾驶训练。但长期挑战不容忽视,某超算中心主任算了一笔账:要发挥Rubin全部性能,需同步升级机柜、供电、冷却三大系统,整体改造成本超过新建数据中心。这种"捆绑销售"策略正引发客户反弹,某互联网巨头CTO表示正在评估多供应商方案。

在这场算力革命中,技术路线之争愈发激烈。谷歌TPU团队被曝正在研发八芯协同架构,华为昇腾则推出动态精度调节专利技术。某半导体行业分析师指出,当单芯片制程逼近1nm物理极限,系统级创新将成为破局关键。这场由英伟达点燃的战火,正推动整个AI基础设施领域迈向全栈竞争时代。