国产GPU厂商曦望(Sunrise)在杭州举办的首届Sunrise GPU Summit上,发布了新一代推理GPU芯片启望S3,并同步推出面向大模型推理的超节点方案及推理云计划。这一动作标志着曦望在完成近一年约30亿元战略融资后,首次系统性展示其技术路线与产品布局,为国产GPU产业从“参数竞争”转向“成本竞争”提供了新范式。

与传统GPU厂商聚焦“训推一体”不同,曦望选择了一条差异化路径:启望S3不追求峰值训练性能,而是将全部资源投入推理效率与单位成本优化。曦望联席CEO王勇在发布会上指出,大模型产业正从训练主导转向推理主导,GPU的商业价值将取决于单位Token的真实成本,而非参数指标。这一判断直接影响了芯片设计逻辑——启望S3围绕真实推理负载,对算力结构、存储体系和互联方式进行系统性重构。

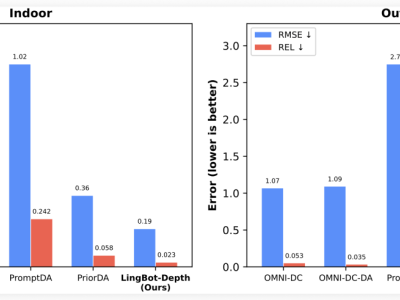

在算力设计上,启望S3支持从FP16到FP4的多精度灵活切换,通过低精度推理效率最大化释放算力潜力,精准匹配MoE(混合专家模型)和长上下文模型在推理阶段的实际需求。存储方面,该芯片采用LPDDR6显存方案,成为国内首款搭载该技术的GPU,显存容量较上一代提升4倍,有效缓解了大模型推理中的显存驻留与访存瓶颈。官方数据显示,在DeepSeek V3/R1等主流模型推理场景中,启望S3的单位Token成本较上一代下降约90%,且这一指标已通过工程验证,具备可复现性。

针对千亿、万亿级参数多模态MoE模型的部署需求,曦望同步推出寰望SC3超节点解决方案。该方案支持单域256卡一级互联,可高效支撑PD分离架构与大EP(Expert Parallelism)规模化部署,系统利用率与稳定性显著提升,适配长上下文、多并发、多专家并行等复杂推理场景。在交付形态上,寰望SC3采用全液冷设计,PUE(电源使用效率)表现极致,并支持模块化部署,将整体系统交付成本从行业常见的亿元级降至千万元级,降幅达一个数量级。

软件生态层面,曦望构建了与CUDA兼容的基础软件体系,覆盖驱动、运行时API、开发工具链、算子库和通信库,降低推理应用迁移门槛。目前,该体系已适配ModelScope平台90%以上主流大模型,包括DeepSeek、通义千问等,为开发者提供无缝切换的兼容性支持。

曦望的野心不止于芯片本身。通过与商汤科技、第四范式等生态伙伴合作,曦望探索推理云平台,试图解决“推理算力如何更好用”的问题。该平台通过GPU池化与弹性调度,将底层算力整合为统一推理池,并以MaaS(Model as a Service)模式向企业开放,用户无需关注硬件配置与集群运维,即可按需调用大模型推理能力。这一体系成为曦望“百万Token一分钱”推理成本合作的技术基础。

曦望董事长徐冰在会上强调,推理时代的核心是持续、稳定地将算力转化为可交付的生产力,而非单纯销售芯片。数据显示,2025年曦望推理GPU芯片交付量已突破1万片,标志着其路线从工程验证迈向规模化落地。中国工程院院士吴汉明指出,推理算力的价值实现需要芯片设计、系统集成、软件开发到产业应用的全链条协作,曦望的实践为国产GPU产业提供了重要参考。