字节跳动旗下豆包大模型完成2.0版本迭代,正式开启原生多模态智能体时代。此次升级以底层架构重构为核心,突破传统信息分发模式,转向任务处理型AI系统。相较于依赖插件组合的开源方案,新版本将多模态理解、可变长度逻辑推理及稳定工具调用能力深度整合至模型内核,形成更接近人类认知的智能处理机制。

在逻辑推理维度,该模型在数学运算与复杂任务拆解方面达到国际领先水平。其独特优势体现在真实场景中的稳定性:能自动构建任务因果链,进行多阶段规划,并在输出前完成结果验证。这种能力为智能体执行长链路任务提供了可靠支撑,有效避免传统模型常见的"前半程正确、后半程脱节"问题。

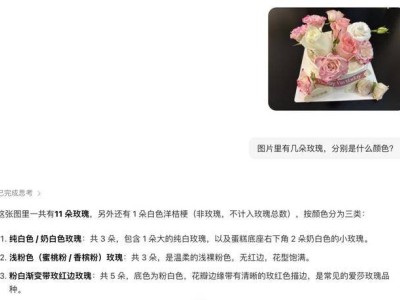

多模态感知能力的升级聚焦生产场景需求。模型重点优化了截图解析、图表分析、专业文档阅读等实用功能,突破传统视觉模型仅能识别基础元素的局限。通过增强空间关系理解与动态物体追踪能力,模型可精准判断视觉元素间的关联性与运动规律,为工业质检、流程监控等场景提供技术支撑。

任务执行层面,新版本实现三大突破:原生支持多技能协同调用、持续遵循多轮指令、保持结构化输出稳定性。在处理企业级长流程任务时,模型能自动拆解任务步骤、整合跨领域知识、维持上下文连贯性,并在最终输出环节确保格式规范。这种端到端执行能力显著提升自动化流程的可靠性,降低企业系统对接成本。

火山引擎作为技术落地平台,正将模型能力转化为标准化云服务。依托抖音、广告系统等内部业务积累的工程经验,该平台在推理调度、模型压缩、实时处理等环节形成独特优势。通过提供从算力到业务工具的全链条解决方案,火山引擎在视频、电商等高算力行业快速拓展客户,形成"场景密度-规模效应-成本优势"的良性循环。

定价策略凸显商业化考量。旗舰版豆包2.0 Pro(32k)输入成本降至3.2元/百万tokens,仅为国际同类产品的三分之一;轻量版Lite模型单价0.6元,性能却超越前代主力版本。这种阶梯式定价既满足不同规模企业的需求,也为大规模商用奠定基础。当模型调用量达到产业级规模时,云平台的稳定性与成本控制能力将成为决定市场竞争格局的关键因素。

技术迭代与商业布局的协同推进,折射出字节跳动构建AI产业闭环的战略意图。从底层模型优化到开发工具链完善,再到云端服务生态建设,每个环节都瞄准真实生产场景的需求痛点。这种系统化推进方式,正在重塑AI技术从实验室到产业应用的转化路径。