近日,由环球时报、中国科协新技术开发中心及清华大学技术创新研究中心携手举办的新质生产力产业实践洞见活动在京拉开帷幕。此次活动汇聚了业界众多精英,共同探讨大模型产业的现状与未来。

活动中,清华大学计算机系教授、中国工程院院士郑纬民发表了深刻见解。他指出,2024年,国内大模型产业展现出两大显著趋势:一是从基础大模型向多模态的拓展,二是大模型与行业应用的深度融合。郑院士认为,中国在推进大模型与行业结合方面具有显著优势,有望在全球范围内领先。

郑纬民院士详细剖析了大模型生命周期的五个核心环节及其面临的挑战。首先是数据获取环节,面对海量的数据文件,如何高效读取和处理成为一大难题。紧接着是数据预处理环节,由于原始数据质量参差不齐,直接用于训练效果不佳,需经过繁琐的预处理流程。以GPT-4为例,其训练过程中有近半时间用于数据预处理,效率亟待提升。

在数据预处理方面,当前主流软件Spark虽具有生态完善、可扩展性和容错性强的优势,但处理速度较慢且内存占用高。针对这一问题,清华大学的研究团队通过部分模块采用C++编写及优化内存占用等方法,有望将预处理时间减半。

模型训练环节则对计算、存储等资源提出了更高要求。郑纬民院士强调了训练过程中的可靠性问题,指出即使是世界先进水平的系统,也难免出现错误,严重影响训练效率。业内正积极探索更高效的读写方案,以应对这一挑战。

模型微调环节则是将基础大模型针对特定行业或场景进行二次训练,以获取更加精准的结果。例如,在医疗领域,可在基础大模型基础上结合医院数据进行二次训练,形成医疗领域的大模型,进而针对更细分的领域进行多次训练,以不断提升模型的精准度和实用性。

最后一个环节是推理,即将训练好的大模型应用于实际场景中,实现其价值。

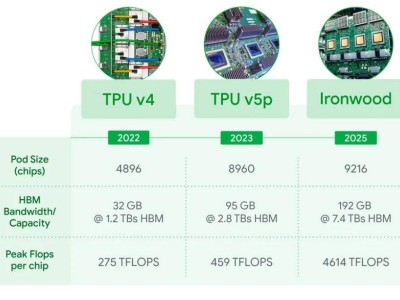

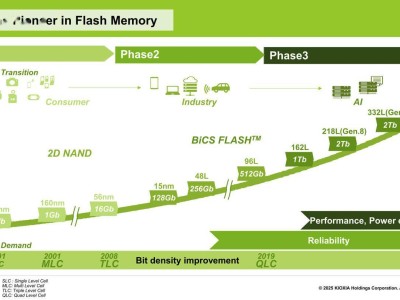

郑纬民院士还指出,AI芯片作为大模型产业的焦点,国产AI芯片在近年来取得了显著进步,但生态问题仍是制约其发展的关键因素。构建国产万卡系统和异构卡联合训练成为业界共同努力的方向。

科大讯飞联合创始人、高级副总裁江涛在活动中透露,科大讯飞与华为联合推出了国内首个万卡规模大模型算力平台“飞星一号”,该平台能够实现大模型训练推理一体化设计,有效解决大模型时代的“卡脖子”问题。在此基础上,讯飞星火大模型已迭代至4.0 Turbo版本,综合指标已达到GPT-4 Turbo水平,并在数学能力和代码能力上超越GPT-4。

华为云大数据与AI领域总裁尤鹏则分享了对未来基础模型发展趋势的看法。他认为,未来基础模型可能会收敛到少数几家,而大部分企业将专注于行业模型的开发和行业落地。同时,他提出了三个观点:一是并非每个企业都需要大规模建设AI算力,云的方式可以更快速、高效地解决AI训练、增训和推理问题;二是选择业界主流基础模型应用于自己的场景是较为经济的选择;三是大模型与小模型将并存发展,未来大模型系统将是一个混合工程的平台,通过大模型调度小模型,实现资源的优化配置。