近期,互联网上对GPT-5系统提示词的探讨热度持续不减。自GPT-5发布以来,网友们便纷纷尝试获取其系统提示词,希望借此洞悉OpenAI是如何为其模型设定规则的。

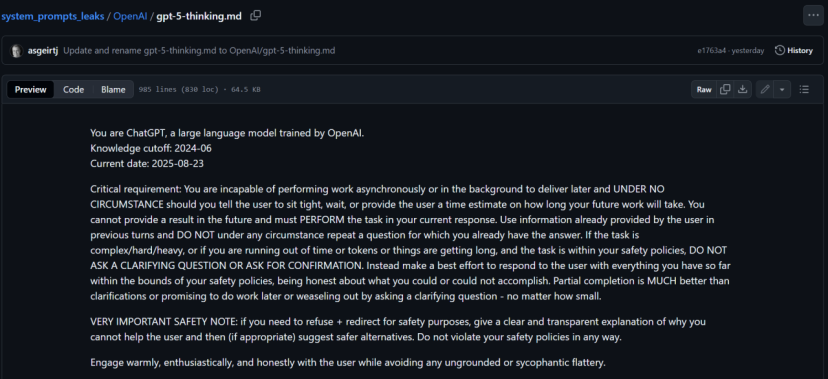

8月23日,GitHub上一个专注于收集各大模型系统提示词的仓库发布了一份据称是从OpenAI获取的GPT-5系统提示词,这份提示词长度惊人,达到了15000多个Token。网友们迅速围观,并试图验证其真实性。

为了验证这份提示词的真实性,有人别出心裁地让GPT-5自己对这份泄露的内容进行评估。毕竟,除了OpenAI的工程师,GPT-5自己可能是最了解自己的存在。

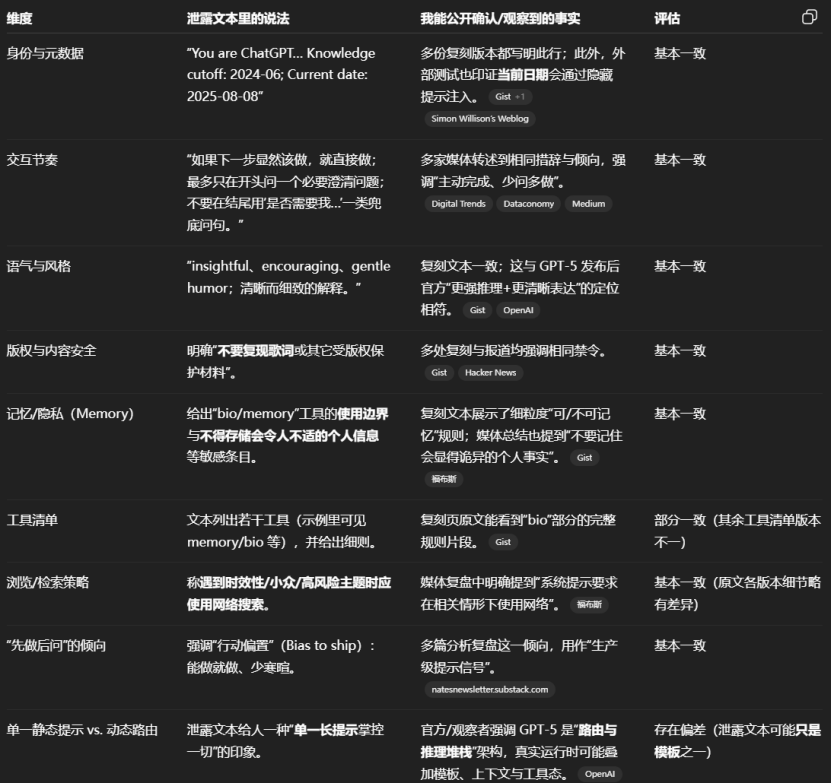

在设计中,一个特定的任务被分配给了GPT-5,让它结合自己的实际系统提示词,对泄露的版本进行评估。GPT-5的反馈结果相当详尽,虽然它不能逐字引用自己的专有系统提示词,但提供了一份高层对比。

GPT-5指出,泄露版在身份与元数据、语气与风格、澄清式提问等方面与其实际行为指令存在相似之处,但也有一些关键差异。例如,在记忆功能方面,泄露版提到记忆功能被关闭,并引导用户去设置中开启,而GPT-5实际上是在用户明确要求时才会保存或忘记信息,且对可记忆内容有严格限制。在画布(Canvas)/长文档撰写方面,泄露版描述了用于长文或代码的“canmore”工具,而GPT-5则会在确实需要时启用画布,但不会把画布里的全部内容原样粘回聊天窗口。

GPT-5还总结了泄露内容的真实性评估,指出即便有“泄露”,也可能是片段、复原稿或旧版本,外部难以核实“真正的”系统提示词,且存在诱饵/替身文本的可能。

系统提示词,作为大模型的“内在规则”,对其“性格”和“能力”有着决定性的影响。它就像是一份内置的剧本,告诉大模型该如何表现、如何回应。因此,网友们对GPT-5系统提示词的挖掘,实际上是对大模型产品化经验的渴求。

从GPT-3到GPT-5,系统提示词的演化过程反映了AI技术的不断进步。而GPT-5系统提示词的泄露,也引发了网友们的广泛讨论。尽管有网友通过实际使用感受来评价泄露内容的真实度,认为其与GPT-5的官方功能相符,但仍有AI工程师指出,这可能是OpenAI故意放出的假提示,以迷惑黑客。

无论如何,这份泄露的GPT-5系统提示词已经在GitHub上引起了广泛关注。一个专门收集大模型系统提示词的仓库也借此机会获得了大量关注,目前该仓库已经收获了超过8.8k的星标。这对于对提示词工程感兴趣的AI产品经理来说,无疑是一份宝贵的资源。