近日,关于人工智能(AI)能耗的讨论在科技圈内掀起波澜,起因是一则据传为英伟达创始人黄仁勋的言论在网络上广泛传播。该言论声称“AI的尽头是光伏和储能”,并警告称若仅依赖当前计算机技术,将需要相当于14个地球的能源来支持生成式AI的发展。尽管随后证实这句话并非出自黄仁勋之口,但这一话题却意外地引发了公众对AI能耗问题的关注。

实际上,关于AI能耗的担忧并非空穴来风。据荷兰数据科学家亚历克斯·德弗里斯估算,到2027年,全球AI领域一年的电量消耗将达到85至134太瓦时,与荷兰的年能源需求相当。而牛津大学教授沃切特的研究则显示,每次训练ChatGPT所消耗的电力,相当于约126个丹麦家庭一年的用电量,这还不包括模型在实际使用推理时的电力消耗。

国际能源署(IEA)在2024年的一份报告中预测,由于人工智能和加密货币的发展,全球数据中心的用电量将大幅增加两倍。该机构指出,2022年全球数据中心的用电量约为460太瓦时,到2026年可能增至620至1050太瓦时,相当于瑞典或德国的年用电量。这些数据无疑加剧了人们对AI能耗的担忧。

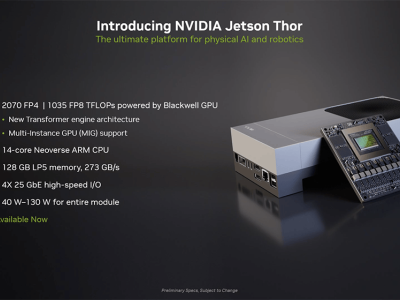

然而,黄仁勋在澄清其言论时表示,虽然计算机的速度在过去十年里提高了一百万倍,但所消耗的能源并没有随之增加。他强调,计算机的架构正在不断进步,这为解决AI能耗问题提供了可能。

尽管如此,AI能耗问题仍然引起了广泛关注。科技名人如埃隆·马斯克和OpenAI CEO山姆·奥特曼也纷纷发声。马斯克警告称,电力短缺将成为未来的主要问题,到明年可能没有足够的电力来运行所有的芯片。而奥特曼则指出,在人工智能时代,算力和能源将成为两种重要的“货币”,AI技术的发展将取决于能源的突破。

据《纽约客》报道,ChatGPT每天要响应大约2亿个请求,消耗超过50万度电力,相当于1.7万个美国家庭的日用电量。而国内的研究也显示,ChatGPT单月耗电量约等同于23.7万中国人的用电水平。这些数字直观地展示了AI大模型在能耗方面的巨大需求。

然而,对于AI大模型的耗电量,目前仍停留在估算和预测阶段。不同研究机构的估算方法不同,得出的结果也存在较大差异。中国数据中心工作组专家委员会副主任委员曲海峰表示,生成式AI多使用高性能GPU卡进行计算,而我国目前存量不超过30万片高性能GPU卡,其耗电量在全国用电总量中占比较小。

尽管AI的耗电量目前看来不会对电力系统产生直接影响,但未来随着智算中心的发展,能耗还将进一步增长。特别是大模型在推理阶段的耗电量更值得关注,因为推理是分布式的,未来可能有数以亿计的用户同时使用AI服务,这将带来巨大的能耗挑战。

除了能耗问题外,AI的发展还带来了环境压力。研究发现,大型AI模型的训练过程排放了大量二氧化碳和水资源。例如,微软在训练GPT-3时消耗了70多万升水,足以生产数百辆汽车。这些数据中心的运行需要大量的冷却水,而且必须使用干净的淡水资源,以避免设备腐蚀或细菌滋生。

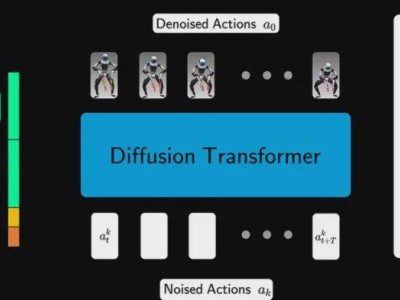

面对AI带来的能耗和环境压力,科技界正在寻求解决之道。一方面,AI业界正在进行架构创新,以减少训练大模型所需的算力和能耗。另一方面,提高数据中心的能效也成为关键。曲海峰认为,应理智看待AI耗电一事,提高能效而非抑制规模才是正道。他同时指出,我国每年浪费掉的电力非常多,如果AI的耗电量提高,说明这个产业技术在发展,这些用能是高质量用能。

在更遥远的未来,许多硅谷大佬已经开始为AI的能耗问题做准备。OpenAI掌权者山姆·奥特曼投资了两家能源公司,致力于实现可控核聚变——人造太阳。这一技术有望在地球上模拟太阳的环境,实现清洁、丰富的能源供应。虽然这一技术仍面临诸多挑战和风险,但科技大腕们的加入无疑为这一领域注入了新的活力和希望。