苹果公司在AI领域的最新动作引发了广泛关注。近日,苹果在HuggingFace平台上全面开源了两款视觉语言模型——FastVLM和MobileCLIP2,这两款模型以惊人的处理速度成为了业界的焦点。

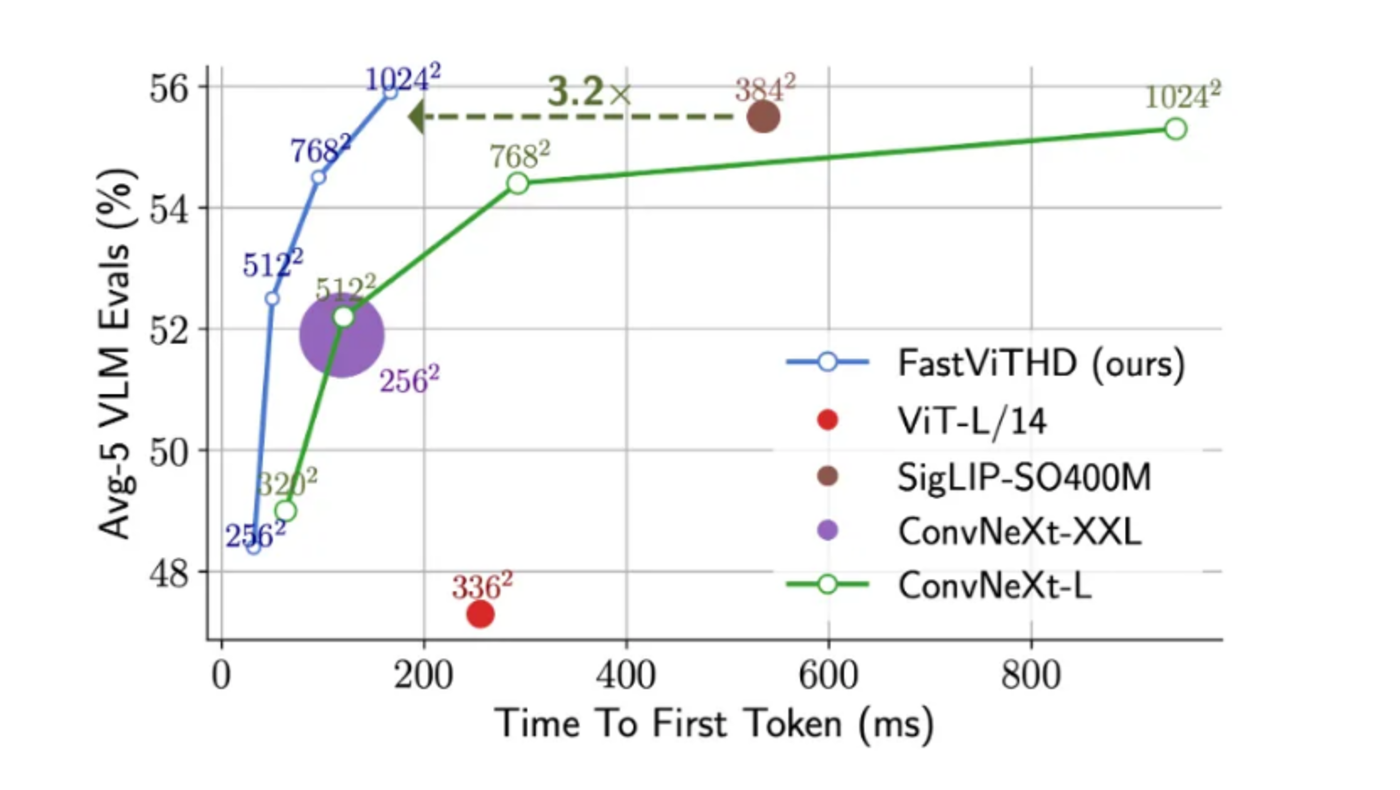

FastVLM模型的最大亮点在于其极快的响应速度。相较于同类模型,FastVLM在部分任务上的响应速度快了85倍,甚至能在iPhone等个人设备上流畅运行。这一突破性的表现得益于其新型混合视觉编码器FastViTHD,该编码器能够输出更少的token,并显著缩短高分辨率图像的编码时间。

传统的视觉模型在处理高分辨率图片时,会将其分解成众多小块并转化为token,这一过程会产生大量数据,给后续的语言模型带来巨大计算压力。而FastVLM的混合视觉编码器结合了卷积网络和Transformer技术,能够在不牺牲关键视觉信息的前提下,输出更少但更精华的token,从而实现了速度与性能的平衡。

FastVLM的多尺寸版本,包括0.5B、1.5B和7B等,已经上线并支持试用。用户可以通过HuggingFace平台体验其强大的功能。据实际测试,FastVLM在处理视频时表现出色,单帧画面的分析时间仅需1-2秒,能够迅速提取并解读关键帧。

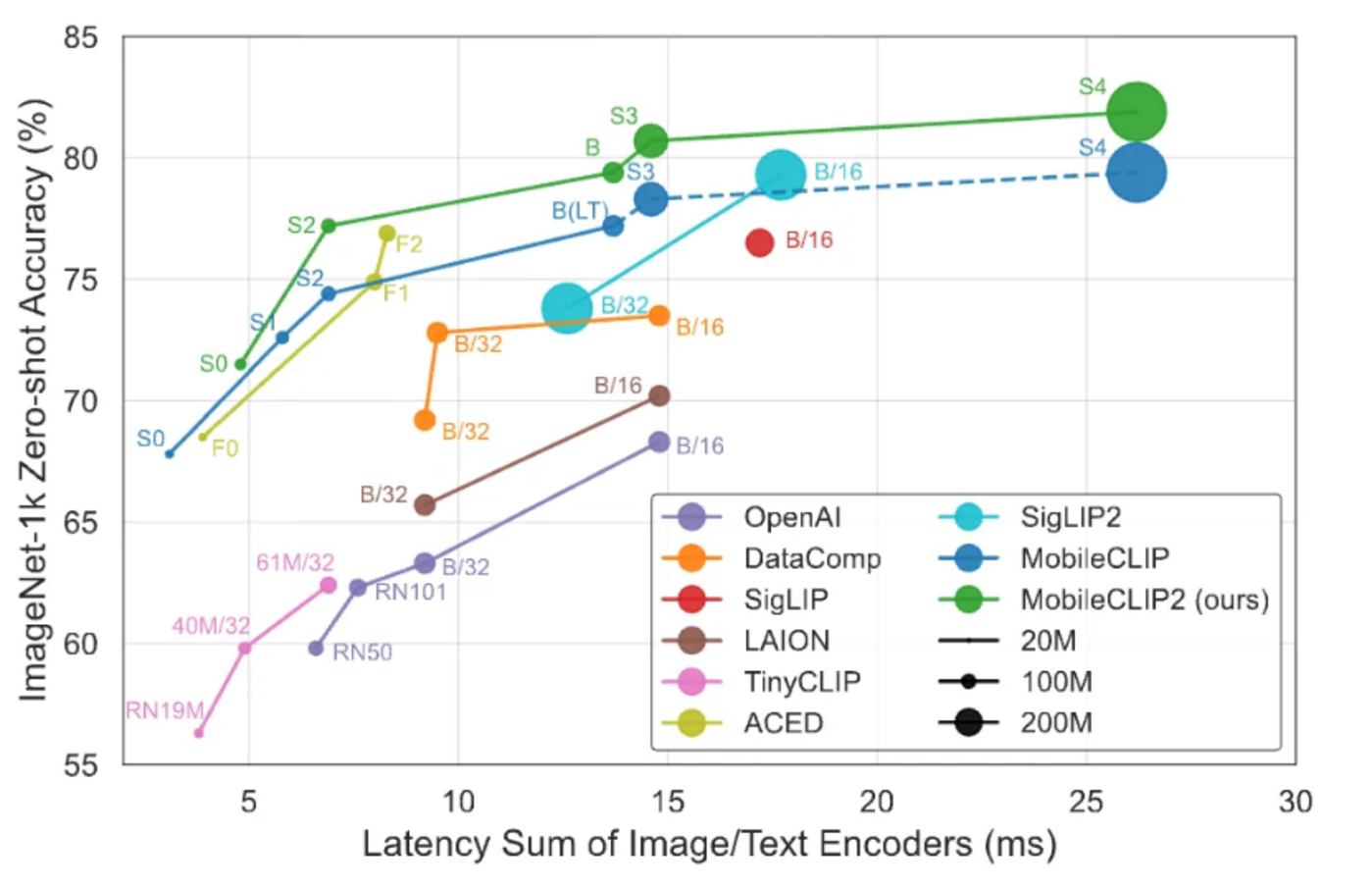

除了FastVLM外,苹果还开源了另一款图像-文本模型MobileCLIP2。该模型同样专注于在移动设备上实现低延迟与高准确度的平衡,通过多模态强化训练构建,旨在快速响应并保持优良性能。

这两款模型的开源并非孤立的技术展示,而是苹果“端侧AI小模型战略”的关键一环。在AI浪潮中,苹果曾因其在大模型方面的进展缓慢而备受质疑。然而,苹果CEO蒂姆·库克在全员大会上明确表示,苹果已经在这方面投入了巨额资金,并将推出一系列令人兴奋的AI计划。

事实上,苹果在过去一年里不断在小模型方向作出努力。例如,苹果曾在Hugging Face上发布DCLM-7B开源模型,其性能已经逼近甚至超越了当时的一些同级别同尺寸模型。在WWDC 2024上,苹果宣布其Apple Intelligence并非单一的云端模型,而是由多个功能强大、各司其职的AI小模型组成的矩阵。

苹果选择回归设备,推进端侧AI小模型战略,背后有着深刻的商业考量。首先,隐私保护是苹果的核心价值观之一。将AI计算留在设备端,可以避免用户数据被上传到云端,从而保护用户的隐私。其次,用户体验一直是苹果产品的核心竞争力,端侧AI能够确保流畅的体验,不受网络状况的制约。从性能和经济角度来看,利用设备上强大的A系列/M系列芯片进行AI计算,对苹果来说是最经济、也最可持续的商业模式。