去年7月,由于DeepSeek下载量从高峰期的8000多万暴跌至2000多万,下滑72.2%,“DeepSeek跌落神坛”就成为了当时互联网最热门的话题。

但据多位知情人士透露,DeepSeek即将重登王座。他们计划在二月中旬发布新一代模型DeepSeek-V4。

也就是农历2026年新年期间,距离上一代模型DeepSeek-R1的发布正好一年。

这次发布的重点是代码生成和处理能力。

根据DeepSeek内部的基准测试,V4在编程任务上的表现超过了目前市场上的主流竞品,包括Anthropic的Claude和OpenAI的GPT系列。

根据报道,在即将发布的新模型中,DeepSeek团队解决了许多长期困扰AI发展的技术难题。很可能会彻底改变Vibe Coding产业。

01

报道中提到一件事,“DeepSeek-V4模型在整个训练过程中理解数据模式的能力也有所改进,且性能未出现衰减。”

这句话有些难以理解,我们不妨拆开来解读。

首先是前半句,它指的是模型不再只是死记硬背数据,而是能看透数据背后的规律和逻辑。

DeepSeek-R1有个具代表性的例子,就是让模型数strawberry里有几个r。

由于当时的DeepSeek模型并不能理解“数”(count)这个概念,只能根据训练时的数据来输出答案。可这个数据恰好又是错的,所以无论DeepSeek怎么思考,它给出的答案大多数情况都是2,而不是正确的3。

而DeepSeek-V4则会彻底杜绝这个情况,前提是在训练过程中,让模型彻底理解某一件事情。

后半句的性能退化,指的是在AI训练中,随着模型不断学习新东西或训练时间加长,往往会出现“学了新的忘了旧的”或者模型变得不稳定的情况。

这种现象在业内被称为“灾难性遗忘”(Catastrophic Forgetting)或“模型坍塌”(Model Collapse)。

因此,V4在不断变聪明、变复杂的过程中,依然保持了极高的稳定性和原有能力的完整性,没有出现任何“副作用”或能力倒退。

这恰恰是构建编程Agent的前置条件。

在现代软件工程中,一个微小的修改可能波及数个文件、数千行代码的依赖关系。

但是以往的模型往往受限于上下文窗口或注意力机制的衰减,从而没办法对于庞大的项目进行修改。

V4极有可能是一个为“Agent时代”量身定制的模型。

一年前,DeepSeek-R1 的发布确实在行业内引起了不小的波动。那款主打推理能力的模型证明了低成本研发路径的可行性。

然而一年后的今天,人工智能行业的关注焦点已经发生了显著转移。单纯的文本生成或逻辑推理已不再是唯一的竞争高地,代码生成正在演变为大模型能力的“试金石”。

在当前的开发环境中,“Vibe Coding”成为新趋势,要求AI不仅能补全代码,更能理解开发者的意图流(Flow),实现从自然语言到复杂工程逻辑的无缝转化。

DeepSeek似乎已经准备好在新赛道上狂飙了。

02

如果深入梳理DeepSeek团队以及核心人物梁文锋在R1发布之后这一年里的学术轨迹,我们会发现一条清晰且扎实的技术演进路线。

这些公开发表的论文与技术报告,不仅是对过去成果的总结,更是V4强大能力的注脚与预演。

2025年9月,DeepSeek-R1的相关论文成功登上了顶级学术期刊《Nature》的封面,梁文锋署名通讯作者。

面对审稿人关于是否使用了OpenAI模型输出进行蒸馏训练的尖锐质疑,DeepSeek团队在回应中给出了明确的否认,并首次公开了令人咋舌的低成本数据:从V3-Base训练到R1,仅花费了29.4万美元。

当然,这个成本仅指R1的后训练阶段成本,不包含V3-Base基础模型本身约600万美元的训练投入。

数据公开后,以及《Nature》为此专门撰写的社论,标志着DeepSeek在学术严谨性和技术原创性上获得了国际最高认可,彻底洗刷了外界对于中国大模型“套壳”或“跟随”的刻板印象。

不过,真正能佐证DeepSeek-V4在代码方面有大幅突破的证据,是2025年最后一天,DeepSeek团队发表的论文《mHC:流形约束超连接》。

代码生成任务对模型的逻辑深度和上下文跨度有着极高的要求,这通常需要更大规模的模型参数和更深的网络结构。

然而,传统的超连接(Hyper-Connections)架构在模型规模扩大时,会面临严重的信号增益问题,最终导致训练过程极不稳定甚至崩溃。

为了解决这一阻碍模型扩容的根本性物理难题,DeepSeek团队在这篇论文中提出了一种全新的架构mHC。

简单来说,它给狂奔的信号加了一道精密的阀门,将信号增益严格控制在1.6倍左右。

论文数据显示,在3B、9B乃至18B参数规模的模型测试中,应用了mHC架构的模型在BIG-BenchHard推理基准上提升了2.1%。

这项由梁文锋联合署名的研究成果,实际上解决了大模型在“做大”和“做复杂”过程中的稳定性难题。

这意味着V4模型极有可能采用了这种全新的架构,从而在拥有更庞大参数量和更深层推理能力的同时,依然保持了高效的训练效率和极高的稳定性。

不仅如此,在2026年1月初,DeepSeek悄无声息地将arXiV上的R1论文从原本的22页大幅扩充至86页。

这多出来的60多页内容,详尽地披露了R1的完整训练管线,包括冷启动、推理导向的强化学习(RL)、拒绝采样与再微调、以及对齐导向的强化学习这四个关键步骤。

业界普遍推测,这种在春节前夕“清库存”式的技术披露,往往预示着下一代更强大的技术已经成熟。

既然R1的技术细节已经不再是核心壁垒,那么即将到来的V4必然拥有了更高维度的护城河。

03

就在2026年的元旦,另一股来自量化界的力量也加入了战局。

由九坤投资创始团队发起成立的至知创新研究院(IQuestResearch),发布了名为IQuest-Coder-V1的开源代码大模型。我们曾在文章《又是量化基金,第二个DeepSeek时刻到来了?》中对其进行了报道。

这支同样出身于量化背景的团队,他们仅有40B参数的模型,在SWE-benchVerified测试中斩获了81.4%的高分,一举达到了Claude和ChatGPT的水平。

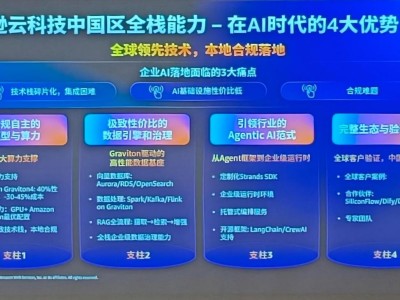

而在Vibe Coding的战场上,国内互联网大厂的动作同样不容小觑。

字节跳动的豆包在2025年初就推出了Trae编程工具,并在AI编程功能上实现了HTML预览、Python运行和完整项目生成等能力,让开发者可以在一个界面内完成从构思到部署的全流程。

阿里的通义千问则在12月26日更新到了Qwen Code v0.5.0版本。

此次更新的最大亮点就是支持在终端窗口中同时运行四个Qwen Code实例,可并行处理智能问答、实时翻译、原型设计、创意绘图等不同任务,实现了AI编程“跳出命令行”的突破。

不过,真正引发行业震动的,是豆包在硬件终端上的突破性尝试。

2025年12月1日,字节跳动与中兴通讯合作推出了搭载豆包手机助手的努比亚M153工程样机,售价3499元,首批约3万台在当天迅速售罄,甚至在二手市场炒出了高价。

这款手机助手的核心能力在于跨应用操作。用户只需用自然语言下达指令,AI就能自动跳转多个应用完成点外卖、订机票、比价购物等复杂任务。

这一系列动作背后,折射出的是AI大模型从云端走向终端、从工具走向入口的战略转型。

说不定DeepSeek手机也不远了。

与此同时,资本市场也迎来了大模型行业的收获季。

曾经历过“百模大战”喧嚣的中国AI行业,正在加速向头部收敛。智谱AI和MiniMax这两家公司均已成功上市。

智谱是1月8日在港交所敲的钟,发行价定在116.2港元/股,上市第一天就给了市场一个惊喜 —— 开盘120港元,收盘131.5港元,第一天就涨了13.17%,市值一下子冲到578.9亿港元,成了 “全球大模型第一股”。

第二天开盘直接137.2港元起,收盘158.6港元,较首日收盘价又涨了20.6%,市值也跟着涨到698.21亿港元,两天下来从发行价算已经涨了快37%,完全没给空头机会。

MiniMax比智谱晚一天,但风头更劲。发行价165港元/股,而且是顶格定价,上市前一天的暗盘就已经涨了25%-29%,报205.60-212.60港元。

上市当天开盘235.4港元,涨了42.7%,之后一路飙升,盘中最高到351.8港元,最终收盘345港元,较发行价暴涨 109.09%,市值来到1054亿港元,成了千亿市值俱乐部新成员。

虽然高额的研发投入使得两家公司目前仍处于亏损状态,但强劲的增长曲线证明了市场对于高质量AI模型的付费意愿正在形成。

中国AI方兴未艾,但当全球目光已经再次聚焦到DeepSeek身上。一年前那个用低成本路径颠覆行业认知的团队,即将在春节期间交出新的答卷。

DeepSeek能否第二次“震惊全世界”,只要再等几天就会知晓。