在深度学习领域,残差连接自2016年ResNet架构问世以来,始终是支撑大规模神经网络训练的核心设计。这种通过"捷径通道"绕过非线性变换的机制,有效缓解了梯度消失问题,使模型层数得以突破性增长。然而,随着模型规模持续扩大,传统残差架构的局限性逐渐显现,特别是在硬件资源受限的场景下,信号传播稳定性成为制约技术突破的关键瓶颈。

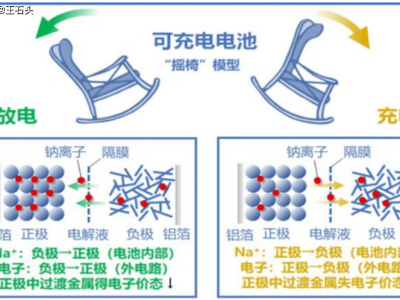

字节跳动于2024年推出的超连接(HyperConnection)技术,通过拓宽残差流宽度并构建多路并行信号通道,在模型表达能力上取得显著提升。但DeepSeek团队的实证研究揭示,该技术在270亿参数规模训练中,约12000步后会出现梯度范数剧烈波动,第60层信号强度竟膨胀至输入值的3000倍。这种信号发散现象源于超连接架构放弃了残差连接原有的恒等映射约束,导致大规模训练时误差累积失控。

针对这一难题,DeepSeek提出的流形约束超连接(mHC)架构引入双重随机矩阵理论,为信号传播设立严格的数学边界。该架构要求变换矩阵的每行每列元素之和均为1且非负,确保输出信号强度始终介于输入信号的最大最小值之间。实验数据显示,在相同训练条件下,mHC架构的信号放大峰值被控制在1.6倍以内,较超连接架构的3000倍形成质的飞跃。

在计算效率优化方面,DeepSeek团队开发了基于Sinkhorn-Knopp迭代的投影算法,仅需20轮迭代即可实现矩阵约束收敛,将额外训练成本压制在6.7%以内。配合算子融合、反向传播重计算和流水线并行优化三项关键技术,成功将内存开销从随层数线性增长转化为由模块大小控制的有界增长。这种系统级优化使30亿至270亿参数模型在搭载mHC架构后,均展现出稳定的性能提升。

基准测试结果表明,270亿参数模型在BIG-Bench Hard复杂推理任务中准确率提升2.1%,在DROP阅读理解任务中提升2.3%。更值得关注的是,这种性能增益建立在不依赖尖端算力芯片的基础之上。通过将bfloat16混合精度内核与TileLang编程框架深度结合,DeepSeek在A800/A100等主流硬件上实现了全参数规模的稳定训练。

在技术发布策略上,DeepSeek选择通过arXiv和Hugging Face等开放平台率先公开研究成果,这种做法虽与传统学术期刊路径不同,却显著提升了技术扩散速度。开放源代码和可复现的实验数据,迫使国际同行必须直面中国团队提出的数学约束方案,要么跟进类似技术路线,要么证明自身路径的优越性。这种竞争态势正在重塑全球AI研发的生态格局。

回顾技术演进脉络,字节跳动与DeepSeek的连续突破形成有趣对照:前者率先打破残差连接的"静默稳定",后者则在硬件约束下完成系统性补位。这种接力式创新印证了产业界对技术瓶颈的认知深化——当算力增长遭遇物理极限时,数学原理的深度挖掘与系统工程的精密优化,将成为突破困境的关键路径。

随着2026年春节临近,业界普遍预期DeepSeek将发布搭载mHC架构的R2旗舰模型。无论基准测试结果如何,这种"在约束中创新"的研发模式已展现独特价值。它证明AI竞赛并非只有"堆砌算力"的单选项,硬件限制反而可能成为催生核心突破的催化剂。当西方实验室仍在争论模型规模与能效比时,中国团队已通过数学创新开辟出新的技术赛道。