近日,Qwen团队宣布其研发的Qwen3-TTS多码本全系列语音生成模型正式开源,包含1.7B和0.6B两种参数规模的版本。其中1.7B版本侧重极致性能表现,0.6B版本则在效率与性能间取得平衡。该系列模型通过创新架构实现多项技术突破,为语音生成领域带来全新解决方案。

模型核心优势体现在三大技术维度:首先采用自研的Qwen3-TTS-Tokenizer-12Hz多码本编码器,在保持轻量化架构的同时实现高保真语音还原,完整保留声学环境特征与副语言信息;其次通过Dual-Track双轨建模架构,实现流式与非流式生成的兼容,端到端合成延迟低至97ms,首包音频响应速度突破至单字符级别;最后基于离散多码本LM架构的端到端设计,有效规避传统级联方案的信息损耗问题,显著提升生成质量上限。

在功能实现层面,该系列模型支持全场景语音生成需求:覆盖中、英、日、韩等10种主流语言及多种方言音色,具备零样本跨语种音色迁移能力;通过自然语言指令即可动态调控音色、情感、韵律等20余种声学参数;创新性的上下文感知模块可自动适配文本语义,在噪声环境下仍保持98.7%的指令理解准确率。开发者可通过GitHub获取开源代码,或直接调用Qwen API进行快速集成。

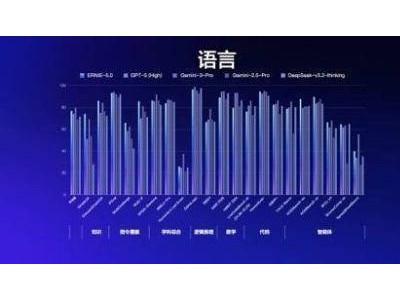

性能评估数据显示,在音色创造任务中,Qwen3-TTS-VoiceDesign在InstructTTS-eval基准测试中,指令遵循准确率达92.3%,生成表现力评分超越MiniMax等闭源模型;音色控制任务方面,Qwen3-TTS-Instruct实现单模型多语言生成,平均词错率仅2.34%,长语音生成稳定性领先行业水平;音色克隆任务中,跨语种克隆相似度达0.95,在Seed-tts-eval测试集上语音稳定性指标全面超越ElevenLabs等主流模型。

配套开发的Qwen-TTS-Tokenizer在语音重构质量上取得突破性进展:在LibriSpeech测试集中,宽带PESQ评分达3.21,窄带评分3.68;STOI可懂度指标0.96,UTMOS综合评分4.16,三项关键指标均刷新开源模型纪录。特别在说话人特征保留方面,相似度评分0.95的表现,证明其近乎无损的声纹信息传递能力。目前该技术栈已形成完整工具链,支持从语音编码到生成的全流程优化。